Bereiten Sie den Weg für das Ranking Ihrer Dienstleistungen in LLMs

Veröffentlicht: 2024-01-06Angesichts der jüngsten Entwicklungen bei KI und LLM (Large Language Models) können wir die Auswirkungen, die dies auf die Art und Weise haben wird, wie Menschen Suchmaschinen nutzen und SEO verstehen, nicht unterdrücken.

Obwohl das traditionelle Page-Rank-Modell zur Klassifizierung von Backlinks und der Wertigkeit von Websites, das ursprünglich von Google entwickelt wurde, 1996 ein großer Durchbruch war, hat sich an der Grundlage für die Bewertung von Websites nicht viel geändert, abgesehen von anderen weniger wichtigen, aber immer noch relevanten Faktoren, die Websites beeinflussen ihre entsprechenden Suchanfrage-Rankings in Suchmaschinen.

LLMs, insbesondere GPT an vorderster Front, haben begonnen, diese traditionellen Modelle in Frage zu stellen und bieten Benutzern neue Möglichkeiten für die Suche nach Informationen. Die Verwendung von ChatGPT zum Abrufen bestimmter Fakten oder Informationen erfordert deutlich weniger Zeit und Klicks, und oft sind diese Informationen repräsentativer für objektive Fakten, da die Natur von LLMs darin besteht, große Informationsmengen zu „verbrauchen“.

Dies macht LLMs nicht nur sehr praktisch, um Gedichte zu schreiben, zu programmieren und Reisepläne vorzubereiten, sondern auch, um tatsächlich zahlreiche nützliche Informationssuchen bereitzustellen.

Schauen wir uns einige Beispiele an, wie Menschen gelernt haben, LLMs und GPT zu nutzen, um schnell und effizient Antworten auf gezielte Fragen zu erhalten, und was dies für die Zukunft von SEO bedeuten könnte.

LLMs in der Praxis

Wir fragten ChatGPT: „Welche Websites sind hinsichtlich Preis, Genauigkeit und Kundenservice die zuverlässigsten für die Suche und den Vergleich von Flügen?“

GPT hat alle Optionen übersichtlich aufgelistet, mit einer kurzen Zusammenfassung jedes Dienstes. Angesichts der Effizienz dieses Ansatzes, der nicht nur Zeit spart, sondern vor allem auch voreingenommene Meinungen von Bewertungsseiten umgeht, wenden sich Benutzer zunehmend an GPT, um an Informationen zu gelangen.

Damit erschließen wir ein neues Feld der Informationsoptimierung, das – ähnlich wie SEO – Techniken und Ansätze umfasst, um die Fragen zu verstehen, mit denen unsere potenziellen Interessenten und Nutzer nach Lösungen für Probleme suchen, die unsere Produkte oder Dienstleistungen lösen.

Diese aufstrebende Disziplin – wir könnten sie LLMO (Large Language Model Optimization) nennen – konzentriert sich auf Möglichkeiten, unsere Position zu optimieren, damit diese Abfragen relevanter und sichtbarer werden und einen höheren Rang einnehmen.

In den folgenden Abschnitten werden wir tiefer darauf eingehen, wie sich diese GPT-Fragen von den Suchanfragen unterscheiden, die Benutzer in Suchmaschinen stellen, warum wir uns um sie kümmern sollten und wie wir uns auf die Optimierung vorbereiten sollten, um diese Innovation für das Wachstum unseres Unternehmens zu nutzen bzw. zu nutzen Dienstleistungen und Produkte unserer Kunden.

Warum sich Nutzer lieber an ChatGPT wenden

Diese Verlagerung von der Verwendung einer herkömmlichen Suchmaschine hin zum Richten Ihrer Frage an ChatGPT ist kein neuer Trend, sondern eine direkte Reaktion auf seine Vorteile. Einige der Hauptgründe, warum Benutzer GPT-Retourenantworten eher auf ihre Anforderungen abgestimmt finden, sind folgende:

- Umfassend und informativ. Während Suchmaschinen eine Liste mit Links zu Websites zurückgeben, die der Benutzer manuell durchsuchen muss, ist GPT in der Lage, Text zu generieren, der seine Anfrage direkt beantwortet. Dies ist besonders hilfreich für Benutzer, die eine schnelle und ausführliche Antwort suchen, ohne unbedingt die Zeit oder Fähigkeit zu haben, eine Reihe von Links aus den Ergebnissen der ersten Seite zu öffnen und zu lesen.

- Objektiv und unvoreingenommen . Herkömmliche Suchmaschinenergebnisse können durch einige Faktoren beeinflusst werden, die möglicherweise nicht für alle eindeutig verfügbar sind – etwa das Budget einer Website, das sie für den Kauf von Links ausgeben kann, oder andere zweifelhafte Strategien, die ihnen zu einem höheren Ranking verhelfen sollen. LLMs hingegen werden anhand riesiger Datensätze trainiert und verwenden fortschrittliche Klassifizierungs- und Korrelationsalgorithmen, um eine Antwort zu generieren, die auf Fakten und Beweisen und nicht auf den Budgets des Unternehmens basiert.

- Personalisiert. Die Erwähnung komplexerer, persönlicher Hintergrundinformationen, die für die Antworten, nach denen ein Benutzer sucht, von wesentlicher Bedeutung sind, verheißt bei herkömmlichen Suchmaschinen nichts Gutes, da sie in der Regel einen Einheitsansatz verfolgen und für eine bestimmte Suchanfrage identische Suchergebnisse liefern . GPT ist in dieser Hinsicht bahnbrechend, da es in der Lage ist, Benutzerpräferenzen und -anforderungen durch explizite und kontextreiche Eingaben zu verstehen und sich an diese anzupassen, ohne dabei in die Privatsphäre der Benutzer einzugreifen.

- Dynamisch. LLMs haben die Möglichkeit, an Gesprächen in mehreren Runden teilzunehmen und Benutzer dazu zu ermutigen, ihre Fragen zu verfeinern und durch Folgefragen zusätzlichen Kontext bereitzustellen. Dies ermöglicht es ihnen, zunehmend verfeinerte Antworten zu finden, die sich anfühlen, als wären sie speziell auf jeden Benutzer zugeschnitten.

Wie LLMs die Art und Weise verändern, wie wir suchen

Durch die Arbeit mit herkömmlichen Suchmaschinen haben Benutzer gelernt, präzise Schlüsselwörter einzugeben, die den von ihnen gesuchten Informationen entsprechen – ein Ansatz, der häufig die Fragmentierung von Abfragen in mehrere Schlüsselwörter erfordert, was oft ineffizient ist und möglicherweise nicht die gewünschten Ergebnisse liefert.

Selbst mit der Integration von LLMs in Suchmaschinen, insbesondere mit dem Ziel, eine höhere Relevanz der Ergebnisse zu erreichen, haben Suchmaschinen immer noch Probleme und präsentieren in den meisten Fällen irrelevante und unvollständige Ergebnisse.

Mit dem Aufkommen von Modellen wie GPT eröffnen sich neue Perspektiven für den Suchprozess, und wir sehen eine deutliche Verschiebung von einem fragmentierten, schlüsselwortbasierten Ansatz hin zu einer natürlicheren und intuitiveren Fragestellung. Diese Entwicklung geht mit dem Aufstieg der Sprachsuchtechnologien einher, die mittlerweile 20 % der mobilen Suchanfragen von Google ausmachen.

Durch Interaktionen mit LLMs wie Chat GPT können Benutzer den Prozess der Informationssuche aktiv gestalten und steuern. ein tieferes Verständnis für die Informationen zu entwickeln, die sie benötigen, und wie sie ihre Fragen effektiv formulieren können, um die gewünschten Ergebnisse zu erzielen.

Anstatt sich auf eine einfache Folge unzusammenhängender Schlüsselwörter zu verlassen, lernen sie Folgendes:

- Formulieren Sie ihre Fragen klar und prägnant und vermeiden Sie Mehrdeutigkeiten und vage Formulierungen.

- Geben Sie Kontext und spezifische Details an, einschließlich relevanter Hintergrundinformationen, Präferenzen und Situationsfaktoren.

Was für Fragen stellen die Leute?

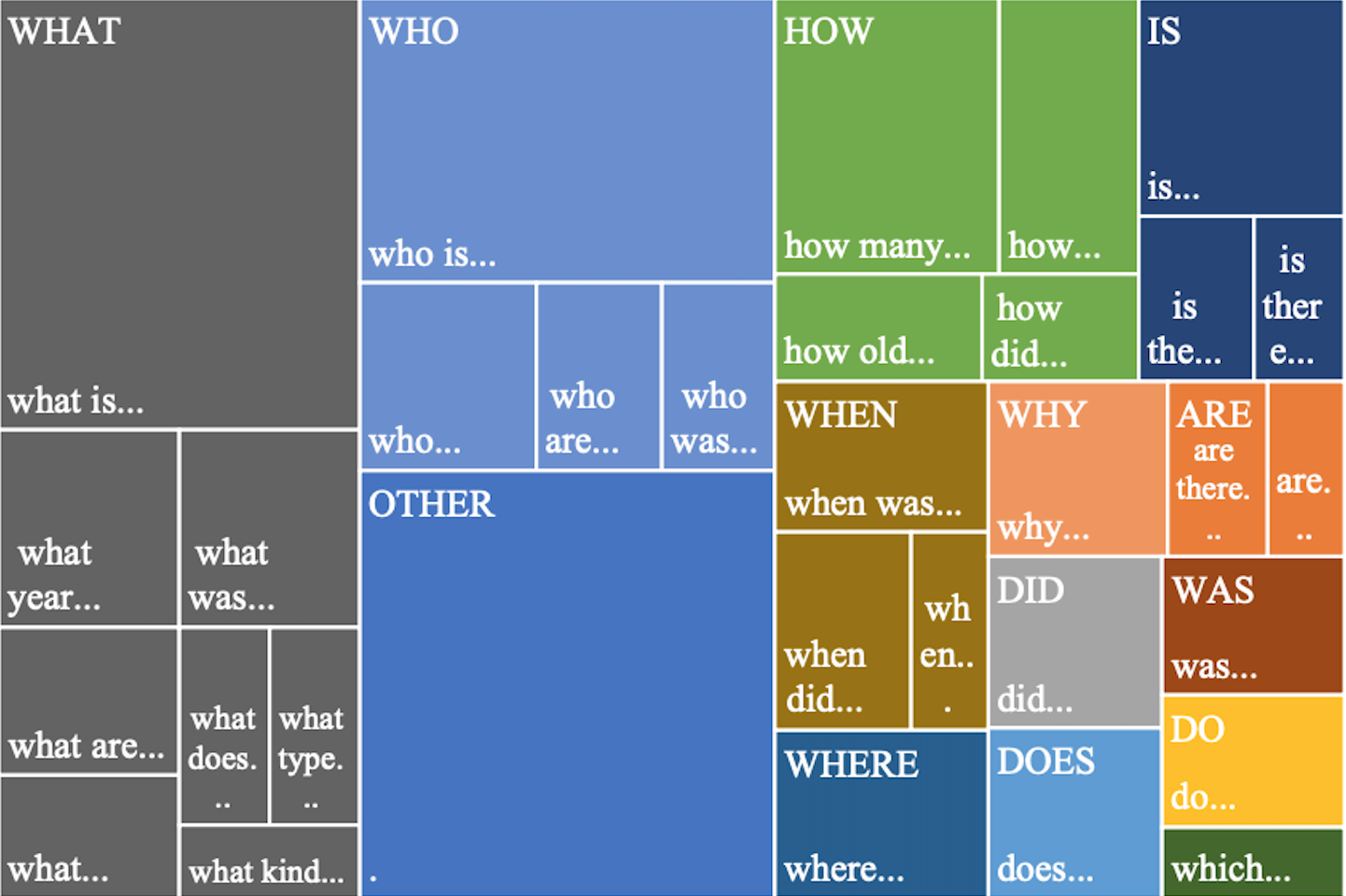

Wenn wir im GPT-Abfrageprozess einen Schritt zurückgehen, ist es wichtig, nicht nur zu verstehen, warum und wann sich Menschen für Antworten an KI wenden, sondern auch , wie sie ihre Anfragen formulieren und welche anderen Kontextinformationen daraus abgeleitet werden könnten.

Dieses Verständnis bildet den Kern der aufstrebenden Disziplin AEO (Answer Engine Optimization), die sich auf die Muster dieser Benutzeranfragen konzentriert und die Notwendigkeit von Inhalten betont, die direkt auf spezifische Benutzerbedürfnisse eingehen.

Diese Fragen folgen bestimmten Mustern und Strukturen, deren Verständnis bei Versuchen zur GPT-Optimierung von entscheidender Bedeutung ist. Hier sind einige gebräuchliche Formulierungen von Anfragen, die Benutzer an ChatGPT gerichtet haben, wenn sie nach bestimmten Produkten oder Dienstleistungen suchen :

Ich suche personalisierte Empfehlungen

Benutzer wenden sich häufig an GPT und bitten um Vorschläge/personalisierte Empfehlungen oder Expertenrat und formulieren ihre Fragen wie „ Was sind die besten… “ oder „ Können Sie einige empfehlen… “?

Preissensible Anfragen

LLMs sind eine großartige Beratungshilfe, wenn Sie das beste Preis-Leistungs-Verhältnis finden möchten. Sie können Echtzeitinformationen zu Preisen, Rabatten und kostengünstigen Optionen für verschiedene Szenarien bereitstellen.

Die Fragen lauten wie folgt: „ Was ist am günstigsten… “, „ Was ist am kostengünstigsten …“ oder „ Wo finde ich bezahlbare… “.

Funktionsspezifische Anfragen

Häufig fragen Benutzer nach bestimmten Merkmalen oder Qualitäten von Dienstleistungen und Produkten.

Sie könnten beispielsweise fragen: „ Welches [Produkt/welche Dienstleistung] hat die beste [spezifische Funktion]? “ oder „ Können Sie ein [Produkt/Dienstleistung] nennen, das [spezifische Funktion] bietet? “

Vergleichende Fragen

Diese Art von Anfragen eignet sich besonders gut für LLMs, da sie eine detaillierte Analyse verschiedener Produkte basierend auf den vom Benutzer angegebenen Bedürfnissen und Präferenzen liefern können.

Sie formulieren ihre Fragen wie folgt: „ Ist X besser als Y ?“, „ Wie schneidet X im Vergleich zu Y in Bezug auf [spezifisches Merkmal] ab? “ oder „ Was ist der Unterschied zwischen X und Y? “

Standortbezogene Suche

LLMs eignen sich hervorragend für Abfragen, die geografische Elemente einbeziehen und Echtzeitinformationen zu Optionen, Dienstleistungen oder Aktivitäten in der Nähe bieten.

Fragen lauten wie „ Wo kann ich X in meiner Nähe kaufen? “ oder „ Welche [Dienstleistungen] sind am besten in [Standort] verfügbar? “

Problemlösende Fragen

Viele Benutzer kommen mit einem bestimmten Problem zu LLM und fragen sich: „ Wie kann ich X lösen? “ oder „ Wie gehe ich am besten mit Y um? “

Diese Fragen deuten darauf hin, dass sie nach Produkten oder Dienstleistungen als Lösungen suchen.

Als Reaktion auf diese Erkenntnisse wird Unternehmen empfohlen, eine proaktive Content-Strategie zu verfolgen und sich auf die Erstellung von Material zu konzentrieren, das genau den spezifischen Bedürfnissen entspricht, die durch Benutzeranfragen hervorgehoben werden. Dadurch wird sichergestellt, dass Produkte und Dienstleistungen nicht nur in den Suchergebnissen sichtbar sind, sondern in verschiedenen Szenarien auch direkt auf die Bedürfnisse der Zielgruppe eingehen.

Chat-GPT-Ranking-Mechanismen

Nachdem wir nun untersucht haben, wie wichtig es ist, die Art und Struktur der Fragen zu verstehen, die Benutzer an GPT richten, schauen wir uns das andere Ende des Prozesses an, um zu sehen, welche Faktoren das Ranking für lösungsbasierte Abfragen bestimmen. Dieser zugrunde liegende Mechanismus beinhaltet einen umfassenden und nichtlinearen Prozess, der Folgendes umfasst:

Semantische Analyse

Der Prozess der semantischen Analyse verbindet Wörter und Phrasen zu größeren semantischen Beziehungen, um zu verstehen, wie Wörter in verschiedenen Kontexten zusammenkommen.

Zu diesem Zweck analysiert GPT große Textmengen, um Muster und Zusammenhänge abzubilden, die nicht sofort erkennbar sind, aber für das Erfassen der vollständigen Bedeutung einer Abfrage unerlässlich sind. Der Prozess umfasst :

Abfrageanalyse

GPT führt eine eingehende semantische Analyse durch, bei der die Abfrage in ihre Elemente – Wörter, Phrasen und ihre syntaktischen Beziehungen – zerlegt wird, die dann in ihrem kollektiven Kontext bewertet werden, d. h. wie sie zueinander in Beziehung stehen.

Bestimmen der Benutzerabsicht

Mithilfe eines probabilistischen Ansatzes zur Bestimmung der Benutzerabsicht analysiert GPT die Häufigkeit von Wortmustern in seinen Trainingsdaten und wie sie in bestimmten Kontexten korrelieren.

Bei einer Abfrage zu „budgetfreundlichen Familienautos“ erkennt GPT beispielsweise den Zusammenhang zwischen „budgetfreundlich“ und Kostenerwägungen bei Fahrzeugen, genauso wie „familienfreundliche“ Autos mit Attributen wie Platz und Sicherheit verbunden sind.

Bewertung im Kontext

LLMs berücksichtigen, dass Abfragen, obwohl sie möglicherweise ähnliche Wörter enthalten, völlig unterschiedliche Bedeutungen und Anforderungen haben können, und sie ermitteln, ob die Formulierung der Frage darauf hinweist, dass ein Benutzer Rat sucht, Vergleiche anstellt oder sich nach bestimmten Merkmalen erkundigt. Die Antworten werden auf die zugrunde liegenden Benutzerbedürfnisse zugeschnitten, sei es Budgetbeschränkungen, Leistungsmerkmale oder Markenpräferenzen.

Datenabruf und -synthese

Neben den Erkenntnissen aus der semantischen Analyse wertet ChatGPT die Anfrage anhand seines umfangreichen Trainingsdatensatzes sowie der Echtzeit-Websuche aus.

Trainingsdatensatz

Die Datenbank von GPT umfasst ein breites Spektrum an Quellen, von wissenschaftlichen Artikeln bis hin zu populären Medien, und gewährleistet so ein umfassendes Verständnis über verschiedene Bereiche hinweg. Es ist jedoch nicht genau bekannt, was im Trainingsset enthalten ist und nach welchen Richtlinien die Quellen darin enthalten sind.

Web-Suche

Ein entscheidender Aspekt der Trainingsdaten von GPT ist ihre zeitliche Begrenzung – zum Zeitpunkt des Schreibens dieses Artikels ist sie auf April 2023 beschränkt. Ergänzend dazu bietet die Pro-Version von ChatGPT jetzt auch Websuchfunktionen über Bing. Diese Integration ist besonders wichtig in Bereichen, in denen häufig neue Produkte oder Dienstleistungen eingeführt werden.

Ranking-Faktoren

Wenn GPT Produkte oder Dienstleistungen als Antwort auf eine Anfrage einordnet, stützt es sich auf eine Reihe von Ranking-Faktoren. Diese sollen sicherstellen, dass die Antworten nicht nur relevant, sondern auch glaubwürdig, vielfältig und zeitnah sind. Hier ist ein genauerer Blick auf einige der wichtigsten:

Abfrage und Kontextabgleich

GPT priorisiert Lösungen, die direkt auf die Bedürfnisse des Benutzers eingehen. Diese Relevanz wird nicht allein durch die Keyword-Häufigkeit bestimmt, sondern durch die Tiefe der Übereinstimmung zwischen der Absicht der Suchanfrage und den mit den Produkten oder Dienstleistungen verbundenen Informationen.

Glaubwürdigkeit und Popularität

Wenn Produkte oder Dienstleistungen erwähnt werden, beurteilt GPT die Zuverlässigkeit der Quellen. Dazu gehört die Bewertung der Häufigkeit und des Kontexts von Erwähnungen in einem Spektrum von Quellen, wobei denjenigen, die häufig in seriösen Kontexten zitiert werden, ein höheres Gewicht beigemessen wird. Das Modell berücksichtigt auch die Beliebtheit von Produkten, die sich aus ihrer Verbreitung in den Trainingsdaten ergibt.

Benutzer-Feedback-Analyse

GPT führt eine Stimmungsanalyse des Feedbacks und der Bewertungen in seinen Trainingsdaten und aktuellen Websuchergebnissen durch. Produkte oder Dienstleistungen mit überwiegend positiver Stimmung werden im Ranking bevorzugt.

Vielfalt und Abdeckung

Während GPT für Vielfalt sorgt, sorgt es für ein Gleichgewicht, sodass Benutzern eine breite Auswahl an Auswahlmöglichkeiten geboten wird, die dennoch für die Abfrage von hoher Relevanz sind.

Frische Informationen

Während historische Daten das Rückgrat des GPT-Wissens bilden, da einige Abfragen von bewährten Informationen oder langjähriger Reputation profitieren können, werden auch neue Informationen berücksichtigt, insbesondere für Märkte, in denen sich Entwicklungen schnell vollziehen.

Darüber hinaus berücksichtigt GPT andere Faktoren, wenn auch in geringerem Maße, wie zum Beispiel:

Personalisierung und Feedback

Die Antworten von GPT sind nicht statisch und jede Benutzerinteraktion bietet dem Modell die Möglichkeit, zu lernen und sich anzupassen. Wenn Benutzer spezifischere Anforderungen oder Feedback stellen, ändert GPT seine Antworten dynamisch. Dieser iterative Prozess ermöglicht es GPT, seine Rankings dynamisch anzupassen und sicherzustellen, dass die endgültigen Empfehlungen so relevant und personalisiert wie möglich sind.

Ethisches und unvoreingenommenes Ranking

GPT ist bestrebt, in seinen Antworten eine objektive Haltung einzunehmen. Es ist so programmiert, dass Vorurteile vermieden werden, die durch bezahlte Werbeaktionen, Werbung oder unangemessene externe Einflüsse entstehen könnten. Der Schwerpunkt liegt auf einer objektiven Analyse der Daten mit Empfehlungen basierend auf Wert und Relevanz.

Letzte Worte

Es besteht kein Zweifel: Die Einführung von GPT und seine nachfolgenden Iterationen definieren die Parameter der Suchmaschinenoptimierung neu. Im Gegensatz zu herkömmlichen Ranking-Modellen, die hauptsächlich auf Backlinks und Keyword-Dichten basieren, stellt GPT eine neue Dimension dar, bei der das Antizipieren und Verstehen des Kontexts und der Absichten des Benutzers sowie die proaktive Optimierung von Inhalten für komplexe Suchanfragen im Vordergrund stehen.

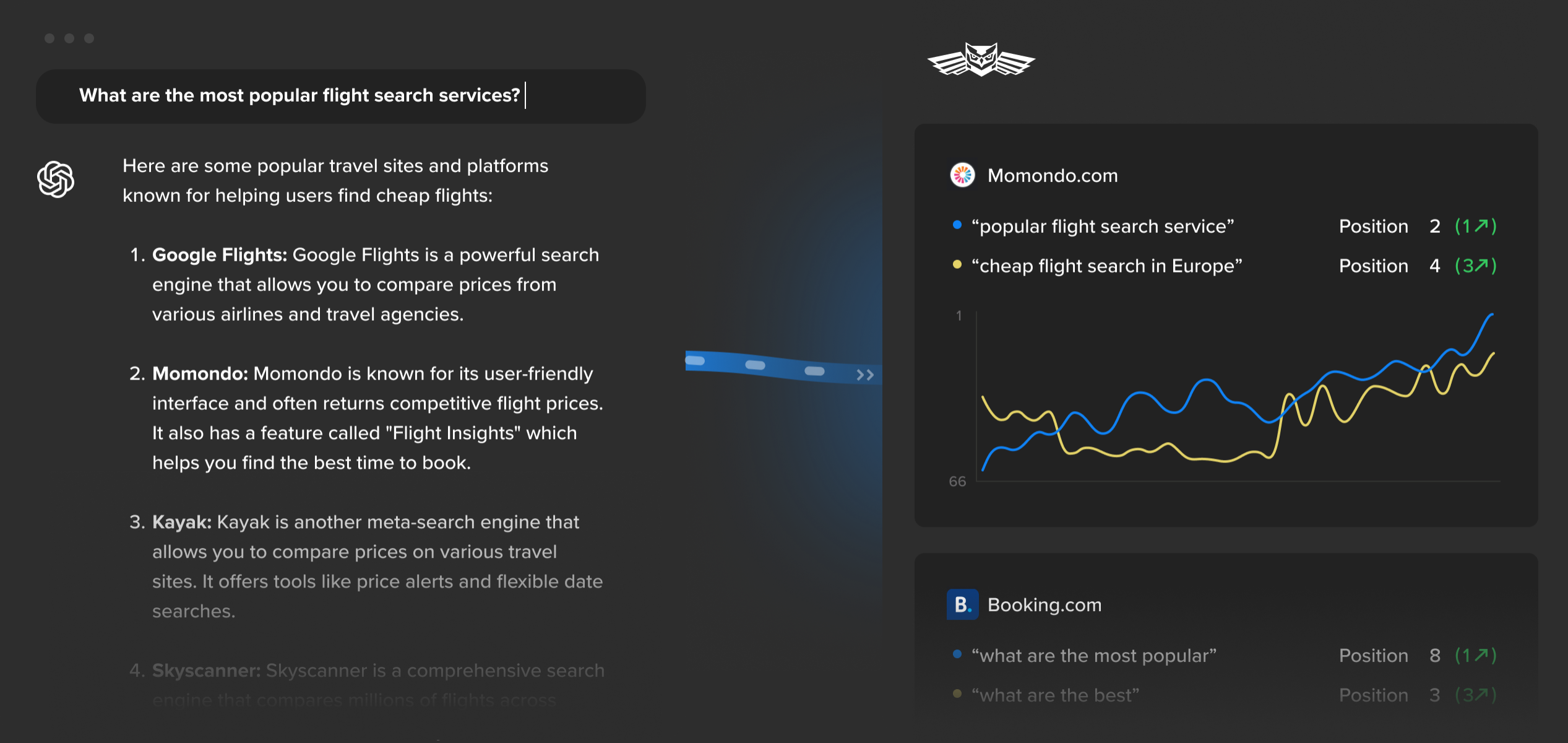

Um dies effektiv zu tun, ist es nicht nur wichtig, Benutzereingaben und GPT-Ranking-Mechanismen zu verstehen, sondern auch zu wissen, wo Produkte und Dienstleistungen in verschiedenen LLM-Modellen ranken. Wer in die Zukunft blickt, sollte erwägen, die Hilfe fortschrittlicher Tools zu nutzen, die speziell auf die Verfolgung von GPT-Rankings zugeschnitten sind, um Einblicke in Ranking-Positionen für verschiedene Benutzerfragen zu erhalten.

Während wir die innovativen Fähigkeiten von LLMs nutzen und uns auf die Fortschritte vorbereiten, die ihr Fortschritt in der SEO-Welt mit sich bringt, ist es wichtig, sich daran zu erinnern, dass die KI-Ära noch in den Kinderschuhen steckt und schnellen Veränderungen unterliegt.

Wir hoffen, dass dieser Leitfaden dazu beigetragen hat, Licht auf einige der wichtigsten Aspekte der GPT-Ranking-Mechanismen zu werfen, deren Verständnis für die effektive Nutzung dieser neuen Technologie von grundlegender Bedeutung ist. Denken Sie wie immer daran, über die neuesten Entwicklungen auf dem Laufenden zu bleiben und für weitere Innovationen auf dem Laufenden zu bleiben.