Robots Txtファイルとは何ですか? すべてを許可します

公開: 2020-11-19Robots Txtファイルとは何ですか?

robots.textファイルは、検索エンジンにサイトにアクセスできない領域を通知するための重要な方法です。 このテキストファイルによって提供される基本的な機能は、すべての主要な検索エンジンでサポートされています。 一部の検索エンジンが応答する追加のルールは、非常に便利です。 サイトでrobots.txtファイルを使用する方法はさまざまです。 プロセスはかなり単純に見えますが、注意する必要があります。 間違えると、ウェブサイトに重大な損害を与える可能性があります。

検索エンジンのスパイダーはrobots.txtファイルを読み取り、非常に厳密な構文に従います。 多くの人がこれらのクモをロボットと呼んでおり、その名前の由来となっています。 構文に使用されるファイルは、コンピューターで読み取り可能である必要があるため、単純である必要があります。 これは、エラーの余地がまったくないことを意味します。 すべてが1または0のいずれかであり、間に何も入れる余地はありません。 robots.txtファイルは、ロボット除外プロトコルとも呼ばれます。

この名前は、検索エンジンの初期のスパイダー開発者のグループに由来しています。 現時点では、ロボットのテキストファイルを公式の標準として設定している標準化団体はありません。 それにもかかわらず、すべての主要な検索エンジンはこのファイルに準拠しています。

ロボットのテキストファイルは何をしますか?

ウェブは、ページをスパイダリングすることによって検索エンジンによって索引付けされます。 リンクをたどって、サイトAからサイトBなどに検索エンジンを誘導します。 検索エンジンによって送信されたスパイダーが、過去に遭遇したことのないドメインのページをクロールする前に、ドメインのrobots.txtファイルが開かれます。 これは、Webサイト上のどのURLをインデックスに登録できないかを検索エンジンに通知するものです。

ほとんどの場合、robot.txtの内容は検索エンジンによってキャッシュされます。 キャッシュは通常、毎日数回更新されます。 これは、行った変更がかなり迅速に表示されることを意味します。

Robots.txtファイルをまとめる

非常に基本的なrobots.txtファイルをまとめるのはかなり簡単です。 プロセスに問題はないはずです。 必要なのは、メモ帳などのシンプルなテキストエディタだけです。 ページを開くことから始めます。 空のページをrobots.txtとして保存します。 cPanelに移動してログインします。 フォルダーmarketpublic_htmlを見つけて、Webサイトのルートディレクトリにアクセスします。 このフォルダを開き、ファイルをドラッグします。 ファイルに適切な権限を設定していることを確認する必要があります。

あなたはウェブサイトの所有者なので、ファイルを書き込んだり、読んだり、編集したりする必要があります。 他の人があなたに代わってこれらのアクションを実行することを許可しないでください。 ファイルに表示される許可コードは0644である必要があります。これが表示されない場合は、変更する必要があります。 これを行うには、ファイルをクリックしてファイルのアクセス許可を選択します。

Robots.txt構文

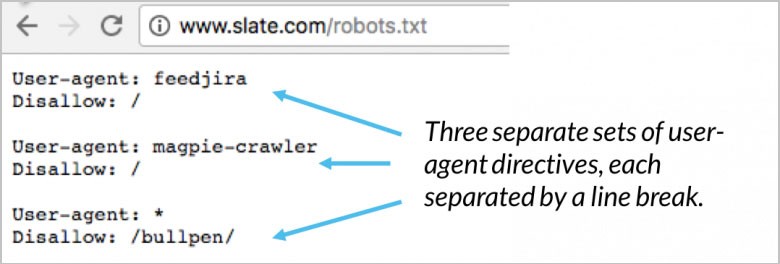

robots.txtファイルにはディレクティブのセクションが多数含まれています。 それぞれが指定されたユーザーエージェントで始まります。 これは、コードが通信しているクロールボットの名前です。 2つの異なるオプションがあります。 1つ目は、ワイルドカードを使用してすべての検索エンジンに同時に対応することです。 特定の検索エンジンに個別に対応することもできます。 Webサイトをクロールするためにボットがデプロイされると、すぐにブロックに引き寄せられます。

user-agentディレクティブは、すべてのブロックの最初の数行です。 これは単にユーザーエージェントと呼ばれ、特定のボットを特定します。 特定のボット名は、ユーザーエージェントによって照合されます。 Googlebotに何をしたいかを伝える必要がある場合は、ユーザーエージェントであるGooglebotから始めます。 検索エンジンは常に、それらに最も近い関係を持つ特定のディレクティブを特定しようとします。 ユーザーエージェントディレクティブの例をいくつか示します。

(画像クレジット:Moz)

良い例は、2つの異なるディレクティブを使用している場合です。 最初のディレクティブがGooglebot-video用で、2番目のディレクティブがBingbot用の場合、プロセスは次のようになります。 ユーザーエージェントとしてBingbotを使用する最初のボットは、指示に従います。 Googlebot-videoディレクティブが渡され、ボットはより具体的なディレクティブの検索を開始します。

60秒であなたのサイトのSEOとパフォーマンスをテストしてください!

優れたウェブサイトのデザインは、訪問者のエンゲージメントとコンバージョンにとって重要ですが、ウェブサイトの速度が遅い、またはパフォーマンスエラーがあると、最適にデザインされたウェブサイトでさえパフォーマンスが低下する可能性があります。 Diibは、世界で最高のWebサイトパフォーマンスおよびSEO監視ツールの1つです。 Diibはビッグデータの力を利用して、トラフィックとランキングをすばやく簡単に増やすことができます。 起業家に見られるように!

- 使いやすい自動SEOツール

- キーワードと被リンクの監視+アイデア

- スピード、セキュリティ、+コアバイタルトラッキングを保証します

- SEOを改善するためのアイデアをインテリジェントに提案します

- 25万人以上のグローバルメンバー

- 組み込みのベンチマークと競合他社の分析

25万を超える企業や組織で使用されています。

と同期します

ホストディレクティブ

現在、Yandexのみがhostディレクティブをサポートしています。 この指令はGoogleでもサポートされているという推測がいくつかあります。 これにより、ユーザーはwwwかどうかを判断できます。 URLの前に表示する必要があります。 確認された唯一のサポーターはYandexであるため、hostディレクティブに依存することはお勧めしません。 現在のホスト名を使用することに興味がない場合は、301リダイレクトを使用してリダイレクトできます。

2行目はrobots.txtdisallowです。 これはディレクティブのブロックです。 これは、ボットがWebサイトのどの領域にアクセスしないかを指定するために使用できます。 空の禁止を選択すると、すべて無料になります。 これは、ボットがサイトからの指示なしに、どこにアクセスし、どこにアクセスしたくないかを判断できることを意味します。

サイトマップディレクティブ

サイトマップディレクティブはrobots.txtサイトマップを使用して、XMLサイトマップが配置されている場所を検索エンジンに通知します。 最も便利で最良のオプションは、特定のウェブマスターツールを使用して、それぞれを個別に検索エンジンに送信することです。 これはあなたがそれらのすべてからあなたのウェブサイトに関する多くの貴重な情報を学ぶことを可能にするでしょう。 時間があまりない場合は、サイトマップディレクティブを使用することをお勧めします。 例えば:

あなたは興味があるでしょう

ビジネスを成功させる方法

ウェブサイトの読み込み速度:最適化のためのツール

ウェブサイトのヘルスチェック:ツールとヒント

UXとはどういう意味ですか?

(画像クレジット:WooRank)

Robots.txtバリデーター

バリデーターは、robots.txtファイルがウェブサイトにある特定のURLのGoogleからのウェブクローラーをブロックしているかどうかを示すツールです。 良い例は、このツールを使用して、すべてのGoogle画像検索からブロックする画像URLをGooglebot-Imageクローラーがクロールするためのアクセス権を持っているかどうかをテストすることです。

Robots.txtすべて許可

不許可ディレクティブは、許可ディレクティブを使用して打ち消すことができます。 GoogleとBingはどちらもAllowディレクティブをサポートしています。 DisallowディレクティブとAllowディレクティブを一緒に使用して、Disallowディレクトリを持つ特定のページまたはファイルにアクセスできることを検索エンジンに知らせることができます。 例えば:

(画像クレジット:DeepCrawl)

Robots.txt Google

9月1日をもって、Googleは、ロボットの排他的プロトコルに対する未公開のルールとサポートされていないルールの両方のサポートを停止しました。 この発表は、Googleウェブマスターブログで行われました。 これは、Googleがnoindexディレクトリを持つファイル内のrobots.txtファイルをサポートしなくなったことを意味します。

クロール-遅延ディレクティブ

クロールに関しては、Yahoo、Yandex、Bingはすべて少しトリガーを喜ばせることができます。 そうは言っても、それらはcrawl-delayディレクティブに応答します。 これは、しばらくの間それらを遠ざけることができることを意味します。

Robots.txtジェネレーター

robots.txtジェネレーターは、ウェブマスター、マーケター、SEOが技術的な知識をあまり必要とせずにrobots.txtファイルを生成できるようにするために作成されたツールです。 robots.txtファイルを作成すると、WordPressまたは他のCMSのいずれかを使用して作成したかどうかに関係なく、GoogleがWebサイトにアクセスする機能に大きな影響を与える可能性があるため、注意が必要です。

このツールの使用はかなり簡単ですが、最初にGoogleが提供する手順をよく理解しておくことをお勧めします。 実装が正しくない場合、Googleを含む検索エンジンは、Webサイトの重要なページを含むドメイン全体をクロールできません。 その結果、SEOの取り組みに大きな影響を与える可能性があります。

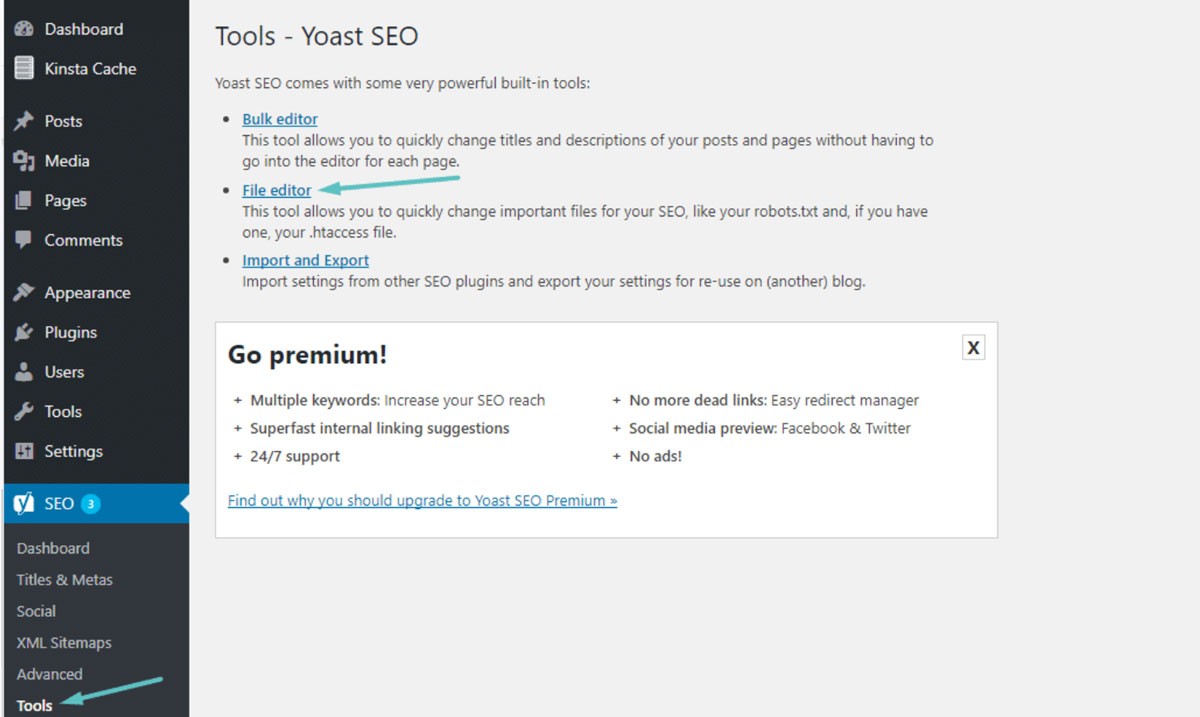

Robots.txt WordPress

ほとんどの場合、robots.txtはWordPressWebサイトのルートフォルダーにあります。 ルートフォルダを表示したり、FTPクライアントを介してWebサイトに接続したりするには、cPanelファイルマネージャーを使用する必要があります。 これは、メモ帳を使用して開くことができる単純なテキストファイルです。 以下の画像は、WordPressでファイルマネージャーにアクセスする方法を示しています。

(画像クレジット:Kinsta)

クロール遅延:10

これにより、検索エンジンがWebサイトをクロールする前、またはWebサイトに再度アクセスしてクロールした後、10秒間待機することができます。 コンセプトはほぼ同じですが、特定の検索エンジンによって若干の違いがあります。

Robots.txtを使用する理由

Robots.txtは、Webサイトを成功させるために必要ではありません。 持っていなくても、正しく機能しているウェブサイトで良いランキングを達成することができます。 robots.txtを使用しないことを決定する前に、次のようないくつかの重要な利点があることに注意してください。

- プライベートファイルを安全に保つ:ボットをプライベートフォルダーから遠ざけて、ボットの検索とインデックス作成がはるかに困難になるようにすることができます。

- サイトマップの指定:サイトマップの場所を指定できます。 クローラーに場所を提供することは、クローラーがその場所をスキャンできるようにするために重要です。

- リソース制御:リソースを確実に制御できるようにすることができます。 Webサイトがボットによってクロールされるたびに、サーバーのリソースと帯域幅が使用されます。 eコマースサイトのように多くのページと大量のコンテンツを含むWebサイトがある場合、ページ数が多いためにリソースが非常に速く枯渇する可能性があります。 robots.txtファイルを使用すると、ボットが個々の画像やスクリプトにアクセスしにくくなります。 これは、貴重なリソースが実際の訪問者のために保持されることを意味します。

- ナビゲーションコントロール:あなたは検索エンジンがあなたのサイトで最も重要なページを見つけることを望みます。 特定のページへのアクセスを迂回させて、検索者に表示するページを制御できます。 検索エンジンによる特定のページの表示を完全にブロックすることはお勧めしません。

- 重複コンテンツなし: SERPに重複コンテンツを表示させたくありません。 ロボットを使用してルールを追加し、クローラーが重複コンテンツを含むページのインデックスを作成しないようにすることができます。

Robots.txtインデックスなしvs.禁止

robots.txtがnoindexルールでサポートされていないことはすでにご存知でしょう。 noindexメタタグを使用して、検索エンジンが特定のページにインデックスを付けないようにすることもできます。 ボットは引き続きページにアクセスできますが、ロボットはタグからページがインデックスに登録されたり、SERPに表示されたりしないことを認識します。 一般的なnoindexタグとして、disallowルールが効果的であることがよくあります。 このタグをrobots.txtに追加すると、ボットはページをクロールできなくなります。 例えば:

ページが外部リンクと内部リンクを使用して他のページにすでにリンクされている場合でも、他のWebサイトまたはページから受信した情報を使用してボットがページのインデックスを作成できます。 noindexタグを使用してページが許可されていない場合、そのタグはロボットに表示されません。 これにより、とにかくページがSERPに表示される可能性があります。

ワイルドカードと正規表現の使用

これで、robots.txtファイルとその使用方法についてかなりよく理解できたはずです。 ワイルドカードはrobots.txt内に実装できるため、ワイルドカードについても知っておく必要があります。 2種類のワイルドカードから選択できます。 ワイルドカード文字を使用して、任意の文字シーケンスに一致させることができます。 この種のワイルドカードは、同じパターンに従うURLがある場合に優れたソリューションです。 良い例は、ワイルドカードを使用して、URLに疑問符が含まれているフィルターページからのクロールを禁止することです。

$ワイルドカードはURLの末尾と一致します。 良い例は、robots.txtファイルがボットによるPDFファイルへのアクセスを禁止することを確認したい場合です。 ルールを追加するだけです。 その後、robots.txtファイルにより、すべてのユーザーエージェントボットがサイトをクロールできるようになります。 同時に、.pdfendを含むページは許可されません。

避けるべき間違い

robots.txtファイルを使用して、さまざまな方法でさまざまなアクションを実行できます。 ファイルを正しく使用することを理解することが不可欠です。 robots.txtファイルを正しく使用しないと、簡単にSEOの災害になる可能性があります。 回避する必要がある最も一般的な間違いは次のとおりです。

良いコンテンツは決してブロックされるべきではありません

公開プレゼンテーションにnoindexタグまたはrobots.txtファイルを使用する場合は、適切なコンテンツがブロックされないことが重要です。 このタイプの間違いは非常に一般的であり、SEOの結果を損なうことになります。 SEOの取り組みを保護するために、禁止ルールとnoindexタグの両方についてページを徹底的にチェックしてください。

大文字と小文字の区別

robots.txtでは大文字と小文字が区別されることを忘れないでください。 これは、ロボットファイルを正しく作成する必要があることを意味します。 ロボットファイルrobots.txtには、常にすべて小文字で名前を付ける必要があります。そうしないと、機能しません。 例えば:

(画像クレジット:検索エンジンランド)

クロールの使いすぎ-遅延

クロール遅延のディレクティブを使いすぎることは、非常に悪い考えです。 これにより、ボットがクロールできるページ数が制限されます。 あなたが非常に小さなウェブサイトを持っているなら、これはうまくいくかもしれません。 あなたのウェブサイトがかなり大きい場合、あなたはトラフィックの安定した流れと良いランキングを妨げることによってあなた自身を傷つけています。 クロール遅延を使用する頻度に注意してください。

この記事がお役に立てば幸いです。

サイトの状態についてもっと興味深いことを知りたい場合は、個人的な推奨事項やアラートを取得し、DiibでWebサイトをスキャンしてください。 たった60秒です。

Robots.txtによるコンテンツのインデックス作成の防止

ボットがページの1つを直接クロールするのを防ぐための最善の方法は、ページを禁止することです。 特定の状況下では、これは機能しません。 これには、外部ソースへのリンクがあるすべてのページが含まれます。 ボットは、リンクを使用してページにアクセスし、インデックスを作成できるようになります。 ボットが不正である場合、コンテンツのクロールとインデックス作成を阻止することはできません。

Robots.txtでプライベートコンテンツを保護する

ボットをサンキューページやPDFなどのプライベートコンテンツから遠ざけても、インデックスに登録できます。 最善のオプションの1つは、すべてのプライベートコンテンツをログインの背後に配置し、disallowディレクティブと一緒に配置することです。 サイト訪問者は追加の手順を実行する必要があることに注意してください。 利点は、すべてのコンテンツが安全に保たれることです。

Diibは、ロボットtxtファイルが機能していることを確認します。

Diib Digitalは、robot.txtファイルの正常性と有効性に関する最新情報を提供します。 Googleにトラフィックを誤って誘導させないでください。これにより、バウンス率が高くなります。 役立つユーザーダッシュボードの機能の一部を次に示します。

- カスタムアラートを提供します。これにより、ウェブサイトの状態と、robot.txtファイルに影響を与える可能性のあるGoogleアルゴリズムの変更について通知されます。

- モバイルの使いやすさ、ウェブサイトの健全性、オーガニックトラフィックを改善する方法に関するカスタマイズされた提案を含む目標。

- あなた自身のウェブサイトの健康だけでなく、あなたの主要な競争相手の健康への洞察。

- Facebookプロファイルを同期して、ソーシャルメディアキャンペーンの詳細についての洞察を得ることができます。 特定の投稿のパフォーマンス、ユーザーの人口統計、投稿するのに最適な時間帯、コンバージョンなど。

- Diibの成長の専門家との毎月の共同セッションでは、モバイルSEOの取り組みを微調整し、成長と成功へと導くことができます。

今日800-303-3510に電話するか、ここをクリックして無料の60 Webサイトスキャンを取得し、SEOの長所と短所について詳しく学んでください。