Apa Itu File Robots Txt? Izinkan Semua Dan Lainnya

Diterbitkan: 2020-11-19Apa itu File Robots Txt?

File robots.text adalah metode utama untuk memberi tahu mesin pencari area yang tidak dapat mereka kunjungi di situs Anda. Fungsionalitas dasar yang disediakan oleh file teks ini didukung oleh semua mesin pencari utama. Aturan tambahan yang akan ditanggapi oleh beberapa mesin pencari bisa sangat berguna. Ada berbagai cara untuk menggunakan file robots.txt di situs Anda. Meskipun prosesnya tampak cukup sederhana, Anda harus berhati-hati. Jika Anda membuat kesalahan, Anda dapat melakukan kerusakan signifikan pada situs web Anda.

Spider mesin pencari membaca file robots.txt dan mematuhi sintaks yang sangat ketat. Banyak orang menyebut laba-laba ini sebagai robot dari situlah nama itu berasal. File yang digunakan untuk sintaks harus sederhana karena harus dapat dibaca oleh komputer. Ini berarti sama sekali tidak ada ruang untuk kesalahan. Semuanya adalah satu atau nol tanpa ruang untuk apa pun di antaranya. File robots.txt juga disebut sebagai protokol pengecualian robot.

Nama ini berasal dari sekelompok pengembang laba-laba awal untuk mesin pencari. Saat ini, tidak ada organisasi standar yang menetapkan file teks robot sebagai standar resmi. Meskipun demikian, semua mesin pencari utama mematuhi file ini.

Apa yang Dilakukan File Teks Robot?

Web diindeks oleh mesin pencari oleh halaman spidering. Tautan diikuti untuk memandu mesin pencari dari situs A ke B dan seterusnya. Sebelum laba-laba yang dikirim oleh mesin pencari merayapi halaman mana pun untuk domain yang sebelumnya tidak ditemukan, file robots.txt untuk domain dibuka. Inilah yang memberi tahu mesin pencari URL mana yang tidak boleh diindeks di situs web.

Dalam kebanyakan kasus, konten robot.txt di-cache oleh mesin pencari. Cache umumnya disegarkan beberapa kali setiap hari. Ini berarti setiap perubahan yang Anda buat ditampilkan dengan cukup cepat.

Menyatukan File Robots.txt Anda

Menyusun file robots.txt yang sangat mendasar cukup sederhana. Anda seharusnya tidak mengalami kesulitan dengan prosesnya. Yang Anda perlukan hanyalah editor teks sederhana seperti Notepad. Mulailah dengan membuka halaman. Sekarang simpan halaman kosong Anda sebagai robots.txt. Buka cPanel Anda dan login. Temukan folder market public_html untuk mengakses direktori root situs web Anda. Buka folder ini, lalu seret file Anda. Anda perlu memastikan bahwa Anda telah mengatur izin yang tepat untuk file Anda.

Karena Anda adalah pemilik situs web, Anda harus menulis, membaca, dan mengedit file Anda. Anda tidak boleh mengizinkan orang lain melakukan tindakan ini atas nama Anda. Kode izin yang ditampilkan dalam file Anda harus 0644. Jika ini tidak ditampilkan, itu perlu diubah. Anda dapat melakukannya dengan mengklik file dan memilih izin file.

Sintaks Robots.txt

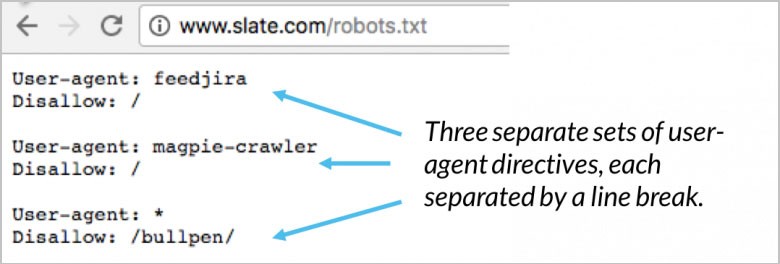

Ada banyak bagian dari arahan yang terdapat dalam file robots.txt Anda. Masing-masing dimulai dengan agen pengguna yang ditentukan. Ini adalah nama bot perayapan yang diajak bicara oleh kode Anda. Anda memiliki dua opsi berbeda yang tersedia. Yang pertama adalah menangani semua mesin pencari secara bersamaan dengan menggunakan wildcard. Anda juga dapat menangani mesin pencari tertentu secara individual. Setelah bot dikerahkan untuk merayapi situs web, bot segera ditarik ke blok.

Arahan agen pengguna Anda adalah beberapa baris pertama untuk setiap blok. Ini hanya disebut sebagai agen pengguna dan menunjukkan bot tertentu. Nama bot tertentu dicocokkan oleh agen pengguna Anda. Jika Anda perlu memberi tahu Googlebot apa yang Anda inginkan, Anda mulai dengan agen pengguna: Googlebot. Mesin pencari akan selalu berusaha untuk menunjukkan arahan tertentu dengan hubungan terdekat dengan mereka. Berikut adalah beberapa contoh arahan agen-pengguna:

(Kredit Gambar: Moz)

Contoh yang baik adalah ketika Anda menggunakan dua arahan yang berbeda. Jika arahan pertama Anda adalah untuk Googlebot-video dan arahan kedua Anda untuk Bingbot, prosesnya adalah sebagai berikut. Bot pertama dengan Bingbot sebagai agen pengguna akan mengikuti instruksi Anda. Arahan Googlebot-video Anda akan dilewati dan bot akan mulai mencari arahan yang lebih spesifik.

Uji SEO dan kinerja situs Anda dalam 60 detik!

Desain situs web yang baik sangat penting untuk keterlibatan dan konversi pengunjung, tetapi situs web yang lambat atau kesalahan kinerja dapat membuat situs web yang dirancang terbaik pun berkinerja buruk. Diib adalah salah satu kinerja situs web dan alat pemantauan SEO terbaik di dunia. Diib menggunakan kekuatan data besar untuk membantu Anda meningkatkan lalu lintas dan peringkat Anda dengan cepat dan mudah. Seperti yang terlihat di Pengusaha!

- Alat SEO otomatis yang mudah digunakan

- Pemantauan + ide kata kunci dan backlink

- Memastikan kecepatan, keamanan, + pelacakan Core Vitals

- Secara cerdas menyarankan ide untuk meningkatkan SEO

- Lebih dari 250.000 ribu anggota global

- Pembandingan dan analisis pesaing bawaan

Digunakan oleh lebih dari 250 ribu perusahaan dan organisasi:

Sinkronkan dengan

Arahan Tuan Rumah

Hanya Yandex yang saat ini mendukung arahan host. Ada beberapa spekulasi bahwa arahan ini juga didukung oleh Google. Inilah yang memungkinkan pengguna untuk memutuskan apakah www. harus ditampilkan sebelum URL. Karena satu-satunya pendukung yang dikonfirmasi adalah Yandex, tidak disarankan untuk mengandalkan arahan tuan rumah. Jika Anda tidak tertarik untuk menggunakan nama host Anda saat ini, mereka dapat dialihkan menggunakan pengalihan 301.

Baris kedua adalah robots.txt disallow. Ini adalah blok arahan. Ini dapat digunakan untuk menentukan area mana dari situs web Anda yang tidak boleh diakses oleh bot. Jika Anda memilih disallow kosong, itu menjadi gratis untuk semua. Ini berarti bot dapat menentukan di mana mereka melakukan dan tidak ingin mengunjungi tanpa arahan dari situs Anda.

Petunjuk Peta Situs

Arahan peta situs Anda menggunakan peta situs robots.txt untuk memberi tahu mesin telusur di mana peta situs XML Anda berada. Pilihan Anda yang paling berguna dan terbaik adalah mengirimkan masing-masing satu per satu ke mesin pencari dengan menggunakan alat webmaster tertentu. Ini akan memungkinkan Anda untuk mempelajari banyak informasi berharga mengenai situs web Anda dari semuanya. Jika Anda tidak punya banyak waktu, menggunakan arahan peta situs adalah alternatif yang baik. Sebagai contoh:

Anda akan tertarik

Cara Berhasil Menskalakan Bisnis Anda

Kecepatan Muat Situs Web: Alat untuk Pengoptimalan

Pemeriksaan Kesehatan Situs Web: Alat Dan Tip

Apa yang dimaksud dengan UX?

(Kredit Gambar: WooRank)

Validator Robots.txt

Validator adalah alat untuk menunjukkan apakah file robots.txt Anda memblokir perayap web dari Google untuk URL tertentu yang terletak di situs web Anda. Contoh yang baik adalah menggunakan alat ini untuk menguji apakah perayap Googlebot-Gambar memiliki akses untuk merayapi URL gambar yang ingin Anda blokir dari semua penelusuran gambar Google.

Robots.txt Izinkan Semua

Disallow directive dapat dilawan dengan menggunakan Allow directive. Baik Google dan Bing mendukung direktif Allow. Anda dapat menggunakan arahan Disallow dan Allow bersama-sama untuk memberi tahu mesin telusur bahwa mereka dapat mengakses halaman atau file tertentu dengan direktori Disallow. Misalnya:

(Kredit Gambar: DeepCrawl)

Robots.txt Google

Mulai 1 September, Google berhenti mendukung aturan yang tidak dipublikasikan dan tidak didukung untuk protokol eksklusif robot. Pengumuman ini dibuat di blog Google Webmaster. Ini berarti Google tidak lagi mendukung file robots.txt dalam file dengan direktori noindex.

Arahan Penundaan Perayapan

Sehubungan dengan perayapan, Yahoo, Yandex, dan Bing semuanya bisa menjadi pemicu kecil yang menyenangkan. Ini dikatakan, mereka responsif terhadap arahan crawl-delay. Ini berarti Anda dapat menjauhkan mereka untuk sementara waktu.

Generator Robots.txt

Generator robots.txt adalah alat yang dibuat untuk membantu webmaster, pemasar, dan SEO dalam membuat file robots.txt tanpa memerlukan banyak pengetahuan teknis. Anda tetap perlu berhati-hati karena ketika Anda membuat file robots.txt dapat berdampak besar pada kemampuan Google untuk mengakses situs web Anda terlepas dari apakah Anda membangunnya menggunakan WordPress atau salah satu CMS lainnya.

Meskipun menggunakan alat ini cukup mudah, rekomendasinya adalah membiasakan diri dengan instruksi yang diberikan oleh Google terlebih dahulu. Jika penerapan Anda salah, mesin telusur termasuk Google tidak akan dapat merayapi seluruh domain Anda termasuk laman penting di situs web Anda. Hasilnya dapat secara signifikan memengaruhi upaya SEO Anda.

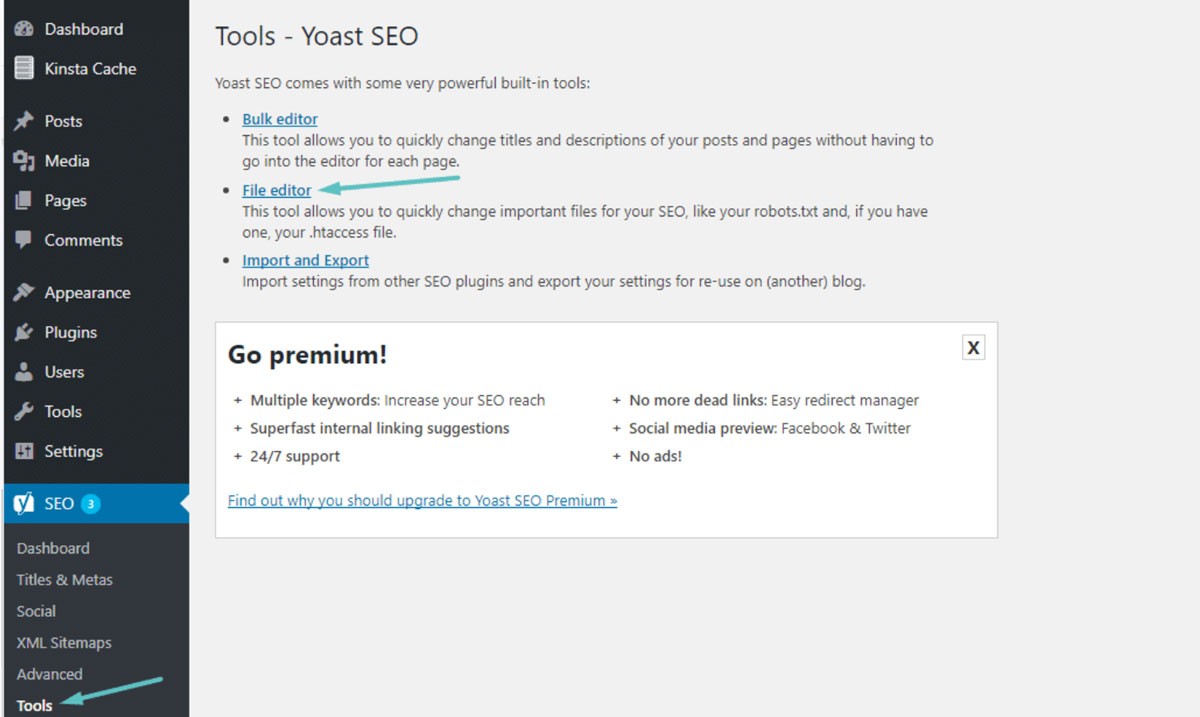

Robots.txt WordPress

Dalam kebanyakan kasus, Anda dapat menemukan robots.txt Anda di folder root untuk situs WordPress Anda. Anda perlu menggunakan pengelola file cPanel untuk melihat folder root atau terhubung ke situs web Anda melalui klien FTP. Ini hanyalah file teks sederhana yang dapat Anda buka menggunakan Notepad. Gambar di bawah ini menunjukkan cara membuka pengelola file di WordPress:

(Kredit Gambar: Kinsta)

Penundaan perayapan: 10

Ini memungkinkan Anda untuk memastikan mesin pencari akan menunggu 10 detik sebelum mereka merayapi situs web Anda atau setelah mengakses kembali situs web Anda untuk dirayapi. Konsepnya hampir sama tetapi ada sedikit perbedaan tergantung pada mesin pencari tertentu.

Mengapa Menggunakan Robots.txt?

Robots.txt tidak diperlukan untuk memiliki situs web yang sukses. Bahkan jika Anda tidak memilikinya, Anda dapat mencapai peringkat yang baik dengan situs web yang berfungsi dengan benar. Sebelum Anda memutuskan untuk tidak menggunakan robots.txt, perlu diingat bahwa ada beberapa manfaat utama termasuk:

- Simpan File Pribadi Aman: Anda dapat menjauhkan bot dari folder pribadi Anda untuk memastikan mereka jauh lebih sulit ditemukan dan diindeks.

- Tentukan Peta Situs: Anda dapat menentukan lokasi Peta Situs Anda. Menyediakan crawler dengan lokasi itu penting karena Anda ingin mereka dapat memindai melaluinya.

- Kontrol Sumber Daya: Anda dapat memastikan sumber daya Anda tetap terkendali. Setiap kali situs web Anda dirayapi oleh bot, sumber daya dan bandwidth server Anda digunakan. Jika Anda memiliki situs web dengan banyak halaman dan konten masif seperti situs eCommerce, sumber daya Anda dapat terkuras sangat cepat karena banyaknya halaman. Menggunakan file robots.txt memastikan lebih sulit bagi bot untuk mengakses gambar dan skrip individual Anda. Ini berarti sumber daya berharga Anda dipertahankan untuk pengunjung Anda yang sebenarnya.

- Kontrol Navigasi: Anda ingin mesin pencari menemukan halaman terpenting di situs Anda. Anda dapat mengalihkan akses ke halaman tertentu untuk mengontrol halaman mana yang dilihat oleh pencari. Benar-benar memblokir mesin pencari dari melihat halaman tertentu tidak dianjurkan.

- Tidak Ada Konten Duplikat: Anda tidak ingin SERP melihat konten duplikat apa pun. Anda dapat menggunakan robot Anda untuk menambahkan aturan untuk menghentikan perayap mengindeks halaman apa pun yang berisi konten duplikat.

Robots.txt Tidak ada indeks vs. Disallow

Anda sudah tahu robots.txt tidak didukung untuk aturan noindex. Anda masih dapat memastikan mesin pencari tidak mengindeks halaman tertentu melalui penggunaan tag meta noindex. Bot akan tetap dapat mengakses halaman Anda tetapi robot akan mengetahui dari tag Anda bahwa halaman Anda tidak akan diindeks atau ditampilkan di SERP. Sebagai tag noindex umum, aturan larangan sering kali efektif. Setelah Anda menambahkan tag ini ke robots.txt, bot diblokir agar tidak merayapi laman Anda. Sebagai contoh:

Jika halaman Anda sudah ditautkan ke halaman lain menggunakan tautan eksternal dan internal, halaman Anda masih dapat diindeks oleh bot menggunakan informasi yang diterima dari situs web atau halaman lain. Jika halaman Anda tidak diizinkan menggunakan tag noindex, tag tersebut tidak akan pernah terlihat oleh robots. Ini dapat menyebabkan halaman Anda muncul di SERP.

Menggunakan Wildcard dan Ekspresi Reguler

Anda sekarang harus memiliki pemahaman yang cukup baik tentang file robots.txt dan bagaimana itu digunakan. Anda juga perlu mengetahui tentang wildcard karena Anda dapat menerapkannya dalam robots.txt Anda. Anda dapat memilih dari dua jenis wildcard yang berbeda. Anda dapat menggunakan karakter wildcard untuk mencocokkan urutan karakter apa pun yang Anda inginkan. Jenis wildcard ini adalah solusi yang sangat baik jika Anda memiliki URL yang mengikuti pola yang sama. Contoh yang baik adalah menggunakan karakter pengganti untuk melarang perayapan dari halaman filter apa pun dengan tanda tanya di URL.

Wildcard $ cocok dengan akhir URL. Contoh yang baik adalah jika Anda ingin memastikan file robots.txt Anda tidak mengizinkan akses bot ke file PDF Anda. Yang harus Anda lakukan adalah menambahkan aturan. File robots.txt Anda kemudian akan mengizinkan semua bot agen pengguna merayapi situs Anda. Pada saat yang sama, halaman apa pun yang berisi akhiran .pdf tidak akan diizinkan.

Kesalahan yang Harus Anda Hindari

Anda dapat menggunakan file robots.txt untuk melakukan berbagai tindakan dengan berbagai cara. Memahami menggunakan file Anda dengan benar sangat penting. Gagal menggunakan file robots.txt Anda dengan benar dapat dengan mudah menjadi bencana SEO. Kesalahan paling umum yang perlu Anda hindari meliputi:

Konten Bagus Jangan Pernah Diblokir

Jika Anda bermaksud menggunakan tag noindex atau file robots.txt untuk presentasi publik, penting untuk tidak ada konten bagus Anda yang diblokir. Jenis kesalahan ini sangat umum dan akan merusak hasil SEO Anda. Pastikan untuk memeriksa halaman Anda secara menyeluruh untuk aturan larangan dan tag noindex untuk melindungi upaya SEO Anda.

Sensitivitas Huruf Besar

Ingat robots.txt Anda peka huruf besar/kecil. Ini berarti file robots Anda harus dibuat dengan benar. Anda harus selalu memberi nama file robot Anda robots.txt dengan huruf kecil semua atau tidak akan berfungsi. Misalnya:

(Kredit Gambar: Search Engine Land)

Terlalu sering menggunakan Penundaan Perayapan

Terlalu sering menggunakan arahan Anda untuk penundaan perayapan adalah ide yang sangat buruk. Ini akan membatasi jumlah halaman yang dapat dirayapi bot. Jika Anda memiliki situs web yang sangat kecil, ini mungkin berhasil. Jika situs web Anda cukup besar, Anda melukai diri sendiri dengan mencegah arus lalu lintas yang padat dan peringkat yang baik. Berhati-hatilah dengan seberapa sering Anda menggunakan crawl-delay.

Kami harap Anda menemukan artikel ini bermanfaat.

Jika Anda ingin mengetahui lebih banyak hal menarik tentang kesehatan situs Anda, dapatkan rekomendasi dan peringatan pribadi, pindai situs web Anda dengan Diib. Hanya membutuhkan waktu 60 detik.

Mencegah Pengindeksan Konten dengan Robots.txt

Cara terbaik untuk membantu mencegah bot merayapi langsung salah satu halaman Anda adalah dengan melarang halaman tersebut. Dalam keadaan tertentu, ini tidak akan berhasil. Ini termasuk halaman apa pun dengan tautan ke sumber eksternal. Bot akan dapat menggunakan tautan Anda untuk mengakses dan mengindeks halaman Anda. Jika bot tidak sah, Anda tidak akan dapat mencegahnya merayapi dan mengindeks konten Anda.

Melindungi Konten Pribadi dengan Robots.txt Anda

Bahkan jika Anda mengarahkan bot jauh dari konten pribadi termasuk halaman terima kasih atau PDF, mereka masih dapat diindeks. Salah satu opsi terbaik Anda adalah meletakkan semua konten pribadi Anda di belakang login dan di samping arahan disallow. Ingatlah bahwa pengunjung situs Anda harus melakukan langkah tambahan. Keuntungannya adalah semua konten Anda akan tetap aman.

Diib Memastikan File Robot txt Anda Berfungsi!

Diib Digital memberi Anda informasi terbaru mengenai kesehatan dan efektivitas file robot.txt Anda. Jangan biarkan Google salah mengarahkan lalu lintas Anda, yang mengarah ke rasio pentalan yang tinggi. Berikut adalah beberapa fitur Dasbor Pengguna kami yang dapat membantu:

- Berikan Lansiran Khusus , yang memberi tahu Anda tentang kesehatan situs web Anda dan setiap perubahan pada algoritme google yang dapat memengaruhi file robot.txt Anda.

- Tujuan dengan saran khusus tentang cara meningkatkan keramahan seluler, kesehatan situs web, dan lalu lintas organik Anda.

- Wawasan tidak hanya tentang kesehatan situs web Anda sendiri, tetapi juga tentang pesaing utama Anda.

- Memungkinkan Anda untuk menyinkronkan profil Facebook Anda , memberi Anda wawasan tentang spesifik kampanye media sosial Anda. Hal-hal seperti kinerja posting tertentu, demografi pengguna, waktu terbaik untuk memposting dan konversi.

- Sesi kolaboratif bulanan dengan pakar pertumbuhan Diib yang dapat membantu Anda menyempurnakan upaya SEO seluler Anda dan memandu Anda menuju pertumbuhan dan kesuksesan.

Hubungi hari ini di 800-303-3510 atau klik di sini untuk mendapatkan 60 pemindaian situs web gratis dan mempelajari lebih lanjut tentang kekuatan dan kelemahan SEO Anda.