ไฟล์ Robots Txt คืออะไร? อนุญาตทั้งหมดและอื่น ๆ

เผยแพร่แล้ว: 2020-11-19ไฟล์ Robots Txt คืออะไร?

ไฟล์ robots.text เป็นวิธีการสำคัญในการแจ้งให้เครื่องมือค้นหาทราบถึงพื้นที่ที่พวกเขาไม่สามารถไปยังไซต์ของคุณได้ ฟังก์ชันพื้นฐานที่มีให้ในไฟล์ข้อความนี้ได้รับการสนับสนุนโดยเครื่องมือค้นหาหลักทั้งหมด กฎเพิ่มเติมที่เครื่องมือค้นหาบางโปรแกรมจะตอบสนองอาจเป็นประโยชน์อย่างยิ่ง คุณสามารถใช้ไฟล์ robots.txt บนไซต์ของคุณได้หลายวิธี แม้ว่ากระบวนการจะดูค่อนข้างง่าย แต่คุณต้องระวัง หากคุณทำผิดพลาด คุณสามารถสร้างความเสียหายอย่างใหญ่หลวงต่อเว็บไซต์ของคุณได้

สไปเดอร์ของเครื่องมือค้นหาอ่านไฟล์ robots.txt และปฏิบัติตามไวยากรณ์ที่เข้มงวดมาก หลายคนอ้างถึงแมงมุมเหล่านี้เป็นหุ่นยนต์ซึ่งเป็นที่มาของชื่อ ไฟล์ที่ใช้สำหรับไวยากรณ์ต้องเรียบง่ายเพราะจะต้องสามารถอ่านได้โดยคอมพิวเตอร์ ซึ่งหมายความว่าไม่มีที่ว่างสำหรับข้อผิดพลาดอย่างแน่นอน ทุกอย่างเป็นหนึ่งหรือศูนย์โดยไม่มีที่ว่างระหว่างกัน ไฟล์ robots.txt ยังเรียกว่าโปรโตคอลการยกเว้นโรบ็อต

ชื่อนี้มีต้นกำเนิดมาจากกลุ่มนักพัฒนาแมงมุมในยุคแรกๆ สำหรับเครื่องมือค้นหา ในขณะนี้ ยังไม่มีองค์กรมาตรฐานใดที่กำหนดให้ไฟล์ข้อความของโรบ็อตเป็นมาตรฐานอย่างเป็นทางการ อย่างไรก็ตาม เครื่องมือค้นหาสำคัญๆ ทั้งหมดยังคงยึดติดกับไฟล์นี้

ไฟล์ข้อความ Robots ทำอะไร?

เว็บถูกสร้างดัชนีโดยเครื่องมือค้นหาโดยหน้าเว็บสไปเดอร์ มีการติดตามลิงก์เพื่อเป็นแนวทางในการค้นหาจากไซต์ A ถึง B เป็นต้น ก่อนที่สไปเดอร์ที่ส่งโดยเครื่องมือค้นหาจะรวบรวมข้อมูลหน้าใดๆ สำหรับโดเมนที่ไม่พบในอดีต ไฟล์ robots.txt สำหรับโดเมนจะถูกเปิดขึ้น นี่คือสิ่งที่แจ้งเครื่องมือค้นหาว่า URL ใดบนเว็บไซต์ไม่ได้รับอนุญาตให้สร้างดัชนี

ในกรณีส่วนใหญ่ เนื้อหา robot.txt จะถูกแคชโดยเครื่องมือค้นหา โดยทั่วไปแคชจะรีเฟรชหลายครั้งในแต่ละวัน ซึ่งหมายความว่าการเปลี่ยนแปลงใดๆ ที่คุณทำจะแสดงค่อนข้างเร็ว

การรวมไฟล์ Robots.txt ของคุณเข้าด้วยกัน

การรวมไฟล์ robots.txt ขั้นพื้นฐานเข้าด้วยกันนั้นค่อนข้างง่าย คุณไม่ควรมีปัญหากับกระบวนการ คุณจะต้องใช้โปรแกรมแก้ไขข้อความอย่างง่าย เช่น Notepad เริ่มต้นด้วยการเปิดเพจ ตอนนี้บันทึกหน้าว่างของคุณเป็น robots.txt ไปที่ cPanel ของคุณและเข้าสู่ระบบ ค้นหาโฟลเดอร์ตลาด public_html เพื่อเข้าถึงไดเร็กทอรีรากสำหรับเว็บไซต์ของคุณ เปิดโฟลเดอร์นี้ จากนั้นลากไฟล์ของคุณเข้าไป คุณต้องแน่ใจว่าคุณได้ตั้งค่าการอนุญาตที่ถูกต้องสำหรับไฟล์ของคุณ

เนื่องจากคุณเป็นเจ้าของเว็บไซต์ คุณต้องเขียน อ่าน และแก้ไขไฟล์ของคุณ คุณไม่ควรอนุญาตให้บุคคลอื่นดำเนินการเหล่านี้ในนามของคุณ รหัสอนุญาตที่แสดงในไฟล์ของคุณควรเป็น 0644 หากไม่ปรากฏ จะต้องเปลี่ยนรหัสนี้ คุณสามารถทำได้โดยคลิกที่ไฟล์และเลือกการอนุญาตไฟล์

Robots.txt ไวยากรณ์

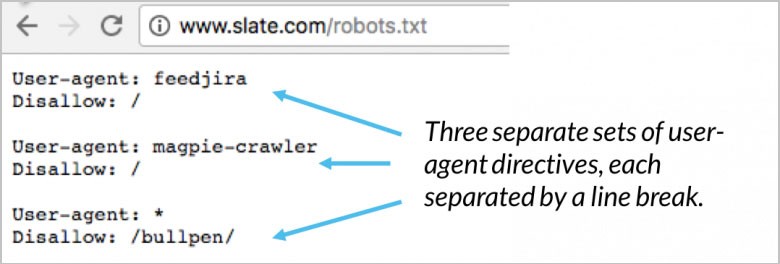

มีคำสั่งหลายส่วนในไฟล์ robots.txt ของคุณ แต่ละรายการเริ่มต้นด้วยตัวแทนผู้ใช้ที่ระบุ นี่คือชื่อของบอทการตระเวนที่โค้ดของคุณกำลังคุยด้วย คุณมีสองตัวเลือกที่แตกต่างกัน อย่างแรกคือจัดการกับเครื่องมือค้นหาทั้งหมดพร้อมกันโดยใช้สัญลักษณ์แทน นอกจากนี้คุณยังสามารถระบุเครื่องมือค้นหาเฉพาะได้ทีละรายการ เมื่อบอทได้รับการปรับใช้สำหรับการรวบรวมข้อมูลเว็บไซต์ บอทจะถูกดึงไปที่บล็อกทันที

คำสั่ง user-agent ของคุณคือสองสามบรรทัดแรกสำหรับทุกบล็อก นี่เรียกว่าเพียงแค่ตัวแทนผู้ใช้และระบุบอทเฉพาะ ชื่อบอทเฉพาะจะถูกจับคู่โดยตัวแทนผู้ใช้ของคุณ หากคุณต้องการบอก Googlebot ว่าต้องการให้ทำอะไร ให้เริ่มด้วย user-agent: Googlebot เสิร์ชเอ็นจิ้นมักจะพยายามระบุคำสั่งบางอย่างที่มีความสัมพันธ์ใกล้ชิดที่สุดกับพวกเขา ต่อไปนี้คือตัวอย่างสองสามตัวอย่างของคำสั่งตัวแทนผู้ใช้:

(เครดิตรูปภาพ: Moz)

ตัวอย่างที่ดีคือเมื่อคุณใช้คำสั่งที่แตกต่างกันสองคำสั่ง หากคำสั่งแรกของคุณมีไว้สำหรับ Googlebot-video และคำสั่งที่สองของคุณสำหรับ Bingbot กระบวนการจะเป็นดังนี้ บอทตัวแรกที่มี Bingbot เป็น user-agent จะทำตามคำแนะนำของคุณ คำสั่งวิดีโอ Googlebot ของคุณจะถูกส่งต่อ และบอทจะเริ่มค้นหาคำสั่งที่เฉพาะเจาะจงมากขึ้น

ทดสอบ SEO และประสิทธิภาพของเว็บไซต์ของคุณใน 60 วินาที!

การออกแบบเว็บไซต์ที่ดีมีความสำคัญต่อการมีส่วนร่วมของผู้เข้าชมและการแปลง แต่เว็บไซต์ที่ช้าหรือข้อผิดพลาดด้านประสิทธิภาพอาจทำให้เว็บไซต์ที่ออกแบบดีที่สุดมีประสิทธิภาพต่ำกว่ามาตรฐาน Diib เป็นหนึ่งในเครื่องมือตรวจสอบประสิทธิภาพเว็บไซต์และ SEO ที่ดีที่สุดในโลก Diib ใช้พลังของข้อมูลขนาดใหญ่เพื่อช่วยให้คุณเพิ่มปริมาณการใช้งานและอันดับของคุณได้อย่างรวดเร็วและง่ายดาย อย่างที่เห็นในผู้ประกอบการ!

- เครื่องมือ SEO อัตโนมัติที่ใช้งานง่าย

- การตรวจสอบคำหลักและลิงก์ย้อนกลับ + แนวคิด

- รับรองความเร็ว ความปลอดภัย + การติดตาม Core Vitals

- นำเสนอแนวคิดเพื่อปรับปรุง SEO อย่างชาญฉลาด

- สมาชิกทั่วโลกกว่า 250,000k คน

- การเปรียบเทียบในตัวและการวิเคราะห์คู่แข่ง

ใช้โดยบริษัทและองค์กรมากกว่า 250,000 แห่ง:

ซิงค์กับ

คำสั่งโฮสต์

ขณะนี้ Yandex เท่านั้นที่สนับสนุนคำสั่งโฮสต์ มีการคาดเดากันว่า Google รองรับคำสั่งนี้ด้วย นี่คือสิ่งที่ทำให้ผู้ใช้สามารถตัดสินใจได้ว่า www. ควรแสดงก่อน URL เนื่องจากผู้สนับสนุนที่ได้รับการยืนยันเพียงรายเดียวคือ Yandex จึงไม่แนะนำให้ใช้คำสั่งโฮสต์ หากคุณไม่สนใจที่จะใช้ชื่อโฮสต์ปัจจุบันของคุณ สามารถเปลี่ยนเส้นทางได้โดยใช้การเปลี่ยนเส้นทาง 301

บรรทัดที่สองคือ robots.txt ไม่อนุญาต นี่คือกลุ่มคำสั่ง สามารถใช้เพื่อระบุว่าส่วนใดของเว็บไซต์ของคุณที่บอทจะไม่สามารถเข้าถึงได้ หากคุณเลือกการไม่อนุญาตที่ว่างเปล่า การอนุญาตนั้นจะกลายเป็นรายการฟรีสำหรับทุกคน ซึ่งหมายความว่าบอทสามารถกำหนดได้ว่าพวกเขาไปที่ไหนและไม่ต้องการเข้าชมโดยไม่มีคำสั่งจากไซต์ของคุณ

คำสั่งแผนผังเว็บไซต์

คำสั่งแผนผังไซต์ของคุณใช้แผนผังไซต์ robots.txt เพื่อบอกเครื่องมือค้นหาว่าแผนผังไซต์ XML ของคุณอยู่ที่ใด ตัวเลือกที่มีประโยชน์และดีที่สุดของคุณคือส่งแต่ละรายการไปยังเครื่องมือค้นหาโดยใช้เครื่องมือของผู้ดูแลเว็บเฉพาะ สิ่งนี้จะช่วยให้คุณเรียนรู้ข้อมูลที่มีค่ามากมายเกี่ยวกับเว็บไซต์ของคุณจากข้อมูลทั้งหมด หากคุณไม่มีเวลามากนัก การใช้คำสั่งแผนผังเว็บไซต์ก็เป็นทางเลือกที่ดี ตัวอย่างเช่น:

คุณจะสนใจ

วิธีปรับขนาดธุรกิจของคุณให้ประสบความสำเร็จ

ความเร็วในการโหลดเว็บไซต์: เครื่องมือสำหรับการเพิ่มประสิทธิภาพ

ตรวจสุขภาพเว็บไซต์: เครื่องมือและเคล็ดลับ

UX หมายถึงอะไร

(เครดิตรูปภาพ: WooRank)

โปรแกรมตรวจสอบ Robots.txt

เครื่องมือตรวจสอบคือเครื่องมือที่แสดงว่าไฟล์ robots.txt ของคุณบล็อกโปรแกรมรวบรวมข้อมูลเว็บจาก Google สำหรับ URL เฉพาะที่อยู่ในเว็บไซต์ของคุณ ตัวอย่างที่ดีคือการใช้เครื่องมือนี้เพื่อทดสอบว่าโปรแกรมรวบรวมข้อมูล Googlebot-Image มีสิทธิ์เข้าถึงสำหรับการรวบรวมข้อมูล URL รูปภาพที่คุณต้องการบล็อกจากการค้นหารูปภาพของ Google ทั้งหมดหรือไม่

Robots.txt อนุญาตทั้งหมด

คำสั่ง disallow สามารถตอบโต้ได้โดยใช้คำสั่ง Allow ทั้ง Google และ Bing รองรับคำสั่ง Allow คุณสามารถใช้คำสั่ง Disallow และ Allow ร่วมกันเพื่อให้เครื่องมือค้นหาทราบว่าสามารถเข้าถึงบางหน้าหรือไฟล์ด้วยไดเร็กทอรี Disallow ตัวอย่างเช่น:

(เครดิตรูปภาพ: DeepCrawl)

Robots.txt Google

ในวันที่ 1 กันยายน Google ได้หยุดสนับสนุนกฎทั้งที่ไม่ได้เผยแพร่และไม่สนับสนุนสำหรับโปรโตคอลเฉพาะของโรบ็อต ประกาศนี้จัดทำขึ้นในบล็อก Google Webmaster ซึ่งหมายความว่า Google ไม่รองรับไฟล์ robots.txt ภายในไฟล์ที่มีไดเรกทอรี noindex อีกต่อไป

คำสั่งชะลอการรวบรวมข้อมูล

เกี่ยวกับการรวบรวมข้อมูล Yahoo, Yandex และ Bing ทุกคนสามารถมีความสุขได้เล็กน้อย ดังที่กล่าวไปแล้ว พวกเขาจะตอบสนองต่อคำสั่งการหน่วงเวลาการรวบรวมข้อมูล ซึ่งหมายความว่าคุณสามารถเก็บมันไว้ได้ชั่วขณะหนึ่ง

ตัวสร้าง Robots.txt

ตัวสร้าง robots.txt เป็นเครื่องมือที่สร้างขึ้นเพื่อช่วยผู้ดูแลเว็บ นักการตลาด และ SEO ในการสร้างไฟล์ robots.txt โดยไม่จำเป็นต้องมีความรู้ด้านเทคนิคมากนัก คุณยังคงต้องระวังเพราะเมื่อคุณสร้างไฟล์ robots.txt อาจส่งผลกระทบอย่างมากต่อความสามารถของ Google ในการเข้าถึงเว็บไซต์ของคุณ ไม่ว่าคุณจะสร้างมันโดยใช้ WordPress หรือ CMS ตัวใดตัวหนึ่ง

แม้ว่าเครื่องมือนี้จะค่อนข้างตรงไปตรงมา แต่คำแนะนำก็คือการทำความคุ้นเคยกับคำแนะนำที่ Google ให้ไว้ก่อน หากการใช้งานของคุณไม่ถูกต้อง เครื่องมือค้นหารวมถึง Google จะไม่สามารถรวบรวมข้อมูลทั้งโดเมนของคุณรวมถึงหน้าที่สำคัญบนเว็บไซต์ของคุณ ผลลัพธ์อาจส่งผลกระทบอย่างมากต่อความพยายาม SEO ของคุณ

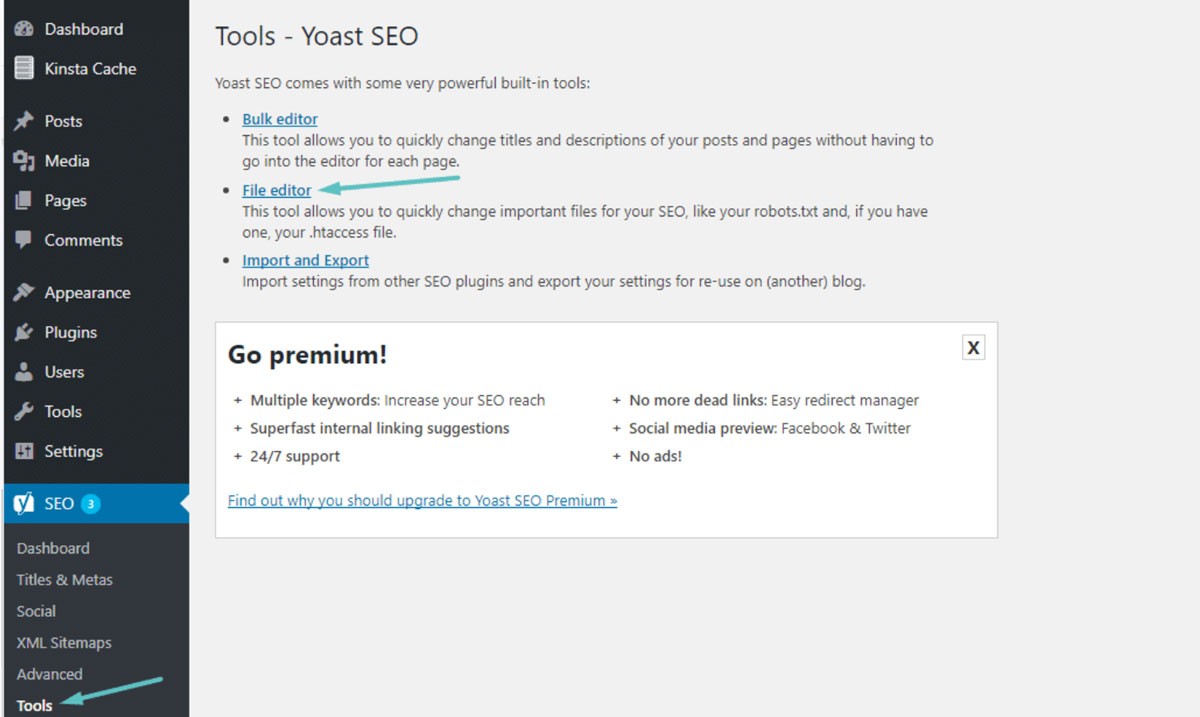

Robots.txt WordPress

ในกรณีส่วนใหญ่ คุณสามารถค้นหา robots.txt ได้ในโฟลเดอร์รูทสำหรับเว็บไซต์ WordPress ของคุณ คุณจะต้องใช้ตัวจัดการไฟล์ cPanel เพื่อดูโฟลเดอร์รูทหรือเชื่อมต่อกับเว็บไซต์ของคุณผ่านไคลเอนต์ FTP นี่เป็นเพียงไฟล์ข้อความธรรมดาที่คุณจะสามารถเปิดได้โดยใช้ Notepad ภาพด้านล่างแสดงวิธีไปที่ตัวจัดการไฟล์ของคุณบน WordPress:

(เครดิตรูปภาพ: Kinsta)

รวบรวมข้อมูลล่าช้า: 10

วิธีนี้ช่วยให้คุณมั่นใจได้ว่าเสิร์ชเอ็นจิ้นจะรอ 10 วินาทีก่อนที่จะรวบรวมข้อมูลเว็บไซต์ของคุณหรือหลังจากเข้าถึงเว็บไซต์ของคุณอีกครั้งเพื่อรวบรวมข้อมูล แนวคิดเกือบจะเหมือนกันแต่มีความแตกต่างเล็กน้อยขึ้นอยู่กับเครื่องมือค้นหาเฉพาะ

ทำไมต้องใช้ Robots.txt?

Robots.txt ไม่จำเป็นต้องมีเว็บไซต์ที่ประสบความสำเร็จ แม้ว่าคุณจะไม่มี แต่ก็สามารถบรรลุอันดับที่ดีด้วยเว็บไซต์ที่ทำงานได้อย่างถูกต้อง ก่อนที่คุณจะตัดสินใจไม่ใช้ robots.txt โปรดทราบว่ามีประโยชน์หลักสองสามประการ ได้แก่:

- รักษาไฟล์ส่วนตัวให้ปลอดภัย: คุณสามารถเก็บบอทให้ห่างจากโฟลเดอร์ส่วนตัวของคุณเพื่อให้แน่ใจว่าจะค้นหาและจัดทำดัชนีได้ยากขึ้น

- ระบุแผนผังไซต์: คุณสามารถระบุตำแหน่งแผนผังไซต์ของคุณได้ การระบุตำแหน่งให้โปรแกรมรวบรวมข้อมูลมีความสำคัญ เนื่องจากคุณต้องการให้พวกเขาสามารถสแกนหาได้

- การควบคุมทรัพยากร: คุณสามารถมั่นใจได้ว่าทรัพยากรของคุณอยู่ภายใต้การควบคุม ทุกครั้งที่บอทรวบรวมข้อมูลเว็บไซต์ของคุณ ทรัพยากรเซิร์ฟเวอร์และแบนด์วิดท์ของคุณจะถูกใช้ หากคุณมีเว็บไซต์ที่มีหน้าจำนวนมากและมีเนื้อหาจำนวนมาก เช่น เว็บไซต์อีคอมเมิร์ซ ทรัพยากรของคุณจะหมดไปอย่างรวดเร็วเนื่องจากมีหน้าจำนวนมาก การใช้ไฟล์ robots.txt ช่วยให้บอทเข้าถึงรูปภาพและสคริปต์แต่ละรายการได้ยากขึ้น ซึ่งหมายความว่าทรัพยากรอันมีค่าของคุณจะถูกเก็บไว้สำหรับผู้เยี่ยมชมจริงของคุณ

- การควบคุมการนำทาง: คุณต้องการให้เสิร์ชเอ็นจิ้นค้นหาหน้าที่สำคัญที่สุดในไซต์ของคุณ คุณสามารถโอนสิทธิ์การเข้าถึงบางหน้าเพื่อควบคุมว่าหน้าใดที่ผู้ค้นหาเห็น ไม่แนะนำให้บล็อกเครื่องมือค้นหาโดยสมบูรณ์จากการดูหน้าใดหน้าหนึ่ง

- ไม่มีเนื้อหาที่ซ้ำกัน: คุณไม่ต้องการให้ SERP เห็นเนื้อหาที่ซ้ำกัน คุณสามารถใช้โรบ็อตของคุณเพื่อเพิ่มกฎเพื่อหยุดโปรแกรมรวบรวมข้อมูลจากการจัดทำดัชนีหน้าใดๆ ที่มีเนื้อหาที่ซ้ำกัน

Robots.txt ไม่มีดัชนีเทียบกับ Disallow

คุณรู้อยู่แล้วว่า robots.txt ไม่รองรับกฎ noindex คุณยังสามารถทำให้เครื่องมือค้นหาไม่สร้างดัชนีหน้าใดหน้าหนึ่งได้โดยใช้เมตาแท็ก noindex บอทจะยังสามารถเข้าถึงหน้าเว็บของคุณได้ แต่โรบ็อตจะทราบจากแท็กของคุณว่าหน้าเว็บของคุณจะไม่ได้รับการจัดทำดัชนีหรือแสดงใน SERP ในฐานะแท็ก noindex ทั่วไป กฎ disallow มักจะมีผล เมื่อคุณเพิ่มแท็กนี้ใน robots.txt แล้ว บ็อตจะถูกบล็อกจากการรวบรวมข้อมูลหน้าเว็บของคุณ ตัวอย่างเช่น:

หากหน้าของคุณเชื่อมโยงกับหน้าอื่นแล้วโดยใช้ลิงก์ภายนอกและภายใน บอทยังสามารถสร้างดัชนีหน้าของคุณโดยใช้ข้อมูลที่ได้รับจากเว็บไซต์หรือเพจอื่น หากหน้าเว็บของคุณไม่ได้รับอนุญาตให้ใช้แท็ก noindex โรบ็อตจะไม่เห็นแท็กดังกล่าว ซึ่งอาจส่งผลให้หน้าของคุณปรากฏใน SERP ต่อไป

การใช้สัญลักษณ์แทนและนิพจน์ทั่วไป

ตอนนี้คุณควรมีความเข้าใจที่ดีพอสมควรเกี่ยวกับไฟล์ robots.txt และวิธีการใช้งาน คุณจำเป็นต้องรู้เกี่ยวกับไวด์การ์ดด้วย เนื่องจากคุณสามารถนำไปใช้ภายใน robots.txt ของคุณได้ คุณสามารถเลือกจากไวด์การ์ดสองประเภทที่แตกต่างกัน คุณสามารถใช้อักขระตัวแทนเพื่อจับคู่ลำดับอักขระที่คุณต้องการ ไวด์การ์ดประเภทนี้เป็นทางออกที่ดีถ้าคุณมี URL ใด ๆ ที่มีรูปแบบเดียวกัน ตัวอย่างที่ดีคือการใช้สัญลักษณ์แทนเพื่อไม่อนุญาตให้รวบรวมข้อมูลจากหน้าตัวกรองใดๆ ที่มีเครื่องหมายคำถามใน URL

สัญลักษณ์แทน $ ตรงกับส่วนท้ายของ URL ตัวอย่างที่ดีคือถ้าคุณต้องการให้แน่ใจว่าไฟล์ robots.txt ของคุณจะไม่อนุญาตให้บอทเข้าถึงไฟล์ PDF ของคุณ สิ่งที่คุณต้องทำคือเพิ่มกฎ ไฟล์ robots.txt ของคุณจะอนุญาตให้บอท user-agent ทั้งหมดรวบรวมข้อมูลเว็บไซต์ของคุณ ในเวลาเดียวกัน หน้าใดๆ ที่มีส่วนท้าย .pdf จะไม่ถูกอนุญาต

ข้อผิดพลาดที่คุณควรหลีกเลี่ยง

คุณสามารถใช้ไฟล์ robots.txt เพื่อดำเนินการต่างๆ ได้หลากหลายวิธี การทำความเข้าใจการใช้ไฟล์ของคุณอย่างถูกต้องเป็นสิ่งจำเป็น การใช้ไฟล์ robots.txt ไม่ถูกต้องอาจกลายเป็นหายนะของ SEO ได้อย่างง่ายดาย ข้อผิดพลาดที่พบบ่อยที่สุดที่คุณต้องหลีกเลี่ยง ได้แก่:

เนื้อหาที่ดีไม่ควรถูกปิดกั้น

หากคุณต้องการใช้แท็ก noindex หรือไฟล์ robots.txt สำหรับการนำเสนอต่อสาธารณะ สิ่งสำคัญคือต้องไม่บล็อกเนื้อหาที่ดีของคุณ ข้อผิดพลาดประเภทนี้พบได้บ่อยมาก และจะส่งผลเสียต่อผลลัพธ์ SEO ของคุณ ตรวจสอบให้แน่ใจว่าได้ตรวจสอบหน้าเว็บของคุณอย่างละเอียดสำหรับทั้งกฎที่ไม่อนุญาตและแท็ก noindex เพื่อปกป้องความพยายาม SEO ของคุณ

ความอ่อนไหวของตัวพิมพ์

โปรดจำไว้ว่า robots.txt คำนึงถึงตัวพิมพ์เล็กและตัวพิมพ์ใหญ่ ซึ่งหมายความว่าไฟล์โรบ็อตของคุณต้องถูกสร้างขึ้นอย่างถูกต้อง คุณควรตั้งชื่อไฟล์ robots.txt ด้วยอักษรตัวพิมพ์เล็กทั้งหมด มิฉะนั้นจะไม่ทำงาน ตัวอย่างเช่น:

(เครดิตรูปภาพ: Search Engine Land)

ใช้การล่าช้าในการรวบรวมข้อมูลมากเกินไป

การใช้คำสั่งของคุณมากเกินไปสำหรับความล่าช้าในการรวบรวมข้อมูลเป็นแนวคิดที่ไม่ดีอย่างยิ่ง การดำเนินการนี้จะจำกัดจำนวนหน้าที่บอทสามารถรวบรวมข้อมูลได้ หากคุณมีเว็บไซต์ขนาดเล็กมาก การดำเนินการนี้อาจใช้ได้ หากเว็บไซต์ของคุณมีขนาดค่อนข้างใหญ่ คุณกำลังทำร้ายตัวเองโดยป้องกันไม่ให้มีการเข้าชมและการจัดอันดับที่ดี โปรดใช้ความระมัดระวังเกี่ยวกับความถี่ที่คุณใช้การหน่วงเวลาการรวบรวมข้อมูล

เราหวังว่าคุณจะพบว่าบทความนี้มีประโยชน์

หากคุณต้องการทราบความน่าสนใจเพิ่มเติมเกี่ยวกับความสมบูรณ์ของไซต์ของคุณ รับคำแนะนำและการแจ้งเตือนส่วนบุคคล ให้สแกนเว็บไซต์ของคุณโดย Diib ใช้เวลาเพียง 60 วินาที

การป้องกันการสร้างดัชนีเนื้อหาด้วย Robots.txt

วิธีที่ดีที่สุดในการช่วยป้องกันบอทจากการรวบรวมข้อมูลหน้าใดหน้าหนึ่งของคุณโดยตรงคือการไม่อนุญาตหน้าดังกล่าว ในบางกรณี วิธีนี้ใช้ไม่ได้ผล ซึ่งรวมถึงหน้าใดๆ ที่มีลิงก์ไปยังแหล่งข้อมูลภายนอก บอทจะสามารถใช้ลิงก์ของคุณเพื่อเข้าถึงและจัดทำดัชนีหน้าเว็บของคุณได้ หากบอทไม่ชอบด้วยกฎหมาย คุณจะไม่สามารถป้องกันไม่ให้มีการรวบรวมข้อมูลและจัดทำดัชนีเนื้อหาของคุณ

การป้องกันเนื้อหาส่วนตัวด้วย Robots.txt ของคุณ

แม้ว่าคุณจะนำบอทออกจากเนื้อหาส่วนตัวรวมถึงหน้าขอบคุณหรือ PDF ก็ตาม พวกมันยังสามารถสร้างดัชนีได้ หนึ่งในตัวเลือกที่ดีที่สุดของคุณคือใส่เนื้อหาส่วนตัวทั้งหมดไว้เบื้องหลังการเข้าสู่ระบบและข้างๆ คำสั่งที่ไม่อนุญาต โปรดทราบว่าผู้เยี่ยมชมเว็บไซต์ของคุณจะต้องดำเนินการขั้นตอนเพิ่มเติม ข้อดีคือเนื้อหาทั้งหมดของคุณจะปลอดภัย

Diib รับรองว่าไฟล์ Robot txt ของคุณทำงาน!

Diib Digital ให้ข้อมูลล่าสุดเกี่ยวกับความสมบูรณ์และประสิทธิภาพของไฟล์ robot.txt ของคุณ อย่าให้ Google กำหนดเส้นทางการรับส่งข้อมูลของคุณผิด ซึ่งนำไปสู่อัตราตีกลับที่สูง นี่คือคุณสมบัติบางอย่างของ User Dashboard ของเราที่สามารถช่วยได้:

- จัดเตรียมการแจ้งเตือนที่กำหนดเอง ซึ่งจะแจ้งให้คุณทราบเกี่ยวกับความสมบูรณ์ของเว็บไซต์ของคุณและการเปลี่ยนแปลงใดๆ ในอัลกอริทึมของ Google ที่อาจส่งผลต่อไฟล์ robot.txt ของคุณ

- วัตถุประสงค์ พร้อมคำแนะนำที่กำหนดเองเกี่ยวกับวิธีการปรับปรุงความเป็นมิตรกับอุปกรณ์พกพา ความสมบูรณ์ของเว็บไซต์ และการเข้าชมที่เกิดขึ้นเอง

- ข้อมูลเชิงลึก ไม่เพียงแต่ความสมบูรณ์ของเว็บไซต์ของคุณเท่านั้น แต่ยังรวมถึงคู่แข่งสำคัญของคุณด้วย

- อนุญาตให้คุณซิงค์โปรไฟล์ Facebook ของ คุณ ให้ข้อมูลเชิงลึกเกี่ยวกับแคมเปญโซเชียลมีเดียของคุณโดยเฉพาะ สิ่งต่างๆ เช่น ประสิทธิภาพการโพสต์ที่เฉพาะเจาะจง ข้อมูลประชากรของผู้ใช้ เวลาที่ดีที่สุดในการโพสต์และคอนเวอร์ชัน

- เซสชั่นการทำงานร่วมกันรายเดือน กับผู้เชี่ยวชาญด้านการเติบโตของ Diib ที่สามารถช่วยคุณปรับแต่งความพยายาม SEO บนมือถือของคุณและนำทางคุณไปสู่การเติบโตและความสำเร็จ

โทรวันนี้ที่ 800-303-3510 หรือคลิกที่นี่เพื่อสแกนเว็บไซต์ 60 ฟรีและเรียนรู้เพิ่มเติมเกี่ยวกับจุดแข็งและจุดอ่อน SEO ของคุณ