Was ist A/B-Testing? Wie es funktioniert und wann es verwendet wird

Veröffentlicht: 2022-01-25Die A/B-Testmethode bestimmt, welche von zwei Versionen von etwas die besten Ergebnisse liefert. Es wird oft als „Split-Testing“ bezeichnet, da Benutzergruppen in zwei Gruppen (die „A“-Gruppe und die „B“-Gruppe) aufgeteilt und in getrennte digitale Erlebnisse geleitet werden.

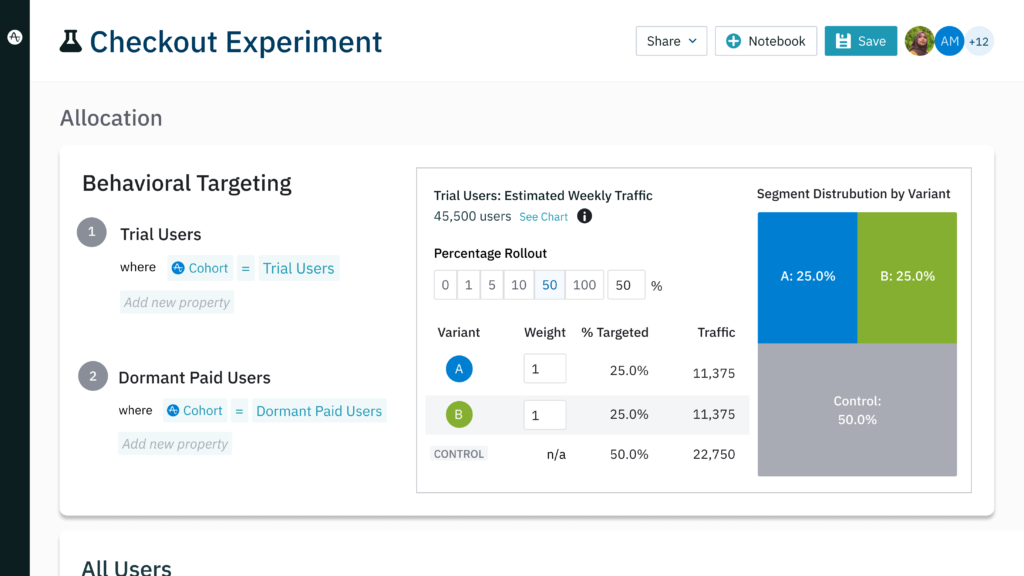

Ein A/B-Test kann Ihnen dabei helfen, Marketingkampagnen mit besserer Leistung zu erstellen oder Arbeitsabläufe beim Produkt-Onboarding zu optimieren. Änderungen an Ihrem Produkt oder Ihrer Funktion können an kleinen, segmentierten Gruppen, sogenannten Kohorten, getestet werden, um die Wirksamkeit zu überprüfen und gleichzeitig die Reibung zu minimieren.

A/B-Testing ist ein wichtiges und zuverlässiges Werkzeug, das in einer Vielzahl von Situationen eingesetzt werden kann und sollte. Produktmanager, Vermarkter, Designer und mehr, die A/B-Tests aktiv nutzen, treffen datengestützte Entscheidungen, die zu echten, quantifizierbaren Ergebnissen führen.

Die zentralen Thesen

- Ein A/B-Test hilft festzustellen, welches von zwei verschiedenen Assets besser abschneidet.

- A/B-Tests werden verwendet, um Marketingkampagnen zu optimieren, UI/UX zu verbessern und Conversions zu steigern.

- Es gibt mehrere Versionen von A/B-Tests zum Testen einzelner Seiten, mehrerer Variablen und ganzer Workflows und Trichter.

- A/B-Tests sollten segmentiert, validiert und wiederholbar sein, um maximale Ergebnisse zu erzielen.

Was sind die Vorteile von A/B-Tests?

A/B-Tests beantworten eine grundlegende Frage: Bevorzugen Kunden Option 1 oder Option 2? In der Welt der digitalen Produkte ist die Antwort auf diese Frage in einer Reihe von Situationen wertvoll, darunter in zwei Hauptbereichen: Verbesserung des Kundenerlebnisses und Verbesserung von Marketingkampagnen.

Verbesserung von UI/UX

Gut gemeinte Änderungen an der Benutzeroberfläche Ihres Produkts können unbeabsichtigte Folgen haben, die für Benutzer zu Reibungsverlusten führen. Sie können die Position eines Tabs in Ihrer mobilen App ändern, um neue Benutzer anzusprechen, aber versehentlich vorhandene Benutzer frustrieren, die an die frühere Position gewöhnt sind.

Das Durchführen einer Reihe von A/B-Tests minimiert das Risiko umfassender Änderungen, indem zunächst ein kleineres Segment Ihrer Benutzerbasis getestet wird. Sie können beispielsweise ein kleines Segment neuer Benutzer in Amplitude Experiment erstellen und sie durch die neue Iteration Ihres Produkts leiten, wobei die Registerkarte verschoben wird.

Gleichzeitig können Sie eine ähnliche Gruppe neuer Benutzer erstellen, diese jedoch verfolgen, während sie Ihre vorhandene Version verwenden. Am Ende des Experiments können Sie das Verhalten der Versuchsgruppe mit dem Verhalten Ihrer Kontrollgruppe vergleichen, um zu sehen, welche Version Ihres Produkts die besten Ergebnisse erzielt.

Um ein Gefühl dafür zu bekommen, wie bestehende Kunden auf die Änderung im Vergleich zu neuen Benutzern reagieren, sollten Sie das Experiment wiederholen. Ersetzen Sie dieses Mal die Versuchs- und Kontrollgruppen durch Segmente bestehender Benutzer. Indem Sie das Experiment mehrmals mit verschiedenen Segmenten durchführen, erhöhen Sie die Wahrscheinlichkeit, dass Ihre Änderungen die Akzeptanz Ihres Produkts fördern, anstatt Abwanderung hervorzurufen.

Optimierung von Marketingkampagnen

A/B-Tests können verwendet werden, um die Leistung Ihrer Marketingbemühungen zu steigern. Ihre Verhaltensdaten zeigen wahrscheinlich, dass Kunden, die konvertieren, wahrscheinlich ähnliche Verhaltensweisen oder demografische Merkmale aufweisen. Sie wissen, wen Sie ansprechen möchten, aber die Feinheiten erweisen sich als schwer fassbar:

- Welche Botschaften erweisen sich als am effektivsten, um Conversions zu fördern?

- Auf welches Angebot oder Incentive reagieren potenzielle oder bestehende Kunden am besten?

- Erzeugt ein anderes Design für einen CTA-Button mehr Klicks?

Sie könnten eine Kampagne auf der Grundlage Ihrer Erfahrung und Ihres Bauchgefühls aufbauen und auf das Beste hoffen, aber dies birgt immer noch Risiken. Sie können E-Mails oder bezahlte Social Posts an die richtigen Personen senden, während Sie mit Ihrer Nachricht das Ziel verfehlen. Die Kampagne kann viele Conversions erzielen, aber Sie werden nie wissen, ob die Optionen, die Sie nicht ausgewählt haben, mehr eingebracht hätten.

A/B-Tests identifizieren Ihre besten Marketingoptionen, indem sie datengestützte Ergebnisse liefern. Eine Reihe von A/B-Tests kann zeigen, dass Benutzer besser auf grüne CTAs reagieren als auf blaue oder dass ein kostenloses Testangebot besser abschneidet als ein einmaliger Rabatt. Dieser Prozess hilft Ihnen, Ausgaben zu minimieren, die für Anzeigen mit geringerer Leistung verschwendet worden wären.

Beispiele aus der Praxis für A/B-Tests

Landing Page Conversions steigern

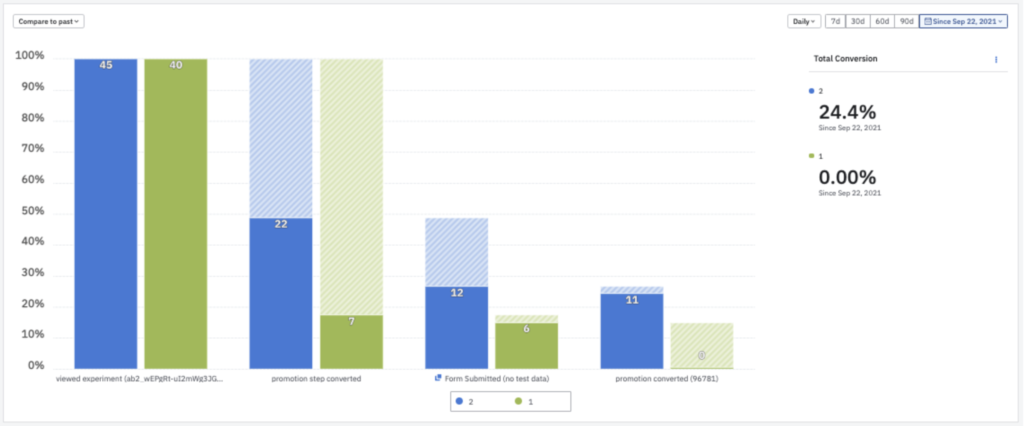

Die Esports-Plattform G-Loot verwendete A/B-Tests, um die Konversionsraten ihrer Zielseiten zu dramatischen Ergebnissen zu verbessern. G-Loot testete Änderungen an seinen werbegesteuerten Zielseiten und identifizierte die besten Änderungen mit dem Amplitude Experiment. Nachdem die Seiten geändert wurden, um das leistungsfähigste Design und die besten Angebotsvariablen widerzuspiegeln, stiegen die Konversionsraten der Landing Pages von G-Loot von drei Prozent auf unglaubliche 35 %.

Steigerung der Kundenbindung durch Optimierung des Kundenerlebnisses

NBCUniversal setzte A/B-Tests ein, um die Abwanderung zu reduzieren. Der Medienriese hat seine bestehende Homepage für Vizio-Fernseher gegen neuere Iterationen getestet. Mithilfe von Amplitude identifizierte das Unternehmen eine neue Homepage, die die Zuschauerzahlen in der Testgruppe um 10 % steigerte. NBCUniversal übernahm die neue Homepage für alle Kunden, ein Schritt, der die 7-Tage-Aufbewahrung verdoppelte.

Innovation vorantreiben durch A/B-Tests

Die richtige Analyselösung fördert häufigeres Experimentieren, was wiederum die Agilität erhöht und Innovationen fördert. Das Team von GoFundMe benötigte früher Wochen, um die A/B-Testergebnisse zu analysieren. Mit der Fähigkeit von Amplitude, Ergebnisse in Echtzeit zu analysieren, konnte GoFundMe die Anzahl der durchgeführten Tests von zwei oder drei auf 10 pro Monat erhöhen. Anstatt aus Zeitgründen auswählen zu müssen, welche Ideen getestet werden sollen, kann das Team Hypothesen jetzt testen, während sie sich entwickeln.

3 verschiedene Arten von A/B-Tests – und wann sie eingesetzt werden

Neben dem klassischen A/B-Testing gibt es drei Arten von A/B-Tests, die situationsabhängig eingesetzt werden können:

Split-URL-Tests

Eine Schaltfläche auf Ihrer Homepage zu optimieren ist eine Sache, aber was passiert, wenn Sie ein völlig neues Seitendesign testen möchten? Geteilte URL-Tests nehmen das Konzept des A/B-Tests und erweitern es auf einen größeren Maßstab. Diese Art von Test erstellt eine völlig separate URL, sodass Sie eine Webseite von Grund auf neu gestalten können. Ihre experimentelle Gruppe kann dann auf diese neue Seite geleitet werden, damit die Ergebnisse mit Ihrer bestehenden verglichen werden können.

Geteilte URL-Tests und herkömmliche A/B-Tests können zusammen verwendet werden, um die Seitenleistung zu optimieren. Ein Split-URL-Test zeigt, welches der beiden Designs der jeweiligen Seite am besten abschneidet. Von dort aus kann eine Reihe traditioneller A/B-Tests die Benutzerpräferenz auf genauere Details wie CTA-Kopie, Schriftgröße oder Bilder testen.

Multivariate Tests

Diese Art von Experiment testet Optionen, die mehr als eine Variable enthalten. Ein herkömmlicher A/B-Test kann beurteilen, welche der beiden CTA-Button-Größen bevorzugt wird. Im Vergleich dazu könnte ein multivariater Test verschiedene CTA-Größen, Überschriften und Bilder umfassen, sodass Sie feststellen können, welche einer Reihe von Optionen für Ihre Kampagne am besten geeignet ist.

Multivariate Tests sind hilfreich, um Ihre Annahmen darüber zu bestätigen oder zu widerlegen, welches Asset von vielen am besten abschneiden wird. Sie glauben vielleicht, dass eine bestimmte Kombination von Designelementen für Ihre Zielgruppe am besten geeignet ist. Indem Sie Versionen mit alternativen Variablen erstellen, können Sie Ihr bevorzugtes Design gegen viele andere testen, um eine ehrliche Aussage darüber zu treffen, was am besten funktioniert.

Der Hauptnachteil des multivariaten Testens besteht darin, dass jede zusätzliche Variable eine weitere Version des zu erstellenden Assets hinzufügt. Wenn Sie fünf verschiedene CTA-Button-Formen, vier CTA-Button-Farben und drei verschiedene Schriftarten testen möchten, müssen Sie 60 (!) verschiedene Test-Assets erstellen, um alle Ihre Grundlagen abzudecken.

Mehrseitiges Testen

Ein mehrseitiger Test misst den Erfolg einer alternativen Version von Workflows oder Trichtern. Umfassende Änderungen können an mehreren Seiten nacheinander vorgenommen werden, um einen separaten Trichter zu erstellen, der mit dem Original getestet werden kann. Ein mehrseitiger Test eignet sich auch in Situationen, in denen Sie einfach ein Element auf jeder Seite eines Ablaufs oder Trichters hinzufügen oder entfernen und die Auswirkungen testen möchten.

Angenommen, die Checkout-Sequenz für Ihre E-Commerce-Website sieht folgendermaßen aus:

Einkaufswagen (A)→ Zahlungsinformationen (A)→ Versandinformationen (A)→ Bestellung überprüfen (A) → Bestellung absenden (A)

Sie sind neugierig, ob das Bewegen des „Nächster Schritt“-Buttons auf den ersten drei Seiten hilft oder den Kaufraten schadet. Sie könnten theoretisch jede Seite einzeln testen, aber Kunden erleben diese Seiten nicht isoliert. Sie bewegen sich der Reihe nach von einer Seite zur nächsten.

Sie wissen, dass die Ergebnisse Ihres Experiments genauer sind, wenn Sie die Seiten der Reihe nach testen. Aus diesem Grund erstellen Sie Variationen Ihrer Kaufsequenz, sodass Ihr experimenteller Trichter wie folgt aussieht:

Warenkorb (B)→ Zahlungsinformationen (B)→ Versandinformationen (B)→ Bestellung überprüfen (A) → Bestellung absenden (A)

Wie bei jeder Variante des A/B-Tests besteht das Ziel darin, festzustellen, welcher Trichter am besten gegen das Original und sogar gegen andere Iterationen abschneidet. Nachdem Sie eine Reihe von Standorten für Ihre „Nächster Schritt“-Schaltfläche getestet haben, sieht Ihr endgültiger Trichter möglicherweise eher so aus:

Einkaufswagen (B)→ Zahlungsinformationen (D)→ Versandinformationen (C)→ Bestellung überprüfen (A) → Bestellung absenden (A)

Der Schlüssel zur Durchführung von A/B-Tests

So nützlich A/B-Tests für UI/UX-Design und Produktmarketing auch sind, sie müssen richtig durchgeführt und ausgewertet werden, um ihr wahres Potenzial auszuschöpfen. Zu den Schlüsseln für den Erfolg von A/B-Tests gehören:

Wiederholbarkeit

Manchmal liefern A/B-Tests Ergebnisse, die so spannend sind, dass sie zu impulsiven Entscheidungen führen. Ein Unternehmen stellte fest, dass das einfache Ändern der Farbe seines CTA-Buttons seine Konversionsraten um den Faktor drei steigerte. Wenn Ihr eigener A/B-Test zu einem ähnlichen Ergebnis führt, möchten Sie vielleicht sofort diese Version Ihrer Anzeige schalten, und es wäre schwer, Ihnen die Schuld zu geben.

Testergebnisse gelten jedoch nur dann als gültig, wenn sie wiederholbar sind. Wenn Sie immer wieder die gleichen Ergebnisse erzielen, verringert sich die Wahrscheinlichkeit, dass Ihr anfängliches Ergebnis ein Zufall war. Wenn Sie außerdem mit einer Kampagne fortfahren, die blaue CTA-Schaltflächen verwendet, ohne eine rote Version zu testen, werden Sie nie wissen, ob Sie wirklich die beste CTA-Option verwenden.

Benutzersegmentierung

Benutzersegmentierung ist der Prozess der Erstellung einer Teilmenge bestimmter Benutzer für Ihre A/B-Tests. Diese Benutzergruppen basieren auf Kunden mit ähnlichen Verhaltens- oder demografischen Merkmalen. Bei vielen A/B-Tests möchten Sie wissen, wie eine bestimmte Kundengruppe auf Änderungen reagiert, die sie betreffen. In diesen Fällen kann das Testen einer breiten Palette von Kunden das Ergebnis des Segments, das Sie ansprechen möchten, tatsächlich verwässern.

Stellen Sie sich vor, Sie erwägen ästhetische Änderungen am Chatbot Ihres Produkts. Sie wissen, dass Kunden, die Ihr Produkt länger als drei Monate verwenden, die Funktion höchstwahrscheinlich nicht nutzen werden, daher ist es nicht sinnvoll, sie in einen A/B-Test aufzunehmen. Stattdessen sollten Sie ein Segment von Benutzern erstellen, die Ihr Produkt weniger als drei Monate verwendet haben, um das beste Gefühl dafür zu bekommen, wie sich Ihre Designänderungen auf diejenigen auswirken, die es verwenden werden.

Amplitude Recommend kann sogar eine Kohorte von Kunden aufbauen, die höchstwahrscheinlich in Zukunft eine bestimmte Aktion ausführen werden. Das bedeutet, dass Sie ein Segment erstellen können, das ausschließlich aus neuen Benutzern besteht, für die analytisch vorhergesagt wurde, dass sie den Chatbot auf der Grundlage früherer Verhaltensweisen verwenden werden. Ein A/B-Test mit einer prädiktiven Kohorte hat eine viel höhere Wahrscheinlichkeit, dass die Benutzer, die Sie ansprechen möchten, eingeschlossen werden, während Personen ausgeschlossen werden, die nicht an der Verwendung eines Chatbots interessiert sind.

Testen Sie Ihren Test

Wenn Sie Ihren A/B-Test falsch aufbauen, sind all Ihre Tests umsonst. Ein fehlerhafter Test kann zu Ergebnissen führen, die trotz Benutzersegmentierung und wiederholten Tests keinen Sinn ergeben. Natürlich verhalten sich Kunden von Zeit zu Zeit unvorhersehbar, aber im Allgemeinen gibt es ein Muster in ihrem Verhalten.

Anstatt zwei Gruppen zu erstellen und sie auf zwei separate Erfahrungen zu lenken, testen Sie Ihr Produkt in einem sogenannten „A/A-Test“ gegen sich selbst. Theoretisch sollten die Ergebnisse eines A/A-Tests bemerkenswert ähnlich sein, da es keine Unterschiede zwischen den beiden Fahrten gibt. Wenn die Ergebnisse verzerrt zurückkommen, ist es an der Zeit, Ihr Experiment bis ins kleinste Detail aufzuschlüsseln und Schritt für Schritt zu analysieren, wo das Problem auftritt.

3 häufige Fehler beim A/B-Testen (und wie man sie vermeidet)

A/B-Tests liefern wertvolle Erkenntnisse, solange sie korrekt durchgeführt werden. Falsche Ergebnisse können die Ergebnisse verfälschen und dazu führen, dass Teams wichtige Entscheidungen auf der Grundlage schlechter Daten treffen. Einige der häufigsten Fehler bei A/B-Tests sind:

1. Testen mehrerer Variablen in einem einzigen A/B-Test

Ein A/B-Test dient dazu, jeweils eine Variable zu testen. Wenn Sie die Auswahlmöglichkeiten A und B auf eine einzige Änderung beschränken, können Sie mit Sicherheit wissen, dass diese spezifische Änderung für das Endergebnis verantwortlich war.

Das Ändern mehrerer Variablen öffnet die Testergebnisse für die Interpretation. Beispielsweise könnte das Ändern von drei ästhetischen Merkmalen zu einem besseren Ergebnis für Anzeige A gegenüber Anzeige B führen, aber es gäbe keine Möglichkeit zu wissen, ob alle drei Änderungen für die bessere Leistung verantwortlich waren. Bei Einzeltests stellen Sie möglicherweise fest, dass zwei der Änderungen die Leistung tatsächlich beeinträchtigten und die dritte Änderung allein für die höhere Conversion-Rate verantwortlich war.

Tun Sie sich selbst einen Gefallen und halten Sie die Dinge einfach: Beschränken Sie sich auf eine Variante pro A/B-Test.

2. Zu frühes Testen

Wenn Sie gerade eine neue Zielseite eingerichtet haben, lohnt es sich, mit dem A/B-Testen eine Weile zu warten. Das sofortige Ändern von Elementen auf einer neuen Seite hindert Sie daran, die erforderlichen Metriken zur Leistung der ursprünglichen Iteration zu sammeln. Ohne eine etablierte Baseline haben Sie nicht die richtigen Daten, um Änderungen zu testen.

3. Vorzeitiges Aufrufen eines Tests

Sie könnten versucht sein, aufgrund vielversprechender Ergebnisse bereits nach wenigen Tagen eine Erfolgsmeldung zu verkünden. Es ist jedoch am besten, die Tests mindestens ein paar Wochen laufen zu lassen, um zuverlässigere Daten zu erhalten. Ein so einfacher Faktor wie der Wochentag oder ein Feiertag kann zu verzerrten Ergebnissen führen. Ein mehrwöchiger Test kann ein realistischeres Bild davon vermitteln, wie Kunden im Laufe der Zeit auf Ihre Änderungen reagieren.

Unterstützen Sie Ihre A/B-Tests mit Kundendaten

Historische, demografische und Verhaltensdaten werden von einigen der weltweit größten Unternehmen in massiven A/B-Tests verwendet. Amazon verwendet A/B-Tests, um die Wirksamkeit seiner leistungsstarken Empfehlungsmaschine zu bestimmen. Netflix nutzte A/B-Tests, um die Erstellung seiner Top-10-Listen zu rechtfertigen. In Anbetracht der Erfolge, die sowohl Amazon als auch Netflix in ihren jeweiligen Branchen hatten, lohnt es sich, A/B-Tests in Ihren Werkzeuggürtel für das Produktmanagement aufzunehmen.

Verweise

- 24 der überraschendsten A/B-Tests aller Zeiten , WordStream. 08. Juli 2021.

- Verwendung von A/B-Tests zur Messung der Wirksamkeit von Empfehlungen, die von Amazon Personalize, AWS generiert wurden . 20. August 2020.

- Was ist ein A/B-Test? Der Netflix Tech-Blog. 22.09.2021.