O que é teste A/B? Como funciona e quando usar

Publicados: 2022-01-25O método de teste A/B determina qual das duas versões de algo produz os melhores resultados. É muitas vezes referido como "teste dividido" porque os grupos de usuários são divididos em dois grupos (o grupo "A" e o grupo "B") e canalizados em experiências digitais separadas.

Um teste A/B pode ajudá-lo a criar campanhas de marketing com melhor desempenho ou ajustar os fluxos de trabalho de integração de produtos. As alterações em seu produto ou recurso podem ser testadas em grupos pequenos e segmentados chamados coortes para verificar a eficácia e minimizar o atrito.

O teste A/B é uma ferramenta vital e confiável que pode e deve ser usada em diversas situações. Gerentes de produto, profissionais de marketing, designers e outros que usam ativamente o teste A/B tomam decisões baseadas em dados que geram resultados reais e quantificáveis.

Principais conclusões

- Um teste A/B ajuda a determinar qual de dois ativos diferentes tem melhor desempenho.

- Os testes A/B são usados para otimizar campanhas de marketing, melhorar a UI/UX e aumentar as conversões.

- Existem várias versões de testes A/B para testar páginas individuais, várias variáveis e fluxos de trabalho e funis inteiros.

- Os testes A/B devem ser segmentados, validados e repetíveis para obter resultados máximos.

Quais são os benefícios dos testes A/B?

Os testes A/B respondem a uma pergunta básica: os clientes preferem a Opção 1 ou a Opção 2? No mundo dos produtos digitais, a resposta a essa pergunta é valiosa em várias situações, incluindo dois campos principais: melhorar a experiência do cliente e aprimorar as campanhas de marketing.

Melhorando a UI/UX

Ajustes bem-intencionados na interface do usuário do seu produto podem ter consequências não intencionais que criam atritos para os usuários. Você pode alterar a localização de uma guia em seu aplicativo móvel para atrair novos usuários, mas acidentalmente frustrar os usuários existentes acostumados ao local anterior.

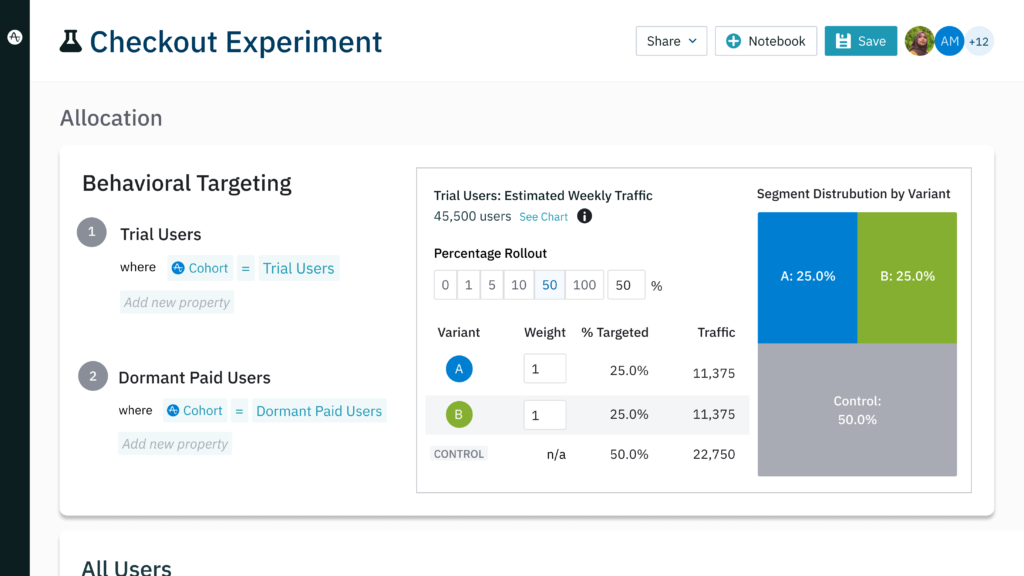

A execução de uma série de testes A/B minimiza o risco de fazer alterações radicais testando primeiro um segmento menor de sua base de usuários. Por exemplo, você pode criar um pequeno segmento de novos usuários no Amplitude Experiment e afunilá-los pela nova iteração do seu produto com a guia realocada.

Ao mesmo tempo, você pode criar um grupo semelhante de novos usuários, mas rastreá-los à medida que usam sua versão existente. Ao final do experimento, você pode comparar os comportamentos do grupo experimental com os comportamentos do seu grupo de controle para ver qual versão do seu produto produz os melhores resultados.

Para ter uma ideia de como os clientes existentes reagirão à alteração em relação aos novos usuários, você deve repetir o experimento. Desta vez, substitua os grupos experimentais e de controle por segmentos de usuários existentes. Ao executar o experimento várias vezes usando segmentos diferentes, você aumenta as chances de que suas alterações estimulem a adoção de seu produto em vez de provocar a rotatividade.

Otimização de campanhas de marketing

O teste A/B pode ser usado para aumentar o desempenho de seus esforços de marketing. Seus dados comportamentais provavelmente revelarão que os clientes que convertem provavelmente compartilharão comportamentos ou dados demográficos semelhantes. Você sabe quem você quer segmentar, mas os pontos mais delicados provam ser indescritíveis:

- Qual mensagem é mais eficaz para impulsionar as conversões?

- A qual oferta ou incentivo os clientes potenciais ou existentes respondem melhor?

- Um design diferente para um botão de CTA produz mais cliques?

Você pode construir uma campanha com base em sua experiência e instintos e esperar o melhor, mas isso ainda traz riscos. Você pode enviar e-mails ou postagens sociais pagas para as pessoas certas enquanto perde o alvo com sua mensagem. A campanha pode gerar muitas conversões, mas você nunca saberá se as opções que não escolheu teriam gerado mais.

Os testes A/B identificam suas melhores opções de marketing, fornecendo resultados baseados em dados. Uma série de testes A/B pode revelar que os usuários respondem melhor aos CTAs verdes do que aos azuis ou que uma oferta de avaliação gratuita funciona em níveis mais altos do que um desconto único. Esse processo ajuda você a minimizar os gastos que seriam desperdiçados em anúncios de menor desempenho.

Exemplos do mundo real de testes A/B

Como impulsionar as conversões da página de destino

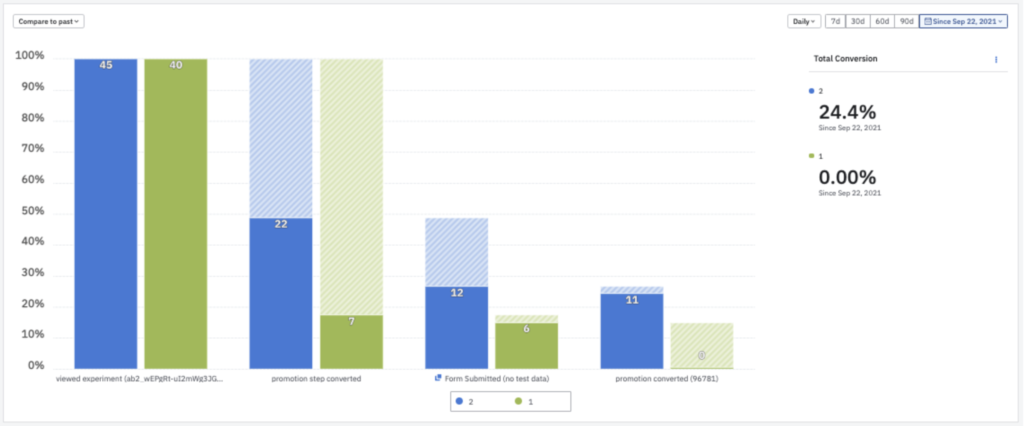

A plataforma de e-sports G-Loot usou testes A/B para melhorar as taxas de conversão de suas páginas de destino para resultados dramáticos. A G-Loot testou alterações em suas páginas de destino orientadas por anúncios e identificou as melhores modificações usando o Amplitude Experiment. Depois de alterar as páginas para refletir o design de melhor desempenho e as variáveis de oferta, as taxas de conversão da página de destino do G-Loot saltaram de 3% para incríveis 35%.

Aumentando a retenção otimizando a experiência do cliente

A NBCUniversal adotou o teste A/B como meio de reduzir o churn. A gigante da mídia testou sua página inicial existente para TVs Vizio em relação às iterações mais recentes. Com a ajuda da Amplitude, a empresa identificou uma nova página inicial que aumentou as visualizações no grupo experimental em 10%. A NBCUniversal adotou a nova página inicial para todos os clientes, um movimento que dobrou a retenção de 7 dias.

Impulsionando a inovação por meio de testes A/B

A solução de análise certa incentiva a experimentação mais frequente, o que, por sua vez, aumenta a agilidade e estimula a inovação. A equipe da GoFundMe costumava levar semanas para analisar os resultados dos testes A/B. Com a capacidade do Amplitude de analisar os resultados em tempo real, o GoFundMe conseguiu aumentar o número de testes executados de dois ou três para 10 por mês. Em vez de ter que escolher quais ideias testar devido a restrições de tempo, a equipe agora pode testar hipóteses à medida que elas se desenvolvem.

3 tipos diferentes de teste A/B - e quando usar cada um

Além dos testes A/B convencionais, existem três tipos de testes A/B que podem ser aproveitados dependendo da situação:

Teste de URL dividido

Ajustar um botão na sua página inicial é uma coisa, mas o que acontece se você quiser testar um design de página totalmente novo? O teste de URL dividida pega o conceito de teste A/B e o expande para uma escala maior. Esse tipo de teste cria uma URL totalmente separada para que você possa redesenhar completamente uma página da Web do zero. Seu grupo experimental pode ser canalizado para esta nova página para que os resultados possam ser comparados com o seu existente.

O teste de URL dividido e o teste A/B tradicional podem ser usados juntos para otimizar o desempenho da página. Um teste de URL dividido revelará qual dos dois designs da página em questão tem o melhor desempenho. A partir daí, uma série de testes A/B tradicionais pode testar a preferência do usuário para obter detalhes mais minuciosos, como cópia do CTA, tamanho da fonte ou imagens.

Testes multivariados

Esse tipo de experimento testa opções que contêm mais de uma variável. Um teste A/B tradicional pode avaliar qual dos dois tamanhos de botão CTA é o preferido. Comparativamente, um teste multivariado pode incluir diferentes tamanhos de CTA, títulos e imagens, permitindo que você determine qual de uma série de opções tem o melhor desempenho para sua campanha.

O teste multivariado é útil para confirmar ou negar suas suposições sobre qual ativo dentre muitos terá o melhor desempenho. Você pode acreditar que uma certa combinação de elementos de design funciona melhor para sua base de destino. Ao criar versões com variáveis alternativas, você pode testar seu design preferido em relação a muitos outros para obter uma descrição honesta do que tem melhor desempenho.

A principal desvantagem do teste multivariado é que cada variável adicional adiciona outra versão do ativo que precisa ser criado. Se você quiser testar cinco formas diferentes de botão de CTA, quatro cores de botão de CTA e três fontes diferentes, precisará criar 60 (!) ativos de teste diferentes para cobrir todas as suas bases.

Teste de várias páginas

Um teste de várias páginas mede o sucesso de uma versão alternativa de fluxos de trabalho ou funil. Alterações abrangentes podem ser feitas em várias páginas em uma sequência para criar um funil separado que pode ser testado em relação ao original. Um teste de várias páginas também é apropriado em situações em que você deseja simplesmente adicionar ou remover um elemento de cada página de um fluxo ou funil e testar os efeitos.

Digamos que a sequência de checkout do seu site de comércio eletrônico seja assim:

Carrinho de compras (A)→ Informações de pagamento (A)→ Informações de envio (A)→ Revisar pedido (A) → Enviar pedido (A)

Você está curioso para saber se mover o botão “Próximo passo” nas três primeiras páginas ajuda ou prejudica as taxas de compra. Você poderia, teoricamente, testar cada página individualmente, mas os clientes não experimentam essas páginas isoladamente. Eles se movem de uma página para a próxima em sequência.

Você sabe que os resultados de sua experiência serão mais precisos se você testar as páginas em ordem. Por isso, você cria variações da sua sequência de compra para que seu funil experimental fique assim:

Carrinho de compras (B)→ Informações de pagamento (B)→ Informações de envio (B)→ Revisar pedido (A) → Enviar pedido (A)

Como qualquer variação de teste A/B, o objetivo é determinar qual funil tem melhor desempenho em relação ao original e até mesmo em relação a outras iterações. Depois de testar vários locais para o botão “Próxima etapa”, seu funil final pode ficar mais parecido com isso:

Carrinho de compras (B)→ Informações de pagamento (D)→ Informações de envio (C)→ Revisar pedido (A) → Enviar pedido (A)

A chave para realizar testes A/B

Por mais benéficos que os testes A/B sejam para o design de UI/UX e marketing de produtos, eles precisam ser realizados e avaliados corretamente para liberar seu verdadeiro potencial. As chaves para o sucesso do teste A/B incluem:

Repetibilidade

Às vezes, os testes A/B fornecem resultados tão empolgantes que levam a decisões impulsivas. Uma empresa viu que simplesmente mudar a cor do botão CTA aumentou suas taxas de conversão por um fator de três. Se seu próprio teste A/B resultou em um resultado semelhante, você pode querer executar imediatamente esta versão do seu anúncio, e seria difícil culpá-lo.

No entanto, os resultados do teste são considerados válidos apenas se forem repetíveis. Alcançar os mesmos resultados repetidamente reduz a chance de que seu resultado inicial tenha sido um acaso. Além disso, se você avançar com uma campanha que utiliza botões azuis de CTA sem testar uma versão vermelha, nunca saberá se está realmente usando a melhor opção de CTA.

Segmentação de usuários

A segmentação de usuários é o processo de criação de um subconjunto de usuários específicos para seus testes A/B. Esses grupos de usuários são baseados em clientes com características comportamentais ou demográficas semelhantes. Em muitos testes A/B, você deseja saber como um determinado grupo de clientes reage às mudanças que os afetarão. Nesses casos, testar uma ampla gama de clientes pode realmente diluir o resultado do segmento que você deseja atingir.

Imagine que você está considerando mudanças estéticas no chatbot do seu produto. Você sabe que é extremamente improvável que os clientes que usaram seu produto por mais de três meses usem o recurso, portanto, incluí-los em um teste A/B não faz sentido. Em vez disso, você deve criar um segmento de usuários que usaram seu produto por menos de três meses para ter uma melhor noção de como suas alterações de design afetam aqueles que o usarão.

O Amplitude Recommend pode até criar uma coorte de clientes com maior probabilidade de realizar uma determinada ação no futuro. Isso significa que você pode construir um segmento feito inteiramente de novos usuários que foram analiticamente previstos para usar o chatbot com base em comportamentos anteriores. Um teste A/B usando uma coorte preditiva tem uma probabilidade muito maior de incluir os usuários que você deseja segmentar e excluir pessoas que não estão interessadas em usar um chatbot.

Testando seu teste

Se você construir seu teste A/B errado, todos os seus testes serão em vão. Um teste falho pode resultar em resultados que não fazem sentido, apesar da segmentação do usuário e dos testes repetidos. Certamente, os clientes se comportam de forma imprevisível de tempos em tempos, mas geralmente há um padrão em seu comportamento.

Em vez de criar dois grupos e afunilá-los para duas experiências separadas, teste seu produto contra si mesmo no que às vezes é chamado de “teste A/A”. Em teoria, os resultados de um teste A/A devem ser notavelmente semelhantes, pois não há variação entre as duas jornadas. Se os resultados voltarem distorcidos, é hora de detalhar seu experimento e fazer uma análise passo a passo de onde o problema está ocorrendo.

3 erros comuns de teste A/B (e como evitá-los)

Os testes A/B fornecem informações valiosas, desde que sejam executados corretamente. Resultados incorretos podem distorcer os resultados e levar as equipes a tomar decisões importantes com base em dados incorretos. Alguns dos erros de teste A/B mais comuns incluem:

1. Testando várias variáveis em um único teste A/B

Um teste A/B é projetado para testar uma variável de cada vez. Limitar as opções A e B a uma única alteração permite que você saiba com certeza que essa alteração específica foi responsável pelo resultado final.

Alterar várias variáveis abre os resultados do teste para interpretação. Por exemplo, alterar três recursos estéticos pode produzir um resultado melhor para o anúncio A em relação ao anúncio B, mas não há como saber se todas as três alterações foram responsáveis pelo melhor desempenho. Quando testado individualmente, você pode descobrir que duas das alterações realmente prejudicaram o desempenho e a terceira alteração foi a única responsável pela maior taxa de conversão.

Faça um favor a si mesmo e mantenha as coisas simples: limite-se a uma variação por teste A/B.

2. Teste muito cedo

Se você acabou de configurar uma nova página de destino, vale a pena adiar o teste A/B por um tempo. Alterar elementos em uma nova página imediatamente impede que você colete as métricas necessárias sobre o desempenho da iteração original. Sem uma linha de base estabelecida, você não tem os dados certos para testar as alterações.

3. Chamando um teste prematuramente

Você pode ficar tentado a declarar sucesso depois de apenas alguns dias com base em resultados promissores. No entanto, é melhor deixar os testes serem executados por pelo menos algumas semanas para obter dados mais confiáveis. Um fator tão simples como o dia da semana ou um feriado pode fornecer resultados distorcidos. Testes por várias semanas podem fornecer uma imagem mais realista de como os clientes reagem às suas mudanças ao longo do tempo.

Potencialize seus testes A/B com dados do cliente

Dados históricos, demográficos e comportamentais são usados em testes A/B massivos por algumas das maiores empresas do mundo. A Amazon usa testes A/B para determinar a eficácia de sua poderosa máquina de recomendação. A Netflix aproveitou os testes A/B para justificar a criação de suas listas Top 10. Considerando os sucessos que a Amazon e a Netflix tiveram em seus respectivos setores, vale a pena adicionar testes A/B ao seu cinto de ferramentas de gerenciamento de produtos.

Referências

- 24 dos testes A/B mais surpreendentes de todos os tempos , WordStream. 08 de julho de 2021.

- Uso de testes A/B para medir a eficácia das recomendações geradas pelo Amazon Personalize , AWS. 20 de agosto de 2020.

- O que é um teste A/B? O blog de tecnologia da Netflix. 22 de setembro de 2021.