Qu'est-ce qu'un test A/B ? Comment ça marche et quand l'utiliser

Publié: 2022-01-25La méthode de test A/B détermine laquelle des deux versions de quelque chose produit les meilleurs résultats. On parle souvent de « tests fractionnés » parce que les groupes d'utilisateurs sont divisés en deux groupes (le groupe « A » et le groupe « B ») et dirigés vers des expériences numériques distinctes.

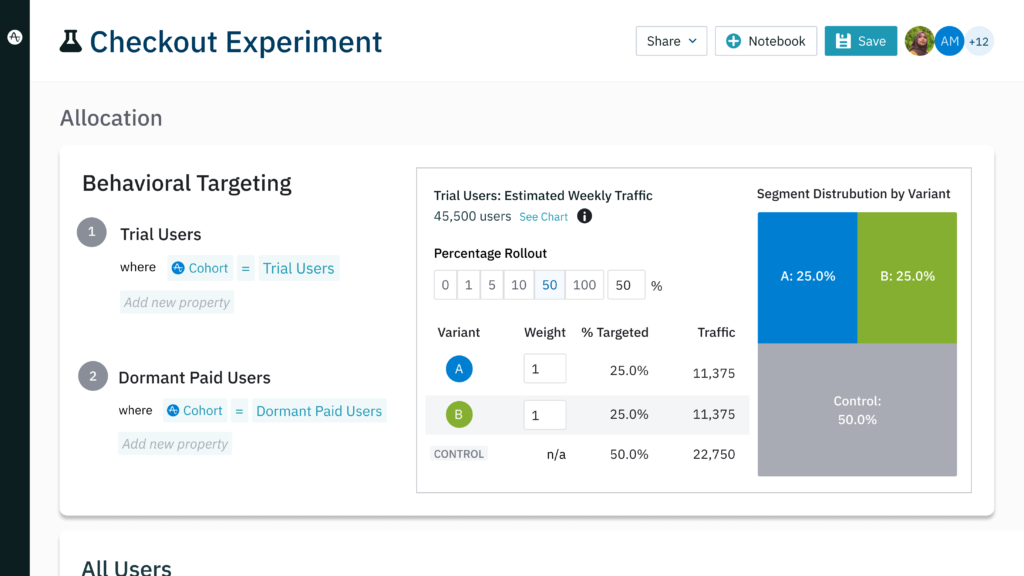

Un test A/B peut vous aider à concevoir des campagnes marketing plus performantes ou à modifier les flux de travail d'intégration des produits. Les modifications apportées à votre produit ou fonctionnalité peuvent être testées sur de petits groupes segmentés appelés cohortes pour vérifier l'efficacité tout en minimisant les frictions.

Les tests A/B sont un outil essentiel et fiable qui peut et doit être utilisé dans diverses situations. Les chefs de produit, les spécialistes du marketing, les concepteurs et bien d'autres qui utilisent activement les tests A/B prennent des décisions fondées sur des données qui génèrent des résultats réels et quantifiables.

Points clés à retenir

- Un test A/B permet de déterminer lequel de deux actifs différents est le plus performant.

- Les tests A/B sont utilisés pour optimiser les campagnes marketing, améliorer l'UI/UX et augmenter les conversions.

- Il existe plusieurs versions de tests A/B pour tester des pages individuelles, plusieurs variables et des flux de travail et des entonnoirs entiers.

- Les tests A/B doivent être segmentés, validés et reproductibles pour un maximum de résultats.

Quels sont les avantages des tests A/B ?

Les tests A/B répondent à une question fondamentale : les clients préfèrent-ils l'option 1 ou l'option 2 ? Dans le monde des produits numériques, la réponse à cette question est précieuse dans de nombreuses situations, dont deux domaines majeurs : l'amélioration de l'expérience client et l'amélioration des campagnes marketing.

Amélioration de l'UI/UX

Des modifications bien intentionnées de l'interface utilisateur de votre produit peuvent avoir des conséquences involontaires qui créent des frictions pour les utilisateurs. Vous pouvez modifier l'emplacement d'un onglet dans votre application mobile pour attirer de nouveaux utilisateurs, mais frustrer accidentellement les utilisateurs existants habitués à son ancien emplacement.

L'exécution d'une série de tests A/B minimise le risque d'apporter des changements radicaux en testant d'abord un segment plus petit de votre base d'utilisateurs. Par exemple, vous pouvez créer un petit segment de nouveaux utilisateurs dans Amplitude Experiment et les diriger vers la nouvelle itération de votre produit avec l'onglet déplacé.

En même temps, vous pouvez créer un groupe similaire de nouveaux utilisateurs mais les suivre lorsqu'ils utilisent votre version existante. À la fin de l'expérience, vous pouvez comparer les comportements du groupe expérimental avec les comportements de votre groupe de contrôle pour voir quelle version de votre produit produit les meilleurs résultats.

Pour avoir une idée de la façon dont les clients existants réagiront à la modification par rapport aux nouveaux utilisateurs, vous devez répéter l'expérience. Cette fois, remplacez les groupes de test et de contrôle par des segments d'utilisateurs existants. En exécutant l'expérience plusieurs fois en utilisant différents segments, vous augmentez les chances que vos modifications alimentent l'adoption de votre produit au lieu de provoquer un désabonnement.

Optimisation des campagnes marketing

Les tests A/B peuvent être utilisés pour améliorer les performances de vos efforts marketing. Vos données comportementales sont susceptibles de révéler que les clients qui se convertissent sont susceptibles de partager des comportements ou des données démographiques similaires. Vous savez qui vous voulez cibler, mais les subtilités s'avèrent insaisissables :

- Quel message s'avère le plus efficace pour alimenter les conversions ?

- À quelle offre ou incitation les clients potentiels ou existants répondent-ils le mieux ?

- Un design différent pour un bouton CTA produit-il plus de clics ?

Vous pouvez construire une campagne basée sur votre expérience et votre instinct et espérer le meilleur, mais cela comporte toujours des risques. Vous pouvez diffuser des e-mails ou des publications sociales payantes aux bonnes personnes tout en manquant la cible avec votre message. La campagne peut générer de nombreuses conversions, mais vous ne saurez jamais si les options que vous n'avez pas choisies auraient rapporté davantage.

Les tests A/B identifient vos meilleures options marketing en fournissant des résultats étayés par des données. Une série de tests A/B peut révéler que les utilisateurs répondent mieux aux CTA verts qu'aux bleus ou qu'une offre d'essai gratuite est plus performante qu'une remise unique. Ce processus vous aide à minimiser les dépenses qui auraient été gaspillées sur des publicités moins performantes.

Exemples concrets de tests A/B

Stimuler les conversions de la page de destination

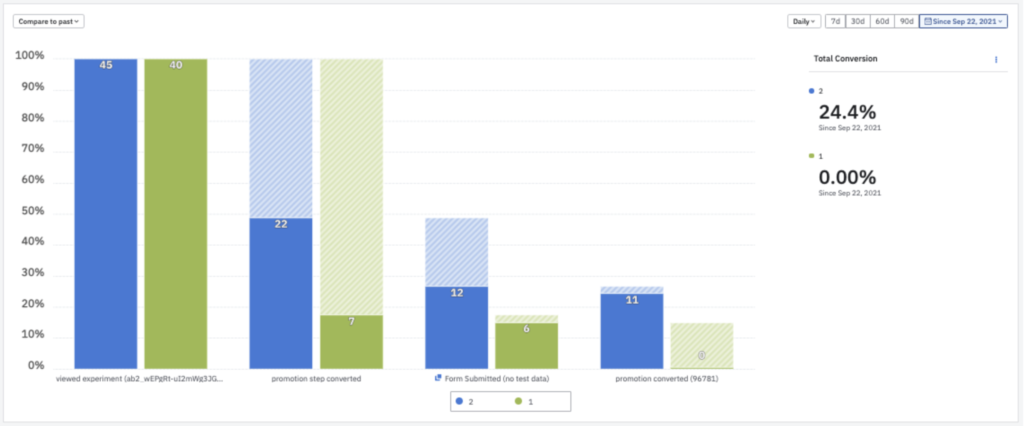

La plate-forme d'esports G-Loot a utilisé les tests A/B pour améliorer les taux de conversion de ses pages de destination avec des résultats spectaculaires. G-Loot a testé les modifications apportées à ses pages de destination pilotées par la publicité et a identifié les meilleures modifications à l'aide d'Amplitude Experiment. Après avoir modifié les pages pour refléter les variables de conception et d'offre les plus performantes, les taux de conversion des pages de destination de G-Loot sont passés de 3 % à un incroyable 35 %.

Augmenter la rétention en optimisant l'expérience client

NBCUniversal a adopté les tests A/B comme moyen de réduire le taux de désabonnement. Le géant des médias a testé sa page d'accueil existante pour les téléviseurs Vizio par rapport aux nouvelles itérations. Avec l'aide d'Amplitude, l'entreprise a identifié une nouvelle page d'accueil qui a augmenté de 10 % le nombre de vues dans le groupe expérimental. NBCUniversal a adopté la nouvelle page d'accueil pour tous les clients, une décision qui a doublé la rétention de 7 jours.

Stimuler l'innovation grâce aux tests A/B

La bonne solution d'analyse encourage une expérimentation plus fréquente, ce qui à son tour augmente l'agilité et alimente l'innovation. L'équipe de GoFundMe avait besoin de plusieurs semaines pour analyser les résultats des tests A/B. Grâce à la capacité d'Amplitude à analyser les résultats en temps réel, GoFundMe a pu augmenter le nombre de tests effectués de deux ou trois à 10 par mois. Au lieu de devoir choisir les idées à tester en raison de contraintes de temps, l'équipe peut désormais tester les hypothèses au fur et à mesure qu'elles se développent.

3 types différents de tests A/B et quand les utiliser

Outre les tests A/B classiques, il existe trois types de tests A/B qui peuvent être exploités en fonction de la situation :

Test d'URL fractionnée

Modifier un bouton sur votre page d'accueil est une chose, mais que se passe-t-il si vous souhaitez tester une toute nouvelle conception de page ? Le test d'URL fractionnée reprend le concept de test A/B et l'étend à une plus grande échelle. Ce type de test crée une URL entièrement distincte afin que vous puissiez complètement reconcevoir une page Web à partir de zéro. Votre groupe expérimental peut ensuite être redirigé vers cette nouvelle page afin que les résultats puissent être comparés à votre groupe existant.

Les tests d'URL fractionnés et les tests A/B traditionnels peuvent être utilisés ensemble pour optimiser les performances de la page. Un test d'URL partagée révélera laquelle des deux conceptions de la page en question est la plus performante. À partir de là, une série de tests A/B traditionnels peut tester les préférences de l'utilisateur pour des détails plus minutieux tels que la copie CTA, la taille de la police ou les images.

Tests multivariés

Ce type d'expérience teste les options qui contiennent plusieurs variables. Un test A/B traditionnel peut évaluer laquelle des deux tailles de bouton CTA est préférée. Comparativement, un test multivarié peut inclure différentes tailles, titres et images de CTA, vous permettant de déterminer laquelle parmi une multitude d'options est la plus performante pour votre campagne.

Les tests multivariés sont utiles pour confirmer ou infirmer vos hypothèses quant à l'actif parmi d'autres qui fonctionnera le mieux. Vous pensez peut-être qu'une certaine combinaison d'éléments de conception fonctionne mieux pour votre base cible. En créant des versions avec des variables alternatives, vous pouvez tester votre conception préférée par rapport à de nombreuses autres pour un compte rendu honnête de ce qui fonctionne le mieux.

Le principal inconvénient des tests multivariés est que chaque variable supplémentaire ajoute une autre version de l'actif qui doit être créé. Si vous souhaitez tester cinq formes de boutons CTA différentes, quatre couleurs de boutons CTA et trois polices différentes, vous devrez créer 60 (!) ressources de test différentes pour couvrir toutes vos bases.

Test multipage

Un test de plusieurs pages évalue le succès d'une version alternative des flux de travail ou de l'entonnoir. Des modifications radicales peuvent être apportées à plusieurs pages dans une séquence pour créer un entonnoir séparé qui peut être testé par rapport à l'original. Un test multipage est également approprié dans les situations où vous souhaitez simplement ajouter ou supprimer un élément de chaque page d'un flux ou d'un entonnoir et tester les effets.

Supposons que la séquence de paiement de votre site Web de commerce électronique ressemble à ceci :

Panier (A)→ Informations de paiement (A)→ Informations d'expédition (A)→ Vérifier la commande (A) → Soumettre la commande (A)

Vous êtes curieux de savoir si le déplacement du bouton "Étape suivante" sur les trois premières pages aide ou nuit aux taux d'achat. Vous pouvez théoriquement tester chaque page individuellement, mais les clients ne découvrent pas ces pages de manière isolée. Ils passent d'une page à l'autre dans l'ordre.

Vous savez que les résultats de votre test seront plus précis si vous testez les pages dans l'ordre. Pour cette raison, vous créez des variantes de votre séquence d'achat afin que votre entonnoir expérimental ressemble à ceci :

Panier (B)→ Informations de paiement (B)→ Informations d'expédition (B)→ Vérifier la commande (A) → Soumettre la commande (A)

Comme toute variante de test A/B, l'objectif est de déterminer quel entonnoir fonctionne le mieux par rapport à l'original et même aux autres itérations. Après avoir testé un certain nombre d'emplacements pour votre bouton « Étape suivante », votre entonnoir final pourrait ressembler davantage à ceci :

Panier (B)→ Informations de paiement (D)→ Informations d'expédition (C)→ Vérifier la commande (A) → Soumettre la commande (A)

La clé pour effectuer des tests A/B

Aussi bénéfiques que soient les tests A/B pour la conception UI/UX et le marketing produit, ils doivent être effectués et évalués correctement pour libérer leur véritable potentiel. Les clés du succès des tests A/B incluent :

Répétabilité

Parfois, les tests A/B fournissent des résultats si excitants qu'ils conduisent à des décisions impulsives. Une entreprise a constaté que le simple fait de changer la couleur de son bouton CTA augmentait ses taux de conversion par un facteur de trois. Si votre propre test A/B a abouti à un résultat similaire, vous voudrez peut-être exécuter immédiatement cette version de votre annonce, et il serait difficile de vous en vouloir.

Cependant, les résultats des tests ne sont considérés comme valides que s'ils sont reproductibles. Obtenir les mêmes résultats encore et encore réduit le risque que votre résultat initial soit un hasard. De plus, si vous avancez avec une campagne qui utilise des boutons CTA bleus sans tester une version rouge, vous ne saurez jamais si vous utilisez vraiment la meilleure option CTA.

Segmentation des utilisateurs

La segmentation des utilisateurs est le processus de création d'un sous-ensemble d'utilisateurs spécifiques pour vos tests A/B. Ces groupes d'utilisateurs sont basés sur des clients ayant des caractéristiques comportementales ou démographiques similaires. Dans de nombreux tests A/B, vous souhaitez savoir comment un groupe particulier de clients réagit aux changements qui les affecteront. Dans ces cas, tester un large éventail de clients peut en fait diluer le résultat du segment que vous souhaitez cibler.

Imaginez que vous envisagez des modifications esthétiques du chatbot de votre produit. Vous savez que les clients qui utilisent votre produit depuis plus de trois mois sont extrêmement peu susceptibles d'utiliser la fonctionnalité, donc les inclure dans un test A/B n'a aucun sens. Au lieu de cela, vous devez créer un segment d'utilisateurs qui utilisent votre produit depuis moins de trois mois pour avoir la meilleure idée de la façon dont vos modifications de conception affectent ceux qui l'utiliseront.

Amplitude Recommend peut même créer une cohorte de clients les plus susceptibles d'effectuer une certaine action à l'avenir. Cela signifie que vous pouvez créer un segment entièrement composé de nouveaux utilisateurs qui ont été analytiquement prédits pour utiliser le chatbot en fonction des comportements passés. Un test A/B utilisant une cohorte prédictive a une probabilité beaucoup plus élevée d'inclure les utilisateurs que vous souhaitez cibler tout en excluant les personnes qui ne sont pas intéressées par l'utilisation d'un chatbot.

Tester votre test

Si vous construisez mal votre test A/B, tous vos tests ne serviront à rien. Un test défectueux peut entraîner des résultats qui n'ont pas de sens malgré la segmentation des utilisateurs et des tests répétés. Certes, les clients se comportent de temps en temps de manière imprévisible, mais il existe généralement un modèle dans leur comportement.

Au lieu de créer deux groupes et de les canaliser vers deux expériences distinctes, testez votre produit contre lui-même dans ce que l'on appelle parfois un « test A/A ». En théorie, les résultats d'un test A/A devraient être remarquablement similaires puisqu'il n'y a pas de variation entre les deux trajets. Si les résultats reviennent faussés, il est temps de décomposer votre expérience en détails et de faire une analyse étape par étape de l'endroit où le problème se produit.

3 erreurs courantes de test A/B (et comment les éviter)

Les tests A/B fournissent des informations précieuses tant qu'ils sont effectués correctement. Des résultats incorrects peuvent fausser les résultats et amener les équipes à prendre des décisions importantes basées sur de mauvaises données. Certaines des erreurs de test A/B les plus courantes incluent :

1. Tester plusieurs variables dans un seul test A/B

Un test A/B est conçu pour tester une variable à la fois. Limiter les choix A et B à un seul changement vous permet de savoir avec certitude que cette modification spécifique était responsable du résultat final.

La modification de plusieurs variables ouvre les résultats des tests à l'interprétation. Par exemple, la modification de trois caractéristiques esthétiques pourrait produire un meilleur résultat pour l'annonce A par rapport à l'annonce B, mais il n'y aurait aucun moyen de savoir si les trois modifications étaient responsables de la meilleure performance. Lors d'un test individuel, vous constaterez peut-être que deux des modifications nuisent en fait aux performances et que la troisième modification est la seule responsable du taux de conversion plus élevé.

Rendez-vous service et restez simple : limitez-vous à une variation par test A/B.

2. Tester trop tôt

Si vous venez de configurer une nouvelle page de destination, il est avantageux de suspendre les tests A/B pendant un certain temps. La modification immédiate d'éléments sur une nouvelle page vous empêche de collecter les mesures nécessaires sur les performances de l'itération d'origine. Sans base de référence établie, vous ne disposez pas des bonnes données pour tester les modifications.

3. Appeler un test prématurément

Vous pourriez être tenté de déclarer le succès après seulement quelques jours sur la base de résultats prometteurs. Cependant, il est préférable de laisser les tests s'exécuter pendant au moins deux semaines pour obtenir des données plus fiables. Un facteur aussi simple que le jour de la semaine ou un jour férié peut donner des résultats biaisés. Des tests sur plusieurs semaines peuvent fournir une image plus réaliste de la façon dont les clients réagissent à vos modifications au fil du temps.

Alimentez vos tests A/B avec les données clients

Les données historiques, démographiques et comportementales sont utilisées dans des tests A/B massifs par certaines des plus grandes entreprises du monde. Amazon utilise des tests A/B pour déterminer l'efficacité de sa puissante machine de recommandation. Netflix a exploité les tests A/B pour justifier la création de ses listes du Top 10. Compte tenu des succès d'Amazon et de Netflix dans leurs secteurs respectifs, il vaut la peine d'ajouter des tests A/B à votre ceinture d'outils de gestion de produits.

Références

- 24 des tests A/B les plus surprenants de tous les temps , WordStream. 08 juillet 2021.

- Utilisation des tests A/B pour mesurer l'efficacité des recommandations générées par Amazon Personalize , AWS. 20 août 2020.

- Qu'est-ce qu'un test A/B ? Le blog technique de Netflix. 22 septembre 2021.