Che cos'è il test A/B? Come funziona e quando usarlo

Pubblicato: 2022-01-25Il metodo di test A/B determina quale delle due versioni di qualcosa produce i risultati migliori. Viene spesso definito "test diviso" perché i gruppi di utenti vengono divisi in due gruppi (il gruppo "A" e il gruppo "B") e incanalati in esperienze digitali separate.

Un test A/B può aiutarti a creare campagne di marketing con prestazioni migliori o a modificare i flussi di lavoro di onboarding dei prodotti. Le modifiche al prodotto o alla funzionalità possono essere testate su piccoli gruppi segmentati chiamati coorti per verificarne l'efficacia riducendo al minimo l'attrito.

Il test A/B è uno strumento vitale e affidabile che può e deve essere utilizzato in una varietà di situazioni. Product manager, esperti di marketing, designer e altro ancora che utilizzano attivamente i test A/B prendono decisioni basate sui dati che portano a risultati reali e quantificabili.

Da asporto chiave

- Un test A/B aiuta a determinare quale delle due diverse risorse ha prestazioni migliori.

- I test A/B vengono utilizzati per ottimizzare le campagne di marketing, migliorare l'interfaccia utente/UX e aumentare le conversioni.

- Esistono più versioni di test A/B per testare singole pagine, più variabili e interi flussi di lavoro e canalizzazioni.

- I test A/B devono essere segmentati, convalidati e ripetibili per ottenere i massimi risultati.

Quali sono i vantaggi del test A/B?

I test A/B rispondono a una domanda fondamentale: i clienti preferiscono l'Opzione 1 o l'Opzione 2? Nel mondo dei prodotti digitali, la risposta a questa domanda è preziosa in diverse situazioni, inclusi due campi principali: migliorare l'esperienza del cliente e potenziare le campagne di marketing.

Miglioramento dell'interfaccia utente/UX

Modifiche ben intenzionate all'interfaccia utente del tuo prodotto possono avere conseguenze non intenzionali che creano attrito per gli utenti. Puoi modificare la posizione di una scheda nella tua app mobile per attirare nuovi utenti ma frustrare accidentalmente gli utenti esistenti abituati al suo posto precedente.

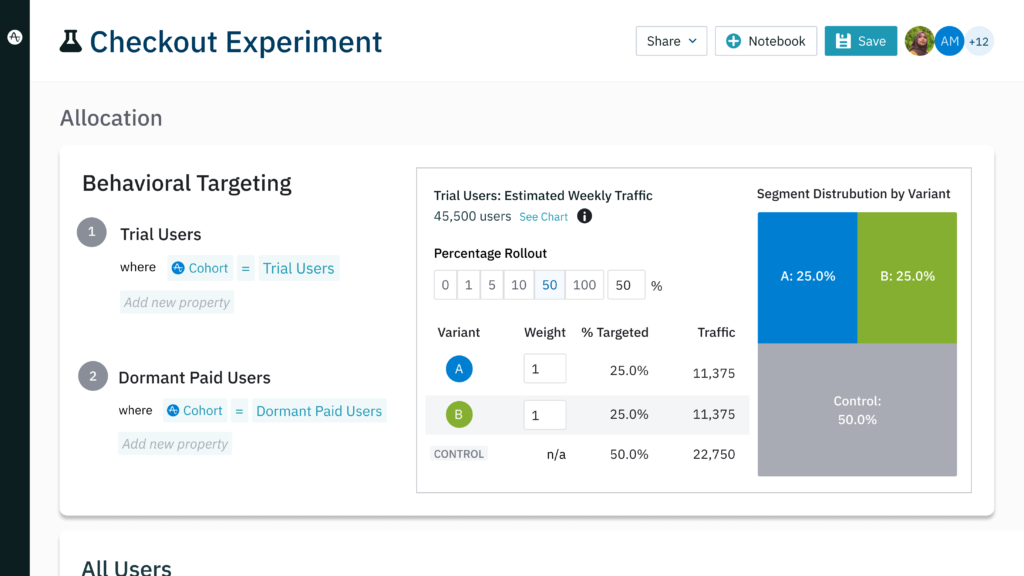

L'esecuzione di una serie di test A/B riduce al minimo il rischio di apportare modifiche radicali testando prima un segmento più piccolo della base di utenti. Ad esempio, puoi creare un piccolo segmento di nuovi utenti in Amplitude Experiment e incanalarli attraverso la nuova iterazione del tuo prodotto con la scheda spostata.

Allo stesso tempo, puoi creare un gruppo simile di nuovi utenti ma monitorarli mentre utilizzano la tua versione esistente. Alla fine dell'esperimento, puoi confrontare i comportamenti del gruppo sperimentale con i comportamenti del tuo gruppo di controllo per vedere quale versione del tuo prodotto produce i risultati migliori.

Per avere un'idea di come i clienti esistenti reagiranno all'alterazione rispetto ai nuovi utenti, dovresti ripetere l'esperimento. Questa volta, sostituisci i gruppi sperimentali e di controllo con segmenti di utenti esistenti. Eseguendo l'esperimento più volte utilizzando segmenti diversi, aumenti le possibilità che le tue modifiche alimentino l'adozione del tuo prodotto invece di suscitare abbandono.

Ottimizzazione delle campagne di marketing

Il test A/B può essere utilizzato per aumentare le prestazioni dei tuoi sforzi di marketing. È probabile che i tuoi dati comportamentali rivelino che è probabile che i clienti che convertono condividano comportamenti o dati demografici simili. Sai chi vuoi prendere di mira, ma i punti più fini si rivelano sfuggenti:

- Quale messaggio si rivela più efficace nell'alimentare le conversioni?

- A quale offerta o incentivo rispondono meglio i clienti potenziali o esistenti?

- Un design diverso per un pulsante CTA produce più clic?

Potresti costruire una campagna basata sulla tua esperienza e sul tuo istinto e sperare per il meglio, ma questo comporta comunque dei rischi. Puoi inviare e-mail o post social a pagamento alle persone giuste mentre manchi l'obiettivo con il tuo messaggio. La campagna può generare molte conversioni, ma non saprai mai se le opzioni che non hai scelto avrebbero portato di più.

I test A/B identificano le migliori opzioni di marketing fornendo risultati supportati dai dati. Una serie di test A/B può rivelare che gli utenti rispondono meglio alle CTA verdi rispetto a quelle blu o che un'offerta di prova gratuita ha prestazioni superiori rispetto a uno sconto una tantum. Questo processo ti aiuta a ridurre al minimo la spesa che sarebbe stata sprecata per annunci con prestazioni inferiori.

Esempi reali di test A/B

Aumentare le conversioni della pagina di destinazione

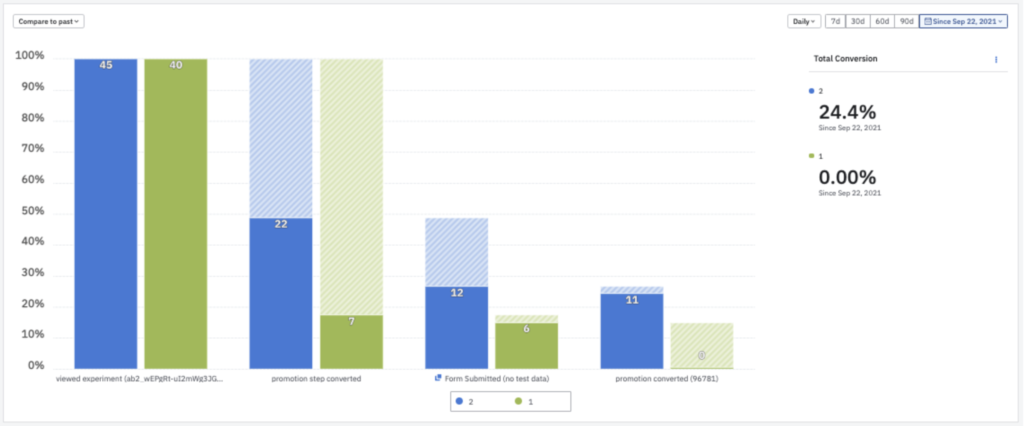

La piattaforma di eSport G-Loot ha utilizzato i test A/B per migliorare i tassi di conversione della pagina di destinazione con risultati sorprendenti. G-Loot ha testato le modifiche alle sue pagine di destinazione basate su annunci e ha identificato le migliori modifiche utilizzando Amplitude Experiment. Dopo aver modificato le pagine per riflettere il design più performante e le variabili dell'offerta, i tassi di conversione della pagina di destinazione di G-Loot sono balzati dal tre percento a un incredibile 35%.

Aumentare la fidelizzazione ottimizzando l'esperienza del cliente

NBCUniversal ha adottato il test A/B come mezzo per ridurre l'abbandono. Il gigante dei media ha testato la sua home page esistente per i televisori Vizio rispetto alle nuove iterazioni. Con l'aiuto di Amplitude, l'azienda ha identificato una nuova home page che ha aumentato del 10% le visualizzazioni nel gruppo sperimentale. NBCUniversal ha adottato la nuova home page per tutti i clienti, una mossa che ha raddoppiato la fidelizzazione di 7 giorni.

Guidare l'innovazione attraverso i test A/B

La giusta soluzione di analisi incoraggia una sperimentazione più frequente, che a sua volta aumenta l'agilità e alimenta l'innovazione. Il team di GoFundMe richiedeva settimane per analizzare i risultati dei test A/B. Grazie alla capacità di Amplitude di analizzare i risultati in tempo reale, GoFundMe è stata in grado di aumentare il numero di test eseguiti da due o tre a 10 al mese. Invece di dover scegliere quali idee testare a causa dei limiti di tempo, il team può ora testare le ipotesi mentre si sviluppano.

3 diversi tipi di test A/B e quando utilizzarli

Oltre ai test A/B convenzionali, ci sono tre tipi di test A/B che possono essere sfruttati a seconda della situazione:

Test URL diviso

Modificare un pulsante sulla tua home page è una cosa, ma cosa succede se vuoi testare un design di pagina completamente nuovo? Il test dell'URL diviso prende il concetto di test A/B e lo espande su una scala più ampia. Questo tipo di test crea un URL completamente separato in modo da poter riprogettare completamente una pagina Web da zero. Il tuo gruppo sperimentale può quindi essere incanalato in questa nuova pagina in modo che i risultati possano essere confrontati con quello esistente.

Il test dell'URL diviso e il tradizionale test A/B possono essere utilizzati insieme per ottimizzare le prestazioni della pagina. Un test URL diviso rivelerà quale dei due design della pagina in questione funziona meglio. Da lì, una serie di test A/B tradizionali può testare le preferenze dell'utente per dettagli più minuti come la copia CTA, la dimensione del carattere o le immagini.

Test multivariato

Questo tipo di esperimento verifica le opzioni che contengono più di una variabile. Un test A/B tradizionale può valutare quale delle due dimensioni dei pulsanti CTA è preferita. In confronto, un test multivariato potrebbe includere diverse dimensioni, titoli e immagini CTA, consentendoti di determinare quale di una serie di opzioni funziona meglio per la tua campagna.

Il test multivariato è utile per confermare o negare le tue ipotesi su quale risorsa tra molte funzionerà meglio. Potresti credere che una certa combinazione di elementi di design funzioni meglio per la tua base di destinazione. Creando versioni con variabili alternative, puoi testare il tuo design preferito rispetto a molti altri per un resoconto onesto di ciò che funziona meglio.

Lo svantaggio principale del test multivariato è che ogni variabile aggiuntiva aggiunge un'altra versione dell'asset che deve essere creata. Se desideri testare cinque diverse forme dei pulsanti CTA, quattro colori dei pulsanti CTA e tre diversi tipi di carattere, dovrai creare 60 (!) diverse risorse di prova per coprire tutte le tue basi.

Test multipagina

Un test multipagina misura il successo di una versione alternativa dei flussi di lavoro o della canalizzazione. È possibile apportare modifiche sostanziali a più pagine in sequenza per creare un imbuto separato che può essere testato rispetto all'originale. Un test multipagina è appropriato anche in situazioni in cui desideri semplicemente aggiungere o rimuovere un elemento da ogni pagina di un flusso o canalizzazione e testarne gli effetti.

Supponiamo che la sequenza di pagamento per il tuo sito di e-commerce sia simile a questa:

Carrello (A)→ Informazioni sul pagamento (A)→ Informazioni sulla spedizione (A)→ Rivedi l'ordine (A) → Invia l'ordine (A)

Sei curioso di sapere se spostare il pulsante "Passaggio successivo" nelle prime tre pagine aiuta o riduce i tassi di acquisto. In teoria potresti testare ogni pagina individualmente, ma i clienti non sperimentano queste pagine isolatamente. Si spostano da una pagina all'altra in sequenza.

Sai che i risultati del tuo esperimento saranno più accurati se testi le pagine in ordine. Per questo motivo, crei variazioni della tua sequenza di acquisto in modo che la tua canalizzazione sperimentale assomigli a questa:

Carrello (B)→ Informazioni sul pagamento (B)→ Informazioni sulla spedizione (B)→ Rivedi l'ordine (A) → Invia l'ordine (A)

Come qualsiasi variazione del test A/B, l'obiettivo è determinare quale canalizzazione ha le migliori prestazioni rispetto all'originale e anche rispetto ad altre iterazioni. Dopo aver testato un certo numero di posizioni per il tuo pulsante "Passaggio successivo", la tua canalizzazione finale potrebbe assomigliare di più a questa:

Carrello (B)→ Informazioni sul pagamento (D)→ Informazioni sulla spedizione (C)→ Rivedi l'ordine (A) → Invia l'ordine (A)

La chiave per condurre test A/B

Per quanto i test A/B siano utili per la progettazione dell'interfaccia utente/UX e per il marketing del prodotto, devono essere eseguiti e valutati correttamente per sbloccare il loro vero potenziale. Le chiavi del successo del test A/B includono:

Ripetibilità

A volte, i test A/B forniscono risultati così entusiasmanti da portare a decisioni impulsive. Un'azienda ha notato che la semplice modifica del colore del pulsante CTA ha aumentato i tassi di conversione di un fattore tre. Se il tuo test A/B ha prodotto un risultato simile, potresti voler eseguire immediatamente questa versione del tuo annuncio e sarebbe difficile biasimarti.

Tuttavia, i risultati dei test sono considerati validi solo se ripetibili. Ottenere gli stessi risultati più e più volte riduce la possibilità che il risultato iniziale sia stato un colpo di fortuna. Inoltre, se vai avanti con una campagna che utilizza i pulsanti CTA blu senza testare una versione rossa, non saprai mai se stai veramente utilizzando la migliore opzione CTA.

Segmentazione degli utenti

La segmentazione degli utenti è il processo di creazione di un sottoinsieme di utenti specifici per i test A/B. Questi gruppi di utenti si basano su clienti con caratteristiche comportamentali o demografiche simili. In molti test A/B, vuoi sapere come reagisce un particolare gruppo di clienti ai cambiamenti che li influenzeranno. In questi casi, testare un'ampia gamma di clienti può effettivamente diluire il risultato dal segmento che desideri raggiungere.

Immagina di prendere in considerazione modifiche estetiche al chatbot del tuo prodotto. Sai che è estremamente improbabile che i clienti che hanno utilizzato il tuo prodotto per più di tre mesi utilizzino la funzione, quindi includerli in un test A/B non ha senso. Invece, dovresti creare un segmento di utenti che hanno utilizzato il tuo prodotto per meno di tre mesi per avere un'idea migliore di come le modifiche al design influiscano su coloro che lo utilizzeranno.

Amplitude Recommend può persino creare una coorte di clienti che molto probabilmente eseguiranno una determinata azione in futuro. Ciò significa che puoi costruire un segmento composto interamente da nuovi utenti che sono stati analiticamente previsti per utilizzare il chatbot in base a comportamenti passati. Un test A/B che utilizza una coorte predittiva ha una probabilità molto maggiore di includere gli utenti a cui vuoi rivolgerti, escludendo le persone che non sono interessate all'uso di un chatbot.

Testare il tuo test

Se costruisci il tuo test A/B in modo errato, tutti i tuoi test sono inutili. Un test imperfetto può portare a risultati che non hanno senso nonostante la segmentazione degli utenti e i test ripetuti. Certamente, i clienti si comportano in modo imprevedibile di tanto in tanto, ma generalmente c'è uno schema nel loro comportamento.

Invece di creare due gruppi e incanalarli in due esperienze separate, testa il tuo prodotto contro se stesso in quello che a volte viene chiamato "test A/A". In teoria, i risultati di un test A/A dovrebbero essere notevolmente simili poiché non vi è alcuna variazione tra i due viaggi. Se i risultati risultano distorti, è il momento di scomporre l'esperimento fino in fondo ed eseguire un'analisi passo passo di dove si sta verificando il problema.

3 errori comuni nei test A/B (e come evitarli)

I test A/B forniscono informazioni preziose a condizione che vengano eseguiti correttamente. Risultati errati possono distorcere i risultati e indurre i team a prendere decisioni importanti sulla base di dati errati. Alcuni degli errori di test A/B più comuni includono:

1. Testare più variabili in un singolo test A/B

Un test A/B è progettato per testare una variabile alla volta. Limitare le scelte A e B ad una singola modifica permette di sapere con certezza che questa specifica alterazione era responsabile del risultato finale.

La modifica di più variabili apre i risultati del test per l'interpretazione. Ad esempio, la modifica di tre caratteristiche estetiche potrebbe produrre un risultato migliore per l'annuncio A rispetto all'annuncio B, ma non ci sarebbe modo di sapere se tutte e tre le modifiche siano responsabili del rendimento migliore. Se testati individualmente, potresti scoprire che due delle modifiche hanno effettivamente influito sulle prestazioni e la terza modifica è stata l'unica responsabile del tasso di conversione più elevato.

Fatti un favore e mantieni le cose semplici: limitati a una variazione per test A/B.

2. Test troppo presto

Se hai appena impostato una nuova pagina di destinazione, vale la pena sospendere i test A/B per un po'. La modifica immediata degli elementi in una nuova pagina impedisce di raccogliere le metriche necessarie sul rendimento dell'iterazione originale. Senza una linea di base stabilita, non hai i dati giusti per testare le modifiche.

3. Chiamare un test prematuramente

Potresti essere tentato di dichiarare il successo dopo solo pochi giorni sulla base di risultati promettenti. Tuttavia, è meglio lasciare che i test vengano eseguiti per almeno un paio di settimane per ottenere dati più affidabili. Un fattore semplice come il giorno della settimana o una vacanza può fornire risultati distorti. I test per diverse settimane possono fornire un quadro più realistico di come i clienti reagiscono alle modifiche nel corso del tempo.

Potenzia i tuoi test A/B con i dati dei clienti

I dati storici, demografici e comportamentali vengono utilizzati in massicci test A/B da alcune delle più grandi aziende del mondo. Amazon utilizza i test A/B per determinare l'efficacia della sua potente macchina di raccomandazione. Netflix ha sfruttato i test A/B per giustificare la creazione delle sue prime 10 liste. Considerando i successi che Amazon e Netflix hanno avuto nei rispettivi settori, vale la pena aggiungere i test A/B alla cintura degli strumenti di gestione del prodotto.

Riferimenti

- 24 dei test A/B più sorprendenti di tutti i tempi , WordStream. 08 luglio 2021.

- Utilizzo di test A/B per misurare l'efficacia dei consigli generati da Amazon Personalize , AWS. 20 agosto 2020.

- Che cos'è un test A/B? Il blog tecnico di Netflix. 22 settembre 2021.