A / Bテストとは何ですか? 仕組みと使用時期

公開: 2022-01-25A / Bテスト方法は、2つのバージョンのどちらが最良の結果をもたらすかを決定します。 ユーザーのグループが2つのグループ(「A」グループと「B」グループ)に分割され、別々のデジタルエクスペリエンスに集中するため、「分割テスト」と呼ばれることがよくあります。

A / Bテストは、パフォーマンスの高いマーケティングキャンペーンを作成したり、製品のオンボーディングワークフローを微調整したりするのに役立ちます。 製品または機能への変更は、摩擦を最小限に抑えながら有効性を検証するために、コホートと呼ばれる小さなセグメント化されたグループでテストできます。

A / Bテストは、さまざまな状況で使用でき、使用する必要がある重要で信頼性の高いツールです。 A / Bテストを積極的に使用する製品マネージャー、マーケター、デザイナーなどは、データに基づいた意思決定を行い、実際の定量化可能な結果を導き出します。

重要なポイント

- A / Bテストは、2つの異なるアセットのどちらがパフォーマンスが優れているかを判断するのに役立ちます。

- A / Bテストは、マーケティングキャンペーンを最適化し、UI / UXを改善し、コンバージョンを増やすために使用されます。

- 個々のページ、複数の変数、およびワークフローと目標到達プロセス全体をテストするためのA/Bテストには複数のバージョンがあります。

- A / Bテストは、最大の結果を得るために、セグメント化、検証、および再現可能である必要があります。

A / Bテストのメリットは何ですか?

A / Bテストは、基本的な質問に答えます。顧客はオプション1とオプション2のどちらを好みますか? デジタル製品の世界では、この質問への回答は、顧客体験の向上とマーケティングキャンペーンの強化という2つの主要な分野を含む多くの状況で価値があります。

UI/UXの改善

製品のUIを意図的に微調整すると、意図しない結果が生じ、ユーザーに摩擦が生じる可能性があります。 モバイルアプリのタブの場所を変更して、新しいユーザーにアピールすることはできますが、以前の場所に慣れている既存のユーザーを誤ってイライラさせる可能性があります。

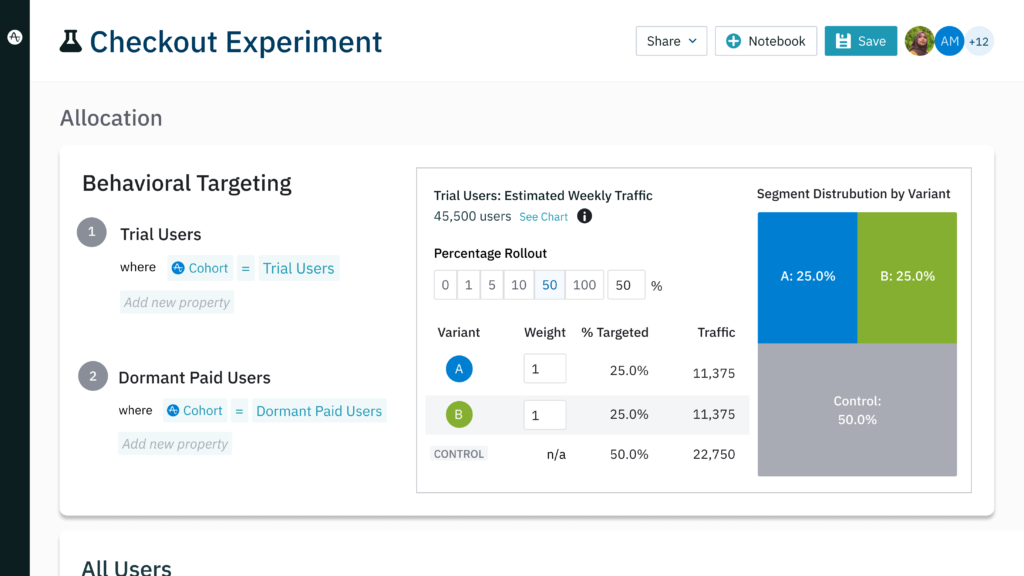

一連のA/Bテストを実行すると、最初にユーザーベースのより小さなセグメントをテストすることで、大幅な変更を行うリスクを最小限に抑えることができます。 たとえば、Amplitude Experimentで新しいユーザーの小さなセグメントを作成し、タブを再配置して製品の新しいイテレーションにそれらを集中させることができます。

同時に、同様の新しいユーザーのグループを作成できますが、既存のバージョンを使用しているため、それらを追跡できます。 実験の最後に、実験グループの動作をコントロールグループの動作と比較して、製品のどのバージョンが最良の結果をもたらすかを確認できます。

既存の顧客が新しいユーザーに対して変更にどのように反応するかを理解するには、実験を繰り返す必要があります。 今回は、実験群と対照群を既存のユーザーのセグメントに置き換えます。 異なるセグメントを使用して実験を複数回実行することにより、チャーンを誘発するのではなく、変更によって製品の採用が促進される可能性が高まります。

マーケティングキャンペーンの最適化

A / Bテストは、マーケティング活動のパフォーマンスを向上させるために使用できます。 あなたの行動データは、コンバージョンを達成した顧客が同様の行動や人口統計を共有している可能性が高いことを明らかにする可能性があります。 あなたはあなたが誰をターゲットにしたいのか知っていますが、より細かい点はとらえどころのないことがわかります:

- コンバージョンを促進するのに最も効果的なメッセージは何ですか?

- 見込み客または既存の顧客が最もよく反応するオファーまたはインセンティブは何ですか?

- CTAボタンのデザインが異なると、クリック数が増えますか?

あなたの経験と本能に基づいてキャンペーンを構築し、最高のものを期待することもできますが、それでもリスクが伴います。 あなたはあなたのメッセージでターゲットを逃しながら、適切な人々に電子メールや有料のソーシャル投稿を爆破することができます。 キャンペーンは多くのコンバージョンを獲得する可能性がありますが、選択しなかったオプションがさらに多くのコンバージョンをもたらしたかどうかはわかりません。

A / Bテストは、データに裏付けられた結果を提供することにより、最適なマーケティングオプションを特定します。 一連のA/Bテストにより、ユーザーが青色のCTAよりも緑色のCTAによく反応すること、または無料の試用版のオファーが1回限りの割引よりも高いレベルで実行されることが明らかになる場合があります。 このプロセスは、パフォーマンスの低い広告に浪費されるであろう支出を最小限に抑えるのに役立ちます。

A/Bテストの実際の例

ランディングページのコンバージョンを促進する

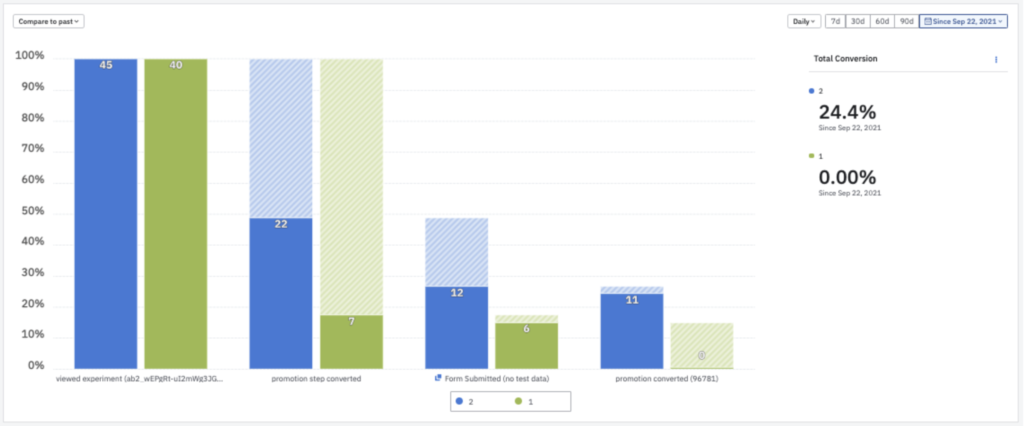

eスポーツプラットフォームのG-Lootは、A / Bテストを使用して、ランディングページのコンバージョン率を劇的な結果に改善しました。 G-Lootは、広告主導のランディングページへの変更をテストし、AmplitudeExperimentを使用して最適な変更を特定しました。 最高のパフォーマンスのデザインとオファー変数を反映するようにページを変更した後、G-Lootのランディングページのコンバージョン率は3%から信じられないほどの35%に跳ね上がりました。

カスタマーエクスペリエンスを最適化することで保持を増やす

NBCUniversalは、解約を減らす手段としてA/Bテストを採用しました。 メディアの巨人は、Vizio TVの既存のホームページを、新しいイテレーションに対してテストしました。 Amplitudeの助けを借りて、同社は実験グループの視聴者数を10%増やした新しいホームページを特定しました。 NBCUniversalは、すべての顧客に新しいホームページを採用しました。これにより、7日間の保存期間が2倍になりました。

A/Bテストによるイノベーションの推進

適切な分析ソリューションは、より頻繁な実験を促進し、それが敏捷性を高め、イノベーションを促進します。 GoFundMeのチームは、A/Bテストの結果を分析するのに数週間を要していました。 結果をリアルタイムで分析するAmplitudeの機能により、GoFundMeは、実行するテストの数を1か月に2、3から10に増やすことができました。 時間の制約のためにテストするアイデアを選択する代わりに、チームは仮説を立てながらテストできるようになりました。

3種類のA/Bテスト—およびそれぞれをいつ使用するか

従来のA/Bテストの他に、状況に応じて活用できるA/Bテストは3種類あります。

分割URLテスト

ホームページのボタンを微調整することは1つのことですが、まったく新しいページデザインをテストしたい場合はどうなりますか? 分割URLテストは、A / Bテストの概念を採用し、それをより大規模に拡張します。 このタイプのテストでは、完全に別個のURLが作成されるため、Webページをゼロから完全に再設計できます。 次に、実験グループをこの新しいページに集めることができるため、結果を既存のページと比較できます。

分割URLテストと従来のA/Bテストを一緒に使用して、ページのパフォーマンスを最適化できます。 分割URLテストは、問題のページの2つのデザインのどちらが最も効果的かを明らかにします。 そこから、一連の従来のA / Bテストで、CTAコピー、フォントサイズ、画像などの詳細についてユーザーの好みをテストできます。

多変量テスト

このタイプの実験では、複数の変数を含むオプションをテストします。 従来のA/Bテストでは、2つのCTAボタンサイズのどちらが好ましいかを評価できます。 比較すると、多変量テストにはさまざまなCTAサイズ、見出し、画像を含めることができるため、キャンペーンに最適なオプションを多数選択できます。

多変量テストは、多くの資産のうちどの資産が最もパフォーマンスが高いかについての仮定を確認または否定するのに役立ちます。 デザイン要素の特定の組み合わせが、ターゲットベースに最適であると信じているかもしれません。 代替変数を使用してバージョンを作成することにより、他の多くの設計に対して好みの設計をテストして、何が最も効果的かを正直に説明できます。

多変量テストの主な欠点は、変数を追加するたびに、作成する必要のあるアセットの別のバージョンが追加されることです。 5つの異なるCTAボタンの形状、4つのCTAボタンの色、および3つの異なるフォントをテストする場合は、すべてのベースをカバーするために60(!)の異なるテストアセットを作成する必要があります。

マルチページテスト

複数ページのテストは、ワークフローまたは目標到達プロセスの代替バージョンの成功を評価します。 シーケンス内の複数のページにスイープ変更を加えて、元のページに対してテストできる個別のファネルを構築できます。 複数ページのテストは、フローまたは目標到達プロセスのすべてのページから1つの要素を追加または削除して、効果をテストする場合にも適しています。

eコマースWebサイトのチェックアウトシーケンスが次のようになっているとします。

ショッピングカート(A)→支払い情報(A)→配送情報(A)→注文の確認(A)→注文の送信(A)

最初の3ページの[次のステップ]ボタンを動かすと、購入率が向上するのか、それとも低下するのか、興味があります。 理論的には各ページを個別にテストできますが、顧客はこれらのページを個別に体験することはありません。 それらは、あるページから次のページに順番に移動します。

ページを順番にテストすると、実験の結果がより正確になることがわかります。 このため、実験ファネルが次のようになるように、購入シーケンスのバリエーションを作成します。

ショッピングカート(B)→支払い情報(B)→配送情報(B)→注文の確認(A)→注文の送信(A)

A / Bテストの他のバリエーションと同様に、目標は、元の目標到達プロセスに対して、さらには他の反復に対しても、どの目標到達プロセスが最も効果的かを判断することです。 [次のステップ]ボタンの場所をいくつかテストした後、最終的な目標到達プロセスは次のようになります。

ショッピングカート(B)→支払い情報(D)→配送情報(C)→注文の確認(A)→注文の送信(A)

A/Bテストを実施するための鍵

A / Bテストは、UI / UXの設計と製品マーケティングにとって有益ですが、真の可能性を引き出すには、正しく実行および評価する必要があります。 A/Bテストを成功させる秘訣は次のとおりです。

再現性

時々、A / Bテストは、衝動的な決定につながるほどエキサイティングな結果を提供します。 ある企業では、CTAボタンの色を変更するだけで、コンバージョン率が3倍に向上したことがわかりました。 独自のA/Bテストで同様の結果が得られた場合は、このバージョンの広告をすぐに実行することをお勧めします。責任を問われることはほとんどありません。

ただし、テスト結果は、再現可能である場合にのみ有効と見なされます。 同じ結果を何度も達成することで、最初の結果がまぐれである可能性を減らすことができます。 さらに、赤いバージョンをテストせずに青いCTAボタンを使用するキャンペーンを進めると、本当に最高のCTAオプションを使用しているかどうかがわかりません。

ユーザーセグメンテーション

ユーザーセグメンテーションは、A/Bテスト用に特定のユーザーのサブセットを作成するプロセスです。 これらのユーザーグループは、同様の行動特性または人口統計特性の顧客に基づいています。 多くのA/Bテストでは、特定の顧客グループが、顧客に影響を与える変更にどのように反応するかを知りたいと考えています。 このような場合、幅広い顧客をテストすると、ターゲットとするセグメントの結果が実際に薄れる可能性があります。

製品のチャットボットの美的変更を検討していると想像してください。 製品を3か月以上使用している顧客がこの機能を使用する可能性は非常に低いため、A/Bテストに含めることは意味がありません。 代わりに、3か月未満製品を使用したユーザーのセグメントを作成して、デザインの変更が製品を使用するユーザーにどのように影響するかを最もよく理解する必要があります。

Amplitude Recommendationは、将来特定のアクションを実行する可能性が最も高い顧客のコホートを構築することもできます。 これは、過去の行動に基づいてチャットボットを使用すると分析的に予測された新規ユーザーのみで構成されるセグメントを構築できることを意味します。 予測コホートを使用したA/Bテストでは、チャットボットの使用に関心のないユーザーを除外しながら、ターゲットとするユーザーを含める可能性がはるかに高くなります。

テストのテスト

A / Bテストを間違って作成した場合、すべてのテストは無駄になります。 欠陥のあるテストは、ユーザーのセグメンテーションと繰り返しのテストにもかかわらず、意味をなさない結果をもたらす可能性があります。 確かに、顧客は時々予測できない行動をしますが、一般的に彼らの行動にはパターンがあります。

2つのグループを作成し、それらを2つの別々のエクスペリエンスに集中させる代わりに、「A/Aテスト」と呼ばれることもある製品をそれ自体に対してテストします。 理論的には、A / Aテストの結果は、2つのジャーニーの間に変化がないため、非常に類似しているはずです。 結果が歪んで戻ってきた場合は、実験をボルトに分解し、問題が発生している場所を段階的に分析します。

3つの一般的なA/Bテストの間違い(およびそれらを回避する方法)

A / Bテストは、正しく実行されている限り、貴重な洞察を提供します。 誤った結果は結果を歪め、チームが悪いデータに基づいて重要な決定を下すように導く可能性があります。 より一般的なA/Bテストの間違いには次のものがあります。

1.単一のA/Bテストで複数の変数をテストする

A / Bテストは、一度に1つの変数をテストするように設計されています。 AとBの選択肢を1つの変更に限定することで、この特定の変更が最終的な結果の原因であることを確実に知ることができます。

複数の変数を変更すると、テスト結果が解釈できるようになります。 たとえば、3つの美的機能を変更すると、広告Bよりも広告Aの方が良い結果が得られる可能性がありますが、3つの変更すべてがパフォーマンスの向上の原因であるかどうかを知る方法はありません。 個別にテストすると、2つの変更が実際にパフォーマンスを低下させ、3番目の変更がコンバージョン率の上昇に単独で関与していることがわかる場合があります。

自分に有利に働き、物事をシンプルに保ちます。A/Bテストごとに1つのバリエーションに制限します。

2.テストが早すぎる

新しいランディングページを設定したばかりの場合は、A/Bテストをしばらく延期することでメリットがあります。 新しいページの要素をすぐに変更すると、元の反復のパフォーマンスに関する必要なメトリックを収集できなくなります。 ベースラインが確立されていないと、変更をテストするための適切なデータがありません。

3.テストを時期尚早に呼び出す

有望な結果に基づいて、ほんの数日後に成功を宣言したくなるかもしれません。 ただし、より信頼性の高いデータを取得するには、少なくとも2週間はテストを実行することをお勧めします。 曜日や休日のような単純な要素は、偏った結果をもたらす可能性があります。 数週間のテストにより、時間の経過に伴う変更に対する顧客の反応をより現実的に把握できます。

顧客データでA/Bテストを強化する

履歴データ、人口統計データ、および行動データは、世界最大の企業のいくつかによる大規模なA/Bテストで使用されます。 Amazonは、A / Bテストを使用して、強力なレコメンデーションマシンの有効性を判断します。 Netflixは、A / Bテストを利用して、トップ10リストの作成を正当化しました。 AmazonとNetflixの両方がそれぞれの業界で成功を収めていることを考えると、製品管理ツールベルトにA/Bテストを追加する価値があります。

参考文献

- 史上最も驚くべきA/Bテストの24 、WordStream。 2021年7月8日。

- A / Bテストを使用して、Amazon Personalize、AWSによって生成された推奨事項の有効性を測定します。 2020年8月20日。

- A / Bテストとは何ですか? NetflixTechブログ。 2021年9月22日。