Co to są testy A/B? Jak to działa i kiedy go używać

Opublikowany: 2022-01-25Metoda testowania A/B określa, która z dwóch wersji czegoś daje najlepsze wyniki. Często określa się to mianem „testów dzielonych”, ponieważ grupy użytkowników są dzielone na dwie grupy (grupa „A” i grupa „B”) i kierowane do oddzielnych doświadczeń cyfrowych.

Test A/B może pomóc w tworzeniu skuteczniejszych kampanii marketingowych lub ulepszeniu przepływów pracy przy wprowadzaniu produktów. Zmiany w produkcie lub funkcji można testować na małych, podzielonych na segmenty grupach zwanych kohortami, aby zweryfikować skuteczność, jednocześnie minimalizując tarcia.

Testy A/B to ważne i niezawodne narzędzie, które może i powinno być używane w różnych sytuacjach. Menedżerowie produktu, marketerzy, projektanci i nie tylko, którzy aktywnie korzystają z testów A/B, podejmują oparte na danych decyzje, które prowadzą do rzeczywistych, wymiernych wyników.

Kluczowe dania na wynos

- Test A/B pomaga określić, który z dwóch różnych zasobów działa lepiej.

- Testy A/B służą do optymalizacji kampanii marketingowych, poprawy UI/UX i zwiększenia konwersji.

- Istnieje wiele wersji testów A/B do testowania pojedynczych stron, wielu zmiennych oraz całych przepływów pracy i ścieżek.

- Testy A/B powinny być segmentowane, walidowane i powtarzalne w celu uzyskania maksymalnych wyników.

Jakie są korzyści z testów A/B?

Testy A/B odpowiadają na podstawowe pytanie: Czy klienci wolą Opcję 1 czy Opcję 2? W świecie produktów cyfrowych odpowiedź na to pytanie jest cenna w wielu sytuacjach, w tym w dwóch głównych obszarach: poprawie doświadczenia klienta i wzmocnieniu kampanii marketingowych.

Poprawa UI/UX

Dokonane w dobrej wierze poprawki w interfejsie użytkownika produktu mogą mieć niezamierzone konsekwencje, które powodują tarcia dla użytkowników. Możesz zmienić lokalizację karty w swojej aplikacji mobilnej, aby spodobać się nowym użytkownikom, ale przypadkowo sfrustrować istniejących użytkowników przyzwyczajonych do poprzedniego miejsca.

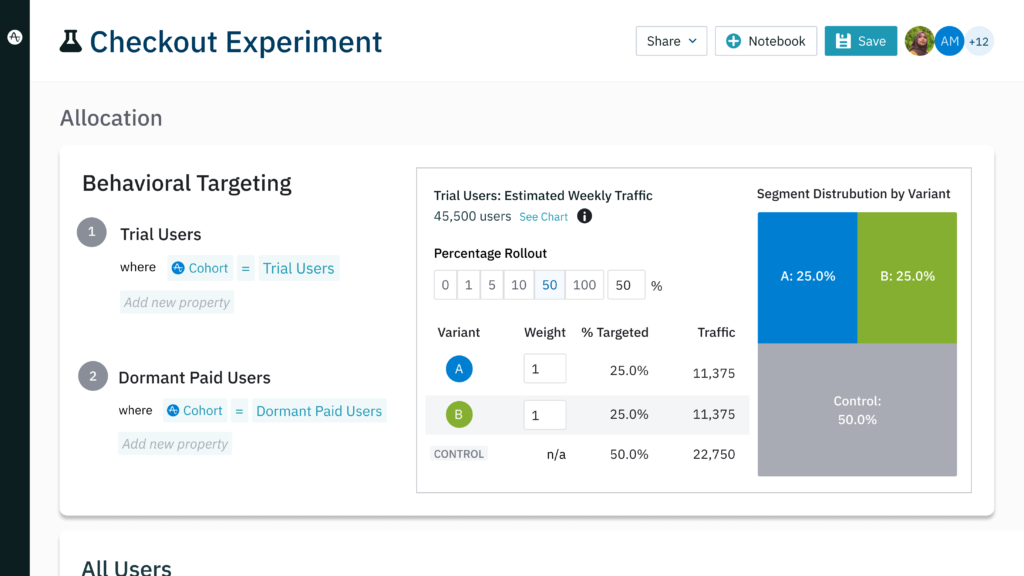

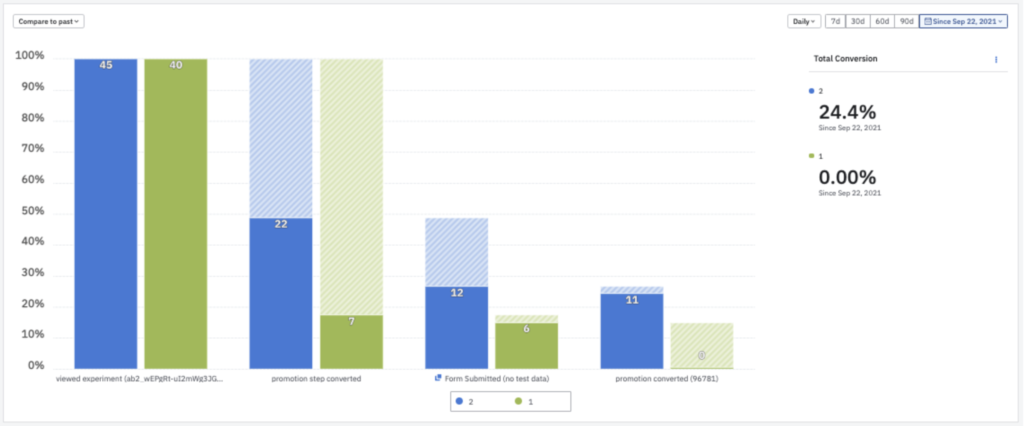

Wykonywanie serii testów A/B minimalizuje ryzyko wprowadzenia gruntownych zmian, testując najpierw mniejszy segment bazy użytkowników. Na przykład możesz utworzyć mały segment nowych użytkowników w Eksperymencie amplitudy i przekierować ich przez nową iterację produktu z przeniesioną kartą.

Jednocześnie możesz utworzyć podobną grupę nowych użytkowników, ale śledzić ich, gdy korzystają z Twojej istniejącej wersji. Pod koniec eksperymentu możesz porównać zachowania grupy eksperymentalnej z zachowaniami grupy kontrolnej, aby zobaczyć, która wersja produktu daje najlepsze wyniki.

Aby zorientować się, jak dotychczasowi klienci zareagują na zmianę w porównaniu z nowymi użytkownikami, należy powtórzyć eksperyment. Tym razem zastąp grupy eksperymentalną i kontrolną segmentami dotychczasowych użytkowników. Przeprowadzając eksperyment wielokrotnie przy użyciu różnych segmentów, zwiększasz szanse, że Twoje zmiany będą napędzać przyjęcie Twojego produktu, a nie wywołać rezygnacji.

Optymalizacja kampanii marketingowych

Testy A/B można wykorzystać do zwiększenia wydajności działań marketingowych. Twoje dane behawioralne mogą ujawnić, że klienci, którzy dokonali konwersji, mogą mieć podobne zachowania lub dane demograficzne. Wiesz, do kogo chcesz trafić, ale drobniejsze punkty okazują się nieuchwytne:

- Jakie komunikaty najskuteczniej napędzają konwersje?

- Na jaką ofertę lub zachętę najlepiej reagują potencjalni lub obecni klienci?

- Czy inny projekt przycisku wezwania do działania generuje więcej kliknięć?

Możesz skonstruować kampanię opartą na swoim doświadczeniu i instynkcie i nadziei na najlepsze, ale to nadal niesie ze sobą ryzyko. Możesz wysyłać e-maile lub płatne posty społecznościowe do właściwych osób, nie trafiając w cel w wiadomości. Kampania może wygenerować wiele konwersji, ale nigdy nie dowiesz się, czy opcje, których nie wybrałeś, przyniosłyby więcej.

Testy A/B identyfikują najlepsze opcje marketingowe, dostarczając wyniki poparte danymi. Seria testów A/B może ujawnić, że użytkownicy lepiej reagują na zielone CTA niż niebieskie lub że oferta bezpłatnego okresu próbnego działa na wyższym poziomie niż jednorazowa zniżka. Ten proces pomaga zminimalizować wydatki, które zostałyby zmarnowane na reklamy o mniejszej skuteczności.

Rzeczywiste przykłady testów A/B

Zwiększenie konwersji strony docelowej

Platforma e-sportowa G-Loot zastosowała testy A/B, aby poprawić współczynniki konwersji strony docelowej, uzyskując spektakularne wyniki. G-Loot przetestował zmiany na swoich stronach docelowych opartych na reklamach i zidentyfikował najlepsze modyfikacje za pomocą eksperymentu amplitudy. Po zmianie stron w celu odzwierciedlenia najlepszego projektu i zmiennych oferty, współczynniki konwersji stron docelowych G-Loot wzrosły z 3% do niewiarygodnych 35%.

Zwiększenie retencji poprzez optymalizację obsługi klienta

NBCUniversal przyjął testy A/B jako sposób na zmniejszenie rezygnacji. Gigant medialny przetestował swoją istniejącą stronę główną dla telewizorów Vizio z nowszymi wersjami. Z pomocą Amplitude firma zidentyfikowała nową stronę główną, która zwiększyła oglądalność w grupie eksperymentalnej o 10%. NBCUniversal przyjął nową stronę główną dla wszystkich klientów, co podwoiło 7-dniową retencję.

Wprowadzanie innowacji poprzez testy A/B

Właściwe rozwiązanie analityczne zachęca do częstszych eksperymentów, co z kolei zwiększa sprawność i napędza innowacje. Zespół GoFundMe potrzebował tygodni na analizę wyników testów A/B. Dzięki zdolności Amplitude do analizowania wyników w czasie rzeczywistym, GoFundMe był w stanie zwiększyć liczbę przeprowadzanych testów z dwóch lub trzech do dziesięciu miesięcznie. Zamiast wybierać pomysły do przetestowania ze względu na ograniczenia czasowe, zespół może teraz testować hipotezy w miarę ich rozwoju.

3 różne rodzaje testów A/B — i kiedy używać każdego z nich

Oprócz konwencjonalnych testów A/B istnieją trzy rodzaje testów A/B, które można wykorzystać w zależności od sytuacji:

Testowanie podzielonego adresu URL

Poprawienie przycisku na stronie głównej to jedno, ale co się stanie, jeśli chcesz przetestować zupełnie nowy projekt strony? Testowanie podzielonego adresu URL wykorzystuje koncepcję testowania A/B i rozszerza ją na większą skalę. Ten typ testu tworzy całkowicie oddzielny adres URL, dzięki czemu możesz całkowicie przeprojektować stronę internetową od podstaw. Grupę eksperymentalną można następnie skierować na tę nową stronę, aby można było porównać wyniki z istniejącą.

Testowanie dzielonych adresów URL i tradycyjne testy A/B mogą być używane razem w celu optymalizacji wydajności strony. Test podzielonego adresu URL pokaże, który z dwóch projektów danej strony działa najlepiej. Stamtąd seria tradycyjnych testów A/B może przetestować preferencje użytkownika, aby uzyskać bardziej szczegółowe informacje, takie jak tekst CTA, rozmiar czcionki lub obrazy.

Testowanie na wielu odmianach

Ten typ eksperymentu testuje opcje, które zawierają więcej niż jedną zmienną. Tradycyjny test A/B może ocenić, który z dwóch rozmiarów przycisków CTA jest preferowany. Dla porównania, test na wielu odmianach może obejmować różne rozmiary wezwania do działania, nagłówki i obrazy, co pozwala określić, która z wielu opcji najlepiej sprawdza się w przypadku Twojej kampanii.

Testy wielowymiarowe są pomocne w potwierdzaniu lub negowaniu założeń dotyczących tego, który z wielu aktywów będzie działał najlepiej. Możesz sądzić, że pewna kombinacja elementów projektu najlepiej sprawdza się w przypadku docelowej bazy. Tworząc wersje z alternatywnymi zmiennymi, możesz przetestować swój preferowany projekt z wieloma innymi, aby uzyskać rzetelne informacje o tym, co działa najlepiej.

Główną wadą testowania wielowymiarowego jest to, że każda dodatkowa zmienna dodaje kolejną wersję zasobu, który należy utworzyć. Jeśli chcesz przetestować pięć różnych kształtów przycisków wezwania do działania, cztery kolory przycisków wezwania do działania i trzy różne czcionki, musisz utworzyć 60 (!) różnych zasobów testowych, aby objąć wszystkie swoje podstawy.

Testowanie wielostronicowe

Test wielostronicowy mierzy powodzenie alternatywnej wersji przepływów pracy lub lejka. Ogólne zmiany można wprowadzać na wielu stronach w sekwencji, tworząc osobną ścieżkę, którą można przetestować z oryginałem. Test wielostronicowy jest również odpowiedni w sytuacjach, gdy chcesz po prostu dodać lub usunąć jeden element z każdej strony przepływu lub ścieżki i przetestować efekty.

Załóżmy, że sekwencja płatności w Twojej witrynie e-commerce wygląda tak:

Koszyk (A) → Informacje o płatności (A) → Informacje o wysyłce (A) → Przejrzyj zamówienie (A) → Prześlij zamówienie (A)

Jesteś ciekaw, czy przesunięcie przycisku „Następny krok” na pierwszych trzech stronach pomaga, czy obniża wskaźniki zakupów. Teoretycznie możesz przetestować każdą stronę osobno, ale klienci nie doświadczają tych stron w odosobnieniu. Przechodzą kolejno od jednej strony do następnej.

Wiesz, że wyniki eksperymentu będą dokładniejsze, jeśli przetestujesz strony w odpowiedniej kolejności. Z tego powodu tworzysz odmiany sekwencji zakupów, aby ścieżka eksperymentalna wyglądała tak:

Koszyk (B) → Informacje o płatności (B) → Informacje o wysyłce (B) → Przejrzyj zamówienie (A) → Prześlij zamówienie (A)

Jak w przypadku każdej odmiany testów A/B, celem jest ustalenie, która ścieżka sprawdza się najlepiej w stosunku do oryginału, a nawet innych iteracji. Po przetestowaniu kilku lokalizacji dla przycisku „Następny krok”, ostatnia ścieżka może wyglądać mniej więcej tak:

Koszyk (B) → Informacje o płatności (D) → Informacje o wysyłce (C) → Przejrzyj zamówienie (A) → Prześlij zamówienie (A)

Klucz do przeprowadzania testów A/B

Chociaż testy A/B są korzystne dla projektowania UI/UX i marketingu produktów, muszą być prawidłowo wykonywane i oceniane, aby uwolnić ich prawdziwy potencjał. Klucze do sukcesu testów A/B to:

Powtarzalność

Czasami testy A/B dają wyniki, które są tak ekscytujące, że prowadzą do impulsywnych decyzji. Pewna firma zauważyła, że zwykła zmiana koloru przycisku wezwania do działania zwiększyła współczynnik konwersji trzykrotnie. Jeśli Twój własny test A/B dał podobny wynik, możesz chcieć od razu uruchomić tę wersję reklamy i trudno byłoby Cię winić.

Jednak wyniki testów są uważane za ważne tylko wtedy, gdy są powtarzalne. Ciągłe osiąganie tych samych wyników zmniejsza prawdopodobieństwo, że Twój początkowy wynik był szczęśliwym trafem. Co więcej, jeśli przejdziesz do przodu z kampanią, która wykorzystuje niebieskie przyciski CTA bez testowania wersji czerwonej, nigdy nie dowiesz się, czy naprawdę korzystasz z najlepszej opcji CTA.

Segmentacja użytkowników

Segmentacja użytkowników to proces tworzenia podzbioru określonych użytkowników na potrzeby testów A/B. Te grupy użytkowników są oparte na klientach o podobnych cechach behawioralnych lub demograficznych. W wielu testach A/B chcesz wiedzieć, jak dana grupa klientów reaguje na zmiany, które na nich wpłyną. W takich przypadkach testowanie szerokiego grona klientów może w rzeczywistości osłabić wynik segmentu, na który chcesz kierować reklamy.

Wyobraź sobie, że zastanawiasz się nad zmianami estetycznymi w chatbocie swojego produktu. Wiesz, że klienci, którzy korzystali z Twojego produktu przez ponad trzy miesiące, są bardzo mało prawdopodobne, aby skorzystali z tej funkcji, więc uwzględnienie ich w teście A/B nie ma sensu. Zamiast tego powinieneś stworzyć segment użytkowników, którzy używali Twojego produktu krócej niż trzy miesiące, aby jak najlepiej zrozumieć, jak zmiany w projekcie wpływają na tych, którzy będą z niego korzystać.

Amplitude Recommend może nawet zbudować grupę klientów, którzy z największym prawdopodobieństwem wykonają określone działanie w przyszłości. Oznacza to, że możesz zbudować segment składający się wyłącznie z nowych użytkowników, którzy zostali analitycznie przewidziani do korzystania z chatbota na podstawie wcześniejszych zachowań. Test A/B wykorzystujący kohortę predykcyjną ma znacznie większe prawdopodobieństwo uwzględnienia użytkowników, na których chcesz kierować reklamy, przy jednoczesnym wykluczeniu osób, które nie są zainteresowane korzystaniem z chatbota.

Testowanie testu

Jeśli źle zbudujesz swój test A/B, wszystkie twoje testy są na nic. Wadliwy test może skutkować wynikami, które nie mają sensu pomimo segmentacji użytkowników i powtarzania testów. Oczywiście klienci od czasu do czasu zachowują się nieprzewidywalnie, ale generalnie istnieje pewien wzór w ich zachowaniu.

Zamiast tworzyć dwie grupy i kierować je do dwóch oddzielnych doświadczeń, przetestuj swój produkt względem samego siebie w tak zwanym „teście A/A”. Teoretycznie wyniki testu A/A powinny być bardzo podobne, ponieważ nie ma różnicy między obiema podróżami. Jeśli wyniki wrócą przekrzywione, nadszedł czas, aby podzielić eksperyment na części i przeprowadzić analizę krok po kroku, gdzie występuje problem.

3 najczęstsze błędy w testach A/B (i jak ich uniknąć)

Testy A/B dostarczają cennych informacji, o ile są wykonywane prawidłowo. Nieprawidłowe wyniki mogą zafałszować wyniki i skłonić zespoły do podejmowania ważnych decyzji na podstawie złych danych. Niektóre z najczęstszych błędów testów A/B obejmują:

1. Testowanie wielu zmiennych w pojedynczym teście A/B

Test A/B jest przeznaczony do testowania jednej zmiennej na raz. Ograniczenie wyborów A i B do pojedynczej zmiany pozwala z całą pewnością wiedzieć, że ta konkretna zmiana była odpowiedzialna za ostateczny wynik.

Zmiana wielu zmiennych otwiera wyniki testu do interpretacji. Na przykład zmiana trzech cech estetycznych może dać lepszy wynik w przypadku reklamy A niż reklamy B, ale nie będzie możliwości sprawdzenia, czy wszystkie trzy zmiany były odpowiedzialne za lepszą skuteczność. Testując indywidualnie, może się okazać, że dwie z tych zmian rzeczywiście szkodziły wydajności, a trzecia zmiana była wyłącznie odpowiedzialna za wyższy współczynnik konwersji.

Zrób sobie przysługę i zachowaj prostotę: ogranicz się do jednej odmiany na test A/B.

2. Testowanie za wcześnie

Jeśli właśnie skonfigurujesz nową stronę docelową, warto wstrzymać się na chwilę z testami A/B. Natychmiastowa zmiana elementów na nowej stronie uniemożliwia zbieranie niezbędnych metryk dotyczących wydajności oryginalnej iteracji. Bez ustalonej linii bazowej nie masz odpowiednich danych do testowania zmian.

3. Wywołanie testu przedwcześnie

Możesz pokusić się o ogłoszenie sukcesu już po kilku dniach na podstawie obiecujących wyników. Jednak najlepiej jest pozwolić testom działać przez co najmniej kilka tygodni, aby uzyskać bardziej wiarygodne dane. Czynnik tak prosty, jak dzień tygodnia lub święto, może przynieść wypaczone wyniki. Testowanie przez kilka tygodni może zapewnić bardziej realistyczny obraz reakcji klientów na zmiany w czasie.

Wzmocnij swoje testy A/B danymi klientów

Dane historyczne, demograficzne i behawioralne są wykorzystywane w masowych testach A/B przez niektóre z największych światowych firm. Amazon wykorzystuje testy A/B, aby określić skuteczność swojej potężnej maszyny rekomendującej. Netflix wykorzystał testy A/B, aby uzasadnić tworzenie swoich list Top 10. Biorąc pod uwagę sukcesy, jakie Amazon i Netflix odniosły w swoich branżach, warto dodać testy A/B do paska narzędzi do zarządzania produktami.

Bibliografia

- 24 najbardziej zaskakujących testów A/B wszechczasów , WordStream. 08 lipca 2021 r.

- Wykorzystanie testów A/B do pomiaru skuteczności rekomendacji generowanych przez Amazon Personalizacja , AWS. 20 sierpnia 2020 r.

- Co to jest test A/B? Blog techniczny Netflix. 22 września 2021 r.